テスラファンのグループThird RowがYouTubeに公開したイーロン・マスク氏へのインタビュー動画第2弾で、テスラ車に搭載されるHW3の新しい情報が語られました。これを受けて、去年6月にEVsmartブログでもご紹介したHW3に関する分析記事の著者が、追加レポートを『CleanTechnica』にアップしました。全文翻訳でお届けします。

元記事:Tesla Autopilot Mystery Solved- HW3 Full Potential Soon To Be Unlocked by Chanan Bos on 『CleanTechnica』

2019年6月、テスラAutonomy Dayの後、SoC(集積回路)上のHW3システムに関する様々な可能性とそのポテンシャルについての詳細レポートを掲載しました。ただ少し専門的でマニアック過ぎたかもしれないので、この記事では同じ轍を踏まないようにしたいと思います。

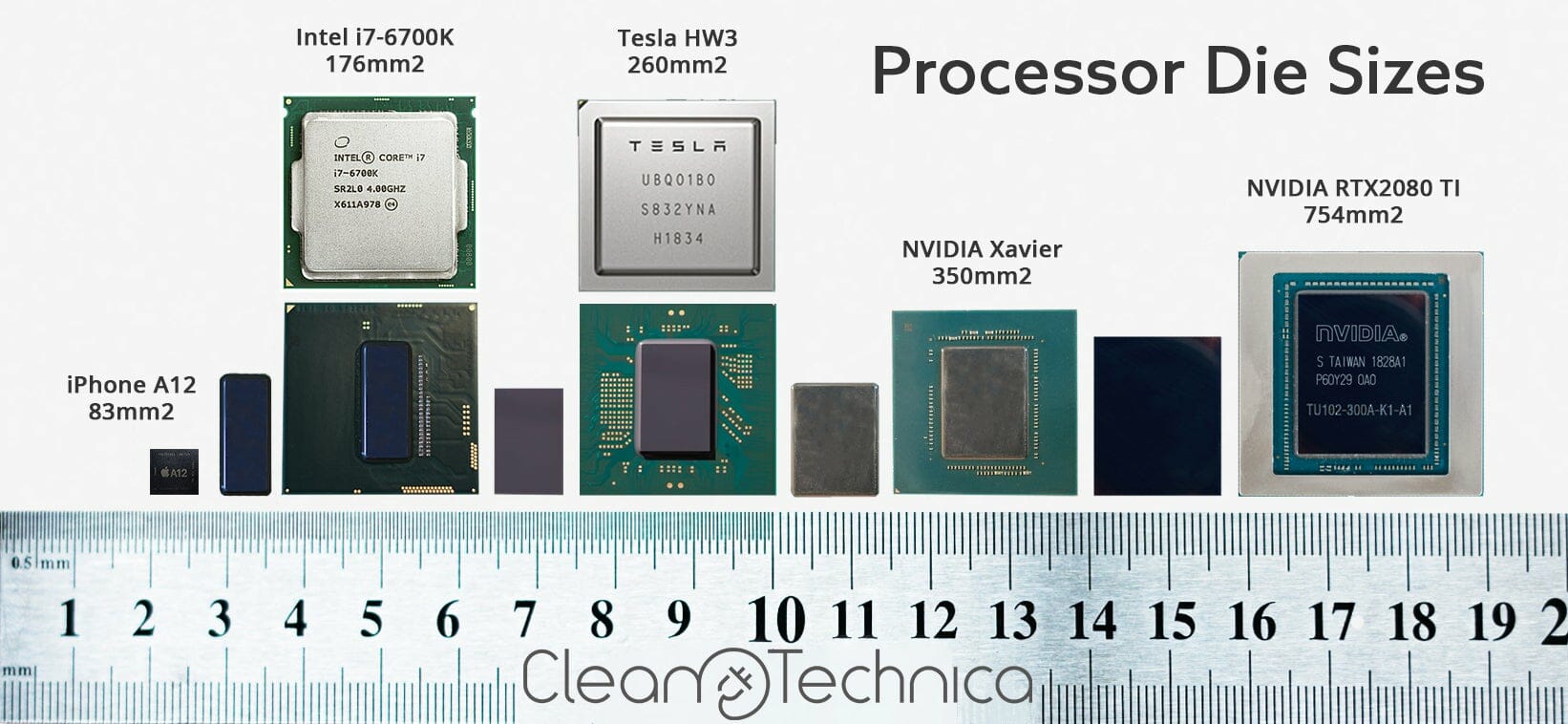

端的に言いますと、HW3は物凄い化物です。旧世代でテスラが使っていたNVIDIAのチップとはかなり違うものです。ですのでイーロンが、HW2からの大幅なパフォーマンス向上はほとんど気付かないレベルであるため、既存の車にHW3を新しく組み込む必要が(その時点では)無いと言ったのにはかなり驚かされました。

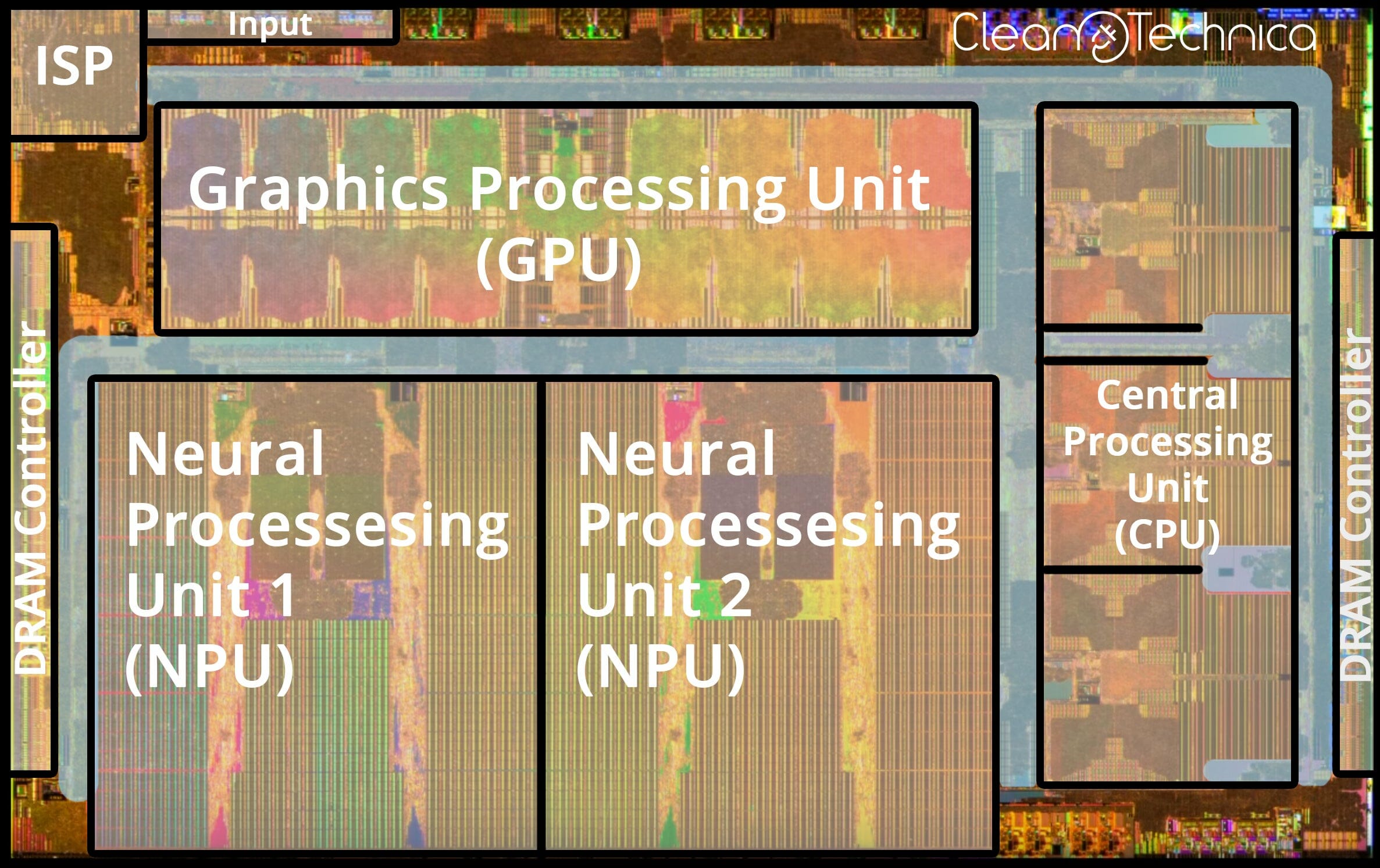

これから書く部分については、下の画像を良く見てから読むことをお薦めします。

さて、2019年下半期の時点ではHW2からHW3に改造してもパフォーマンス向上は見られませんでした。ここから推察されるのは、テスラはHW2用にデザインされた既存の自動運転ソフトウェアをHW3でエミュレーションしたのではないかということです。

エミュレーションを良く知らない人用に説明すると、映画『インセプション』のコンピューター版と言ったところです。スクリーン上でWindows10がAndroidのオペレーティングシステムを動かしているのを考えてみてください。Androidはコンピューター上のプログラムで、オペレーティングシステムではありません。

この場合、HW3はHW2をエミュレーションして既存の自動運転ソフトウェアが動くようにしたのです。ここで1つ問題があり、HW3においてはほとんどのタスクをプロセッサやグラフィックカードではなく、ニューラル・プロセッシング・ユニット(NPUs)上で動かすように想定されていて、直接ソフトウェアのエミュレーションができるように設計されていません。原理上は、グラフィックス・プロセッシング・ユニット(GPU)と中央処理装置(CPU)が合わされば、エミュレーションができます。

しかし、HW3のCPU及びGPU構成要素はHW2より弱いもので、物理的に直接エミュレーションすることができないのです。そこでテスラはNPUs側に課題を移すことにより、解決を図りました。しかし自動運転に関しては、HW3の真のポテンシャルを引き出すために、基本のコードを大幅に書き直す必要がありました。

ちなみにHW3のCPUとGPUは、NPUが処理し切れないちょっとしたタスクを扱うには不必要なパワフルさを持ちます。これは恐らく自動運転機能がHW2からHW3に移行するために選ばれた構成要素で、HW4ではこれよりかなり小さなGPUとCPUが装備され、さらに複雑なニューラルネットワークと高い解像度及びフレームレートを持つカメラのためにスペースを残す、もしくはSoC用に必要なパワーを単純に減らすことになるでしょう。

Third Row Podcastによるイーロン・マスクへのインタビューのお陰で、上に書いた理論と、興味をそそられる新しい情報が確認されました。この数カ月ずっと、テスラは裏で自動運転の基本コードを書き換えていたわけで、もうすぐHW3を搭載する車両にアップデートされる事でしょう。これをHW2とHW2.5自動運転システムの主なアップデートが終わりになる予兆と見ることもできます。

ニューラルネットワーク全体が個として動くようになる

次にこれらの追加されたニューラルネットにより、どのような変化が起こったのかを見ていきます。主に2つの大きな進歩があり、それぞれのシステムとその決定の結びつき、そしてニューラルネットワークが全体で動くようになったことです。言い換えると、車が「Aを見て、Bを見た後に動作を決める」から「Aを見たらBという結果になることを予想して行動する」に変わりました。これに関しては30秒の短い動画を作ってみました。

「何でシノプシスが一緒に動くようにプログラムしておかなかったの?」

「ハードウェアに容量が無かったんだよ。」

360度カメラ

他に変化したのは、自動運転機能がカメラを通してどのように世界を見て解釈するか、という点です。イーロンはかつて人間のドライバーを、スタビライザーに載せられている、スーパーコンピューターに動かされた2つのカメラと表現しました。それぞれ首、脳、目に相当します。

自動運転がどう動くのか、ここで視覚的に想像できるような説明を書いておきます。ある人が机の前に座っているのを想像してください。目の前には6つのスクリーンがあります。彼のタスクはこのスクリーンに映し出される、ある車体の周辺にあるすべての車の位置と軌道を真っ白い紙に描き出すことです……大変な仕事です。

さて、新しい自動運転システムが使用するのは、たった1つの360度カメラになります。たまに頭の後ろに目が必要だ、なんて冗談を耳にしますが、一目で360度を捉え、自分の周りで何が起こっているのか直観的に把握できるのを想像してください。ものすごいことです。これが新しい自動運転システムの動作です。多くのカメラから取ったデータを継ぎ接ぎしていたのを、1つの360度カメラに置き換えたのです。これにより、システムが実際の運転から学習する能力が、飛躍的に向上するはずです。

Third Row Podcastのプレビュー。「テスラ自動運転システムに関しては大きな書き換え作業があった」

Part 2 of Elon's Story starts with a little announcement…

"There's quite a significant foundational rewrite in the Tesla Autopilot system that's almost complete" –– @elonmusk pic.twitter.com/am58oVz6Rb

— Third Row Tesla Podcast (@thirdrowtesla) January 30, 2020

もう一つThird Row Podcastのツイートから。「自動運転に関して2つの大きな進化があった。1つ目は、これまでバラバラだったサブ・システムが統合されたユニットになること。イーロンはこれを、”ニューラルネットがシステムをどんどん飲み込んでいる” と表現した」

終わりに

テスラのHW3は物凄い化物です。これまでに比べて7倍のフレーム数とニューラルネットワークを持ち、プレゼンテーションで言われたようにその使い道は多岐に渡ります。テスラは少しずつSoCリソースを投入してきましたが、もうすぐ既存自動運転機能を書き換え、重要な機能をあと少し追加してリリースし、その上にさらにシステム構築を継続するでしょう。

多くの人がテスラのロボタクシー自動運転ネットワークが10年以内、下手したら4〜5年以内に実現するとは信じていません。私から見ると、彼らは指数関数的進化(飛躍的な進化)やマシーン・ラーニングを見くびっており、HW3が業界の底上げをするだろうことを理解していません。

一つはっきりしておきたいのは、これは世界中でレベル5自動運転が実現化されるという意味ではありません。しかし少なくとも良い道路とインフラを持つ国が1つ実現させれば、他の国もそれに倣うだろう、ということです。

(翻訳・文/杉田 明子)

コメント