『CVPR2021』というコンピュータービジョンのイベントで、テスラのAIチームシニアディレクターであるAndrej Karpathy氏が登壇。テスラが進める完全自動運転への取り組みを解説しました。はたして、テスラはどこまで進んでいるのか。テスラオーナーで翻訳家の池田篤史氏が翻訳しつつ解説します。かなり専門的ながら、興味深い内容です。

※冒頭画像はCVPRウェブサイトより引用。

はじめに

2021年6月下旬に開催されたCVPR(Computer Vision and Pattern Recognition)に、昨年に続きテスラのAIチームシニアディレクター、アンドレイ・カーパシー氏が登壇し、カメラからの入力のみで自動運転機能を達成する取り組みについて解説しました。この記事ではそれに加え、テスラハッカーとして有名なGreentheonly氏にも取材をして、アンドレイ氏が表向き言えないようなことも解説していただきました。

【関連動画】

[CVPR’21 WAD] Keynote – Andrej Karpathy, Tesla

アンドレイ氏のプレゼンはまず、人間のドライバーよりも機械のほうが優れている時代になりつつあるという話から始まります。今はまだ人間のほうが運転が上手な場面が多いですが、人間が注意散漫になったり、ペダルを踏み間違えた際に(完全自動運転の)車が事故を未然に防いだケースも次第に増えています。

次に、アメリカでは現在、主にテスラの従業員で構成される2000人のベータテスターにより、FSD Betaと呼ばれる、完全自動運転により近い運転支援システムのテストが行われていることに触れます。このシステムは高速道路や単調な運転環境だけでなく、交差点での右左折や路上駐車の車両を避けて通るなど、より複雑で実践的な機能が含まれています。なお、「支援システム」のため、運転の責任は相変わらず人間にあり、常に注意を払う必要があります。

カメラオンリーという選択肢

Google系列のWaymoや、最近自動運転Lv 3を達成したホンダ・レジェンドなど、他メーカーの多くがLiDAR(レーザーを使った測距システム)を採用しています。物体との距離を極めて正確に測定できるため、一般的にLiDARがないと安全な自動運転は成立しない、と信じられていますが、これに関してテスラは2019年に「LiDARは可視光付近の波長を使ったセンサーのため、カメラで距離を推定できればLiDARは不要になる。やるならせめて、霧や雨を見通せるレーダー波長にしたほうがよい」と切り捨てています。

さらに、今年の4月27日以降に製造されたアメリカ向けのモデル3およびYはレーダーすら搭載されておらず、先述のFSD Betaもたとえレーダー搭載車であってもレーダーを利用していません。理由としては、レーダーなど他のセンサー類はカメラと比べて情報量が少なすぎること、そしてカメラだけだとセンサーフュージョンをしなくてよいためコンピューターの処理能力を全て画像処理に回せることを挙げています。

テスラは研究の末、単眼カメラで物体までの距離や加速度を高い精度で推定できるようになりました。これには膨大かつ多様なデータに、「これは車、これは縁石」と正確にラベリングがされたデータセットが必要なのですが、幸いテスラには世界中でオートパイロット機能を備えた車が100万台以上走行しており、合計で約80億km分のオートパイロット走行のデータにアクセスできるため、生データの量には困っていません。

参考までにWaymoの自動運転走行データは2009年から累計で2000万kmしかありません。その多くをエンジニアに給料を払って運転させて収集させている一方で、テスラは400倍のデータをオーナーから無料で収集できているため、これは巧妙な仕組みと言わざるを得ません。

集めたデータは本社にある、より処理能力の高いコンピューターで分析します。自動運転中なら車のコンピューターもリアルタイムで運転の判断を迫られますが、録画ファイルであれば時間をかけてゆっくり解析することができ、未来の結果も分かっているため、時間を遡行した推定も可能になります。

プレゼンでは前走車が砂煙や雪を巻き上げ、一時的に見えなくなる状況を例に取り、こうした状況では処理の重いニューラルネットや人間を使って、時間をかけて「見えなくても前走車は突然消えるのではなく、そこにいる」ということを学習させることが説明されました。

下段=雪で前走車が見えなくなってもオレンジの枠が途切れない様子。(YouTubeの基調講演動画アーカイブより引用)

こうして得たデータをユーザーの車に配信し、自動運転には関与させずに裏で実行し(シャドーモード)、ドライバーとコンピューターで判断が異なった場合は、そのデータを吸い上げて改善に役立てるというループを繰り返します。

これによって完成したデータセットは、AIにとって判断が難しいシナリオが100万通り、距離や速度が正確にラベリングされたオブジェクトが60億個、データ量にして1.5ペタバイト(1500テラバイト)にのぼります。これを素早く処理するためにテスラでは、既存の自動車メーカーではありえないレベルのスーパーコンピューターを所有しています。

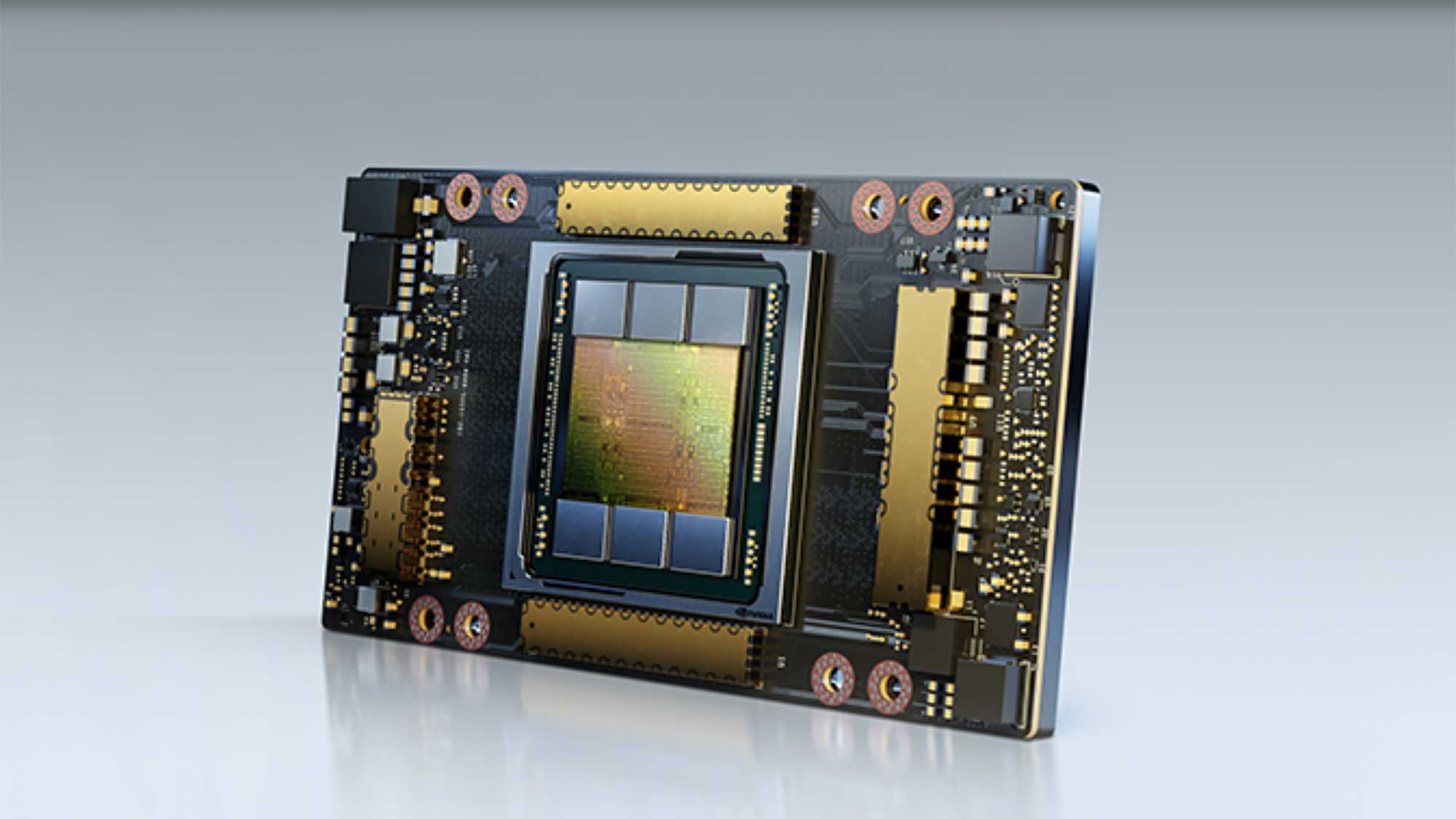

このスパコンはNvidiaの最新鋭GPU「A100」を5760個つなげた構成で、理論的には浮動小数点演算で世界5位の性能を持つとテスラは言っています。また、これよりもさらに高性能なスパコン「Dojo」も開発しています。Dojoの名前の由来は、映画マトリックスでモーフィアス(ローレンス・フィッシュバーン)がネオ(キアヌ・リーブス)にカンフーを教えた仮想空間の「道場」に由来しており、AIがAIを学習させるシステムだと言われています。

Nvidiaの最先端GPU A100シリーズ。(公式サイトより引用)

テスラはバッテリーからインバーター、モーターまでハードウェアを垂直統合で開発していることが取り沙汰されますが、このように、自動運転機能もセンサー環境から学習用データセット、自前のスパコンまで垂直統合されているため、他社には真似することのできないカメラでの測距技術を確立することができたのです。

テスラビジョンの成果

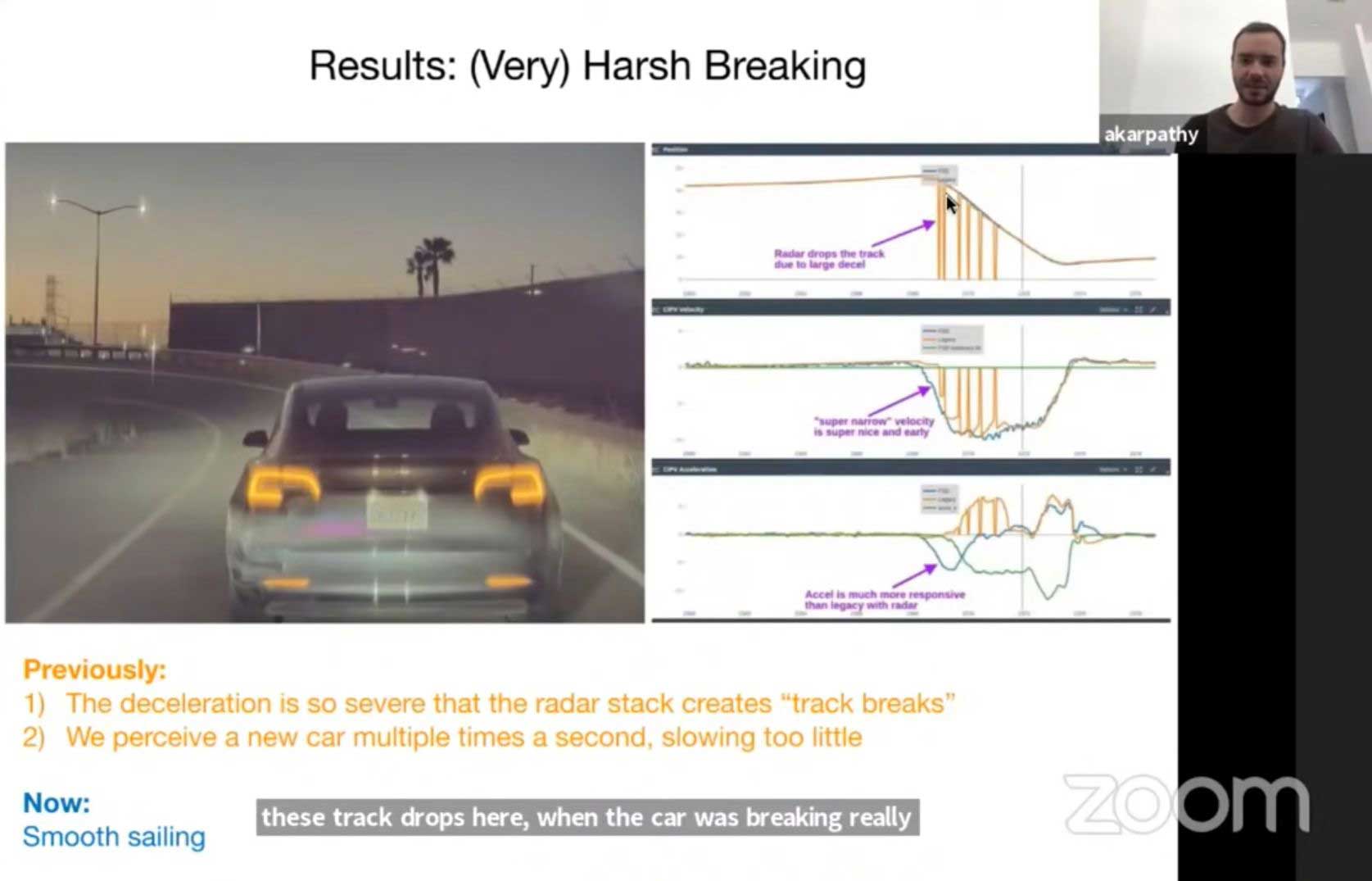

レーダーを排したカメラオンリーのシステムはTesla Visionと呼ばれていますが、以前のシステムと比較して主に3つの改善点があります。まず1つ目が急ブレーキをかける前走車への対応です。

少し見づらいですが、右のグラフの青い線がテスラビジョン、オレンジ線が従来のカメラ+レーダーです。前走車が急減速すると、オレンジ線がガクガクしていることが分かります。これは減速が急すぎて前走車があたかもレーダーから消え、また現れて、を繰り返しているように車には見えるため、自車の減速が不十分になります。一方で青い線は途切れることなく前走車との距離や速度、加速度を捉え続けているため、安定して減速することができます。

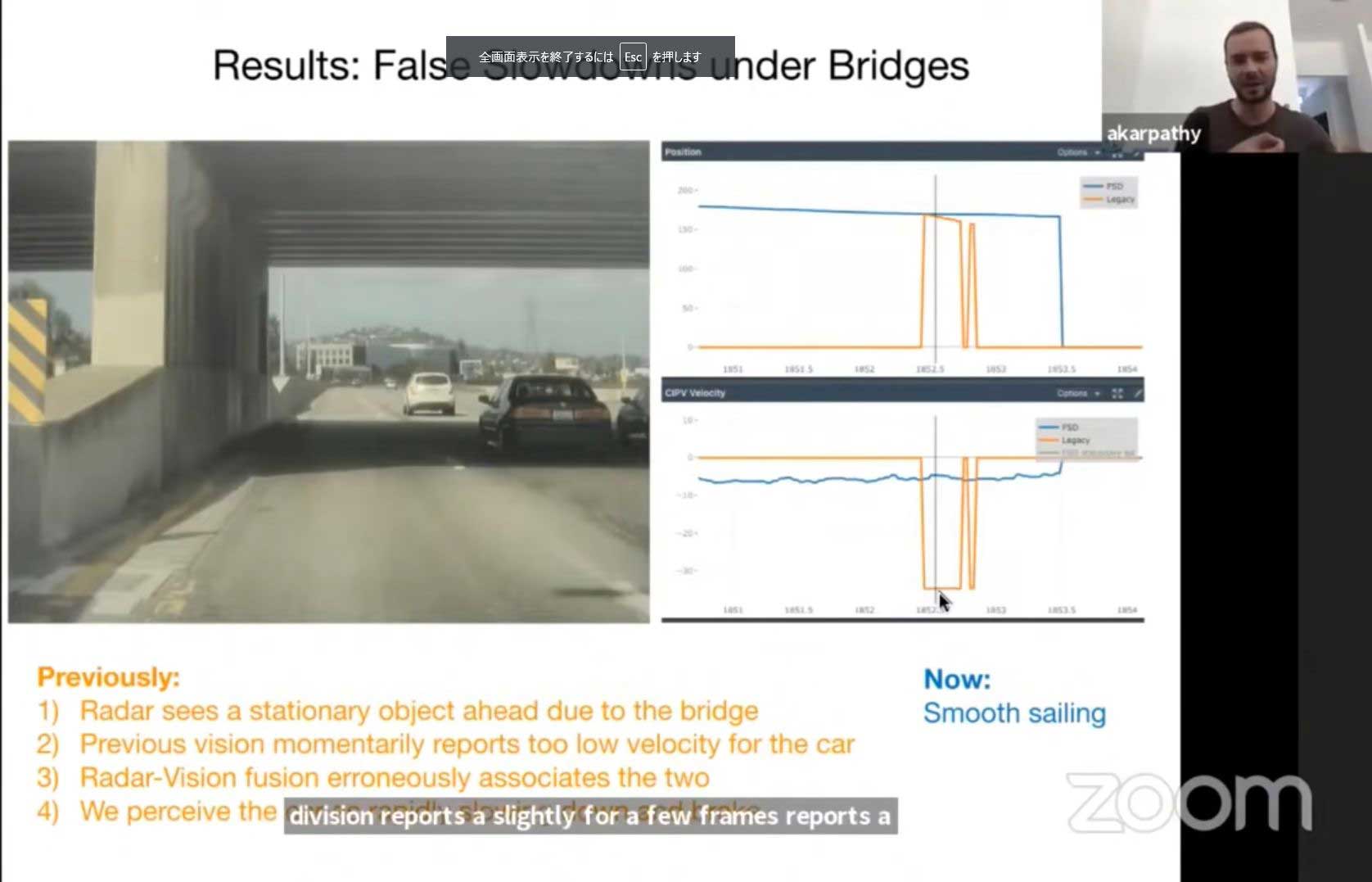

2つ目が、これまでテスラオーナーを悩ませてきた「ファントムブレーキ」を克服したことです。ファントムブレーキとはオートパイロットで走行中に、例えば高速道路で橋をくぐる際に車が障害物だと認識して一瞬急ブレーキを踏む現象を指します。

ファントムブレーキは、レーダーとカメラの両方を使っていることに起因します。これまではテスラに十分な学習用データセットがなかったためカメラでの距離や速度の推定が甘く、レーダーに頼っていました。しかしレーダーは縦方向の分解能力があまりないため、高架道路をくぐる手前で陸橋が頭上にあるのか、衝突コースにあるのか判断しづらいのです。そこにカメラがデタラメな距離情報を瞬間的に吐き出すと、コンピューターはレーダーとカメラの間違った情報を結びつけて、前方に何かあると勘違いします。

テスラビジョンではカメラの測距精度が高く、高架道路に衝突しないことも画像から明白なため、ファントムブレーキは発生しません。下図のグラフは先ほどと同じ色分けですが、青い線はグラフに急激な変化がなく、オレンジ線は幻影(ファントム)を誤認識していることが分かります。

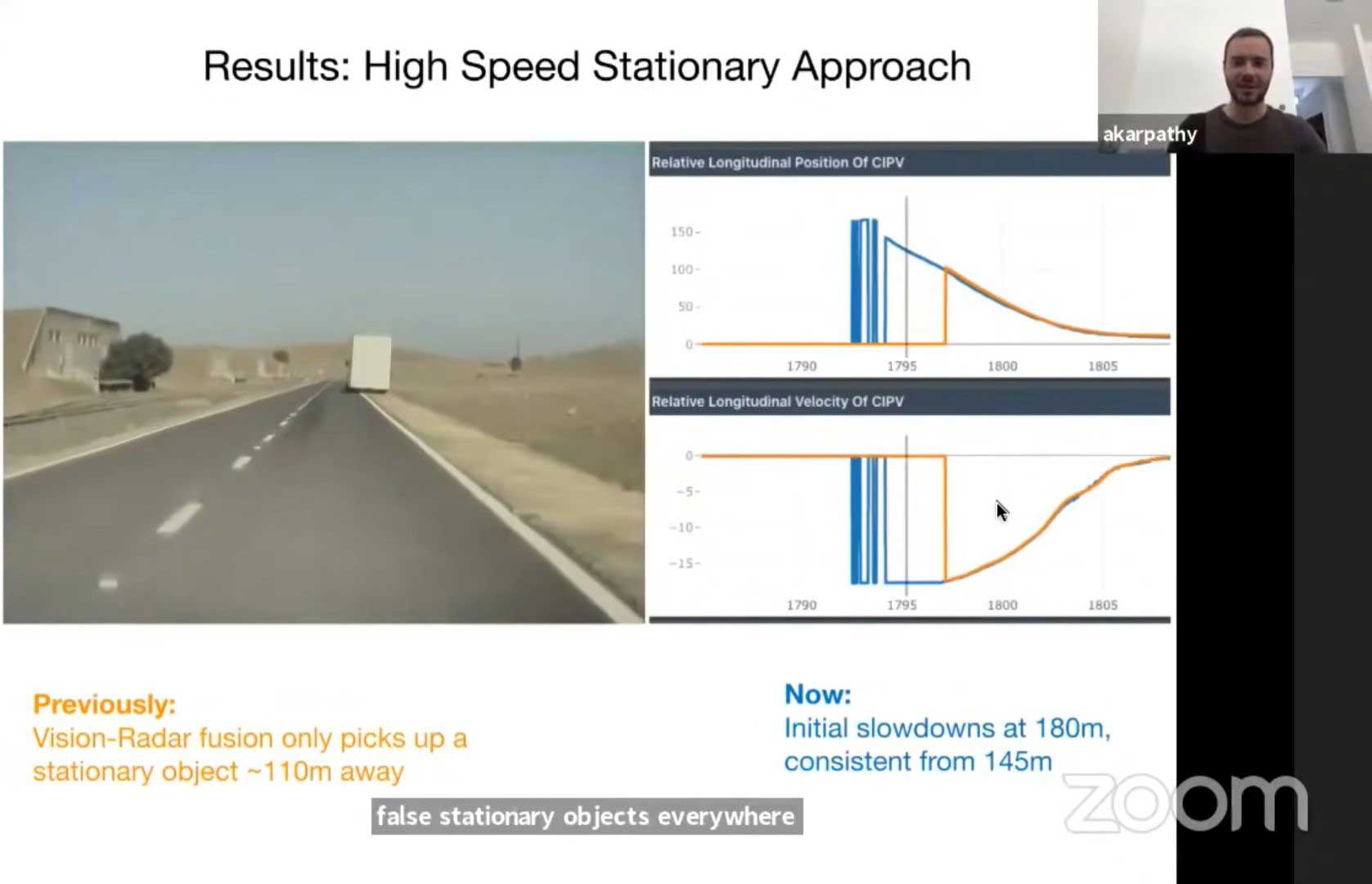

3つ目は逆に本当に前方に障害物があるケースです。ここでは路肩にトラックが停まっているのですが、レーダーとは常に些細なことでも「前方に障害物が!」と警告を出してきます。そのため、自動運転コンピューターはカメラ信号の中に、本当にそれに対応する障害物がないかを探し続けます。この時、カメラが前方のトラックを認識するのに時間がかかると、下図のグラフのように、オレンジ線の山の立ち上がりが遅れます(=ブレーキが遅れます)。テスラビジョンでは180m手前から徐々に減速を開始し、145m手前ではっきりとトラックを認識して一貫したブレーキングを行います。

テスラビジョンをアップデートで配信してから2400万km分の走行データ(内、オートパイロット走行は270万km)を収集していますが、未だ事故は起きていません。

もちろん完璧なシステムなど存在しないため、いつかは事故を起こすでしょうけど、以前のシステムは約800万kmに1度事故を起こしており、それよりは安全であるとテスラでは信じています。こちらのページで四半期ごとのテスラ車の事故データが開示されるので定期的に確認したいと思います。なお、2021年Q1の時点で既に人間の約10倍安全という結果が出ています。

Greentheonly氏の見解

Greentheonly氏は正体不明のホワイトハットハッカーで、アメリカ在住のロシア人であること、モデルXを乗り継いでいることぐらいしか情報がありません。テスラ界隈では古くからツイッターに情報を投稿しており、その内容はファンでもアンチでもなく、中立な立場からのコメントです。今回独占インタビューにお答えいただきましたが、あくまで一個人の意見としてご理解ください。

EVsmart(以下、E):レーダーがなくて本当に大丈夫なのですか?

Greentheonly(以下、G):いや、実は人間が運転している時に重要な役割を果たします。視界が悪いときに警告を出してくれるでしょう。自動運転では視界が悪いと己の能力を過信することなく安全な速度まで減速するため、レーダーはそこまで重要ではありません。

E:テスラがもうすぐFSD Betaを一般にも公開するようですね。自動運転Lv5はもうすぐ実現すると思いますか?

G:テスラは「もうすぐだ」と期待を煽りつつ、恐らく社内ではまだまだ道程は長いと思っているのではないでしょうか。現在のAIは与えられたタスクを上手くこなすことができますが、背景情報を理解できる汎用的な知能がありません。例えばこの例を見てください。テスラ車は信号を判断する基準の一つとして、仰角と光源の大きさを利用しています。そのため、正面に満月がちょうどよい位置に出ていると、それを黄信号と認識します。

Hey @elonmusk you might want to have your team look into the moon tricking the autopilot system. The car thinks the moon is a yellow traffic light and wanted to keep slowing down. 🤦🏼 @Teslarati @teslaownersSV @TeslaJoy pic.twitter.com/6iPEsLAudD

— Jordan Nelson (@JordanTeslaTech) July 23, 2021

E:テスラがオフラインでデータセットをトレーニングしていますが、それでも難しいですか?上記の例では、しばらく走行しても一向に信号に近づかない、もしくはカーブを曲がったら真正面にいた月が別の位置に移ることから、時間を遡行して「月ではない」と学習できないですか?

G:効果はあるでしょうが完璧ではないです。「この標識/信号は私に対するものか」というのは難しい課題です。

E:では汎用的な知能はいつ実現しそうですか? 私が調べたところ、楽観的な人で6年、悲観的な人で15年先だと言っています。

G:私も5年以上先、恐らく10年~20年かかるのではと思っていますが、この世界では5年以上先のことを論じるのはあまり意味がありません。誰かが突然ひらめいて一気に物事が解決することだってあります。そして、グロい話ですが、モルモットなどの脳を利用した研究のほうが早く実を結ぶのではないかと思います。

E:リアルに「…スケテ…タスケテ」と聞こえてきそうな話ですね。少し話題を変えて、テスラのスパコンについてはどう思われましたか?

G:浮動小数点演算で世界5位は眉唾ですね。あの機材の能力を全部足し算したら5位と同等、ということだと思います。実際にはひとつのクラスタとして全てが上手くつながっているかが重要で、Top 500に正式に認めてもらう必要があります。つなぎ方次第で機材を活かすも殺すも決まってくる。

E:なるほど、では日本時間の8月20日に開かれるTesla AI dayでは、Dojoの各部がうまく統合されていて、本当に世界トップクラスの性能を発揮するのか、そして「汎用的な知能」にどのように到達するつもりなのか、そのあたりが見どころということですね? 貴重なご意見ありがとうございました。

おわりに

「テスラでは安全を何よりも優先している」と常々言っているイーロン・マスクですが、レーダーを廃止することで発生するリスクを上回るほど今回のカメラオンリーという選択肢に自信を持っているということなのでしょう。もちろん、まだ完成の域には達していないでしょうけど、果たしてこれが正しいアプローチなのか、今後も推移を見守っていきたいと思います。

(文/池田 篤史)

コメント

コメント一覧 (8件)

状況を認識出来る(意識)コンピュータの出現には 2045年のシンギュラリティー迄 待たねばならんと思いますね 数年では無理でしょうね

自分はクルマの運転が好きなので、自家用車に欲しいのは、人間の見落としや誤認識・誤操作時の危険回避機能と、(一般道でも積極的に使える)アダプティブ・クルーズ・コントロール機能です。これらをできるだけ安価に、全車標準装備して頂きたい。

※目的は、事故防止と運転者の疲労軽減。

商店街・住宅街などの路地は、当面、クルマ任せでなく自分が運転すべきだと強く思う!

完全自動運転車は個人が所有するものではなく、無人タクシーとして公共交通(もしくはシェアリングサービス)用として発展するのではないだろうか?

一方で、全国の物流を担う大型トラックのターミナル間運行(とくに高速道路、自動車専用道路)は、路車間/車車間通信を併用した完全自動(無人)運転を期待したい。

※話はずれるが、都市部の新交通システムでは完全自動(無人)運行が普及しているが、新幹線などの長距離鉄道も、完全自動(無人)運行の方がBetterなのでは?という気がしている。

門外漢なので勝手なことを言いますが、現在の自動運転の方向性、つまりセンサーから得られたビックデータをAIを駆使して、車を人間に近い、あるいは人間よりも優れた存在にする方向性は間違っていると思います。ビックデータは過去のデータにすぎないし、カメラのデータは光の集合にすぎません。そこから、何らかの判断をAIによって導き出しても、世界をすべて再現することはできません。新しい現実に遭遇した場合、どうしても現実の世界に近い過去のデータを参照するしかないからです。その時点で推測であり、近似にすぎません。その小さな違いが事故に結びつくかもしれないし、誤ったルートに導くかもしれない。いくら技術が進んでも、世界を再現することは不可能だと思います。

私はAIを自動運転に採用することは反対です。AIのような曖昧な判断ではなく、確実なデータで制御してほしい。車車間通信というものがありますが、車だけでなく、環境や人間がそれぞれのの位置や大きさ、加速渡などをお互いに通信することで全体が協調するようなシステムにしてほしいと思います。そのためには、すべての車や人、環境にIoTのような通信機器を設置することが必要になります。人であればスマホに組み込むことも可能だし。街中なら信号に組み込むこともできます。また、ドライブレコーダーに組み込めば、機能がもともとない車に搭載することもできます。AIはうまく動いたとしても人間としては何か気持ちが悪いし、確実に安全でないものに自分の責任を委ねることはできません。人間が責任を持てるシステムを構築してほしいと思います。

seijima 様、コメントありがとうございます。

「確実なデータで制御」のアルゴリズムの部分も、過去のデータに基づいて作られているのではないでしょうか?新しい状況が発生すれば、それらに対応するアルゴリズムがなく、無策のうちに事故を引き起こす可能性があるのでは?

アルゴリズムによる制御をソフトウェア1.0、深層学習によるAI制御をソフトウェア2.0とします。

ソフトウェア1.0の品質は、アルゴリズムの網羅性と完全性である程度決まります。今我々が直面していることは、自動運転というアプリケーションにおいて、この網羅性(上で上げた例ですね)と完全性が実現できないという現実にあるんです。ソフトウェア1.0を作るのは人間ですから完全ではなく、特に、定義されてないことに対しては無策です。

しかしソフトウェア2.0を作るのは人間でなくデータです。もちろん完全ではないのですが、少なくとも、定義されていないことに対しても、過去のデータを基にある程度の判断が可能。事故の規模を減らすことが可能になるとお考えになってはいかがでしょうか?

>車や人、環境にIoTのような通信機器を設置

この機器は、三次元空間内で、正確に位置と、加速度と方向を示す必要があります。

しかしそれが可能でしょうか?例えばビルの陰・トンネル内で正確な位置情報がcm単位で検出できるでしょうか?

非常にゆっくり動く動物はどうでしょう?IoTが首輪についていても加速度がゼロと評価されるかもしれません。

その地域がちょうど通信網のあまり調子のよくないところで、高速に動いている対象物があるのに、データ通信のレイテンシー(送ってから帰って来るまでの連絡にかかる時間の片道分)が100msを超えたら、1秒に5回しかデータを受け取れません。

高精細地図には載っていない、見たことのない障害物が地面に落ちていたらどうですか?大きな穴や大きなビニール袋などです。

ソフトウェア1.0では、どう頑張っても、ある程度整然とした交通環境でしか運転ができないと思います。例えば東京にオリンピック用のピンクの通路がありますよね。あそこは歩行者はほとんど入れないし、自転車も入らず、曲がる方向も交差点も決まっています。これらの条件をしっかり限定することで、ソフトウェア1.0でも安全に自動走行させることができます(すみません。オリンピックの自動運転車はソフトウェア2.0かどうかは知らないのですが、たとえとして挙げています)。

ソフトウェア2.0は究極の回答ではないと私も考えています。しかし、こと一般道も含む自動運転に関していえば、現時点でソフトウェア2.0を採用せずに、自動運転を実現している会社・グループは皆無です。Waymo、モービルアイ、テスラ、そしてcomma.aiのようなベンチャーもすべて、ソフトウェア2.0を用いています。Waymoもモービルアイもテスラも、基礎となるデータの収集に命を懸けており、三社ともこの巨大なデータを処理できるスーパーコンピューターを開発・所有しています。

自動運転は、完全自動運転とそれ以外ではまったく違うと思います。完全自動運転になると運転者は不要になります。そうなると人間は多大な自由を手にします。運転操作から解放されるし、免許を持たない人でも車に乗れるようになる。そんな完全自動運転車が事故を起こした場合。当然自動運転に原因を求めると思います。

そうなったときソフトウェア1.0ならば、プログラムのこの部分の設計ミス、不具合が原因で事故が起こったと検証できると思います。しかし、深層学習で知識を得たAIでそのような原因の究明はできるのでしょうか。深層学習の中身はグラックボックスで、人間が過程をたどることはできないような感じがします。原因がわからなければ、対策もできません。仮に人が死ぬという重大事故が起こった場合、完全自動運転システムの動作に原因があるとわかれば、使用不可になるかもしれません。また販売も停止されるでしょう。

リスクが小さければ、AIは有効な技術だと思います。しかしリスクが大きい場合、その社会的損失は多大になります。これに対してどう対処するかが問題だと思います。

seijima様、再度の、深い洞察のコメントありがとうございます。仰ることは理解いたしましたし、その通りだと思います。既存の概念では、その考え方が正しいですし、法もそのように作られていると思います。

しかしながらご指摘のように深層学習を用いたソフトウェア2.0では、原因の究明は簡単ではないと考えて良いと思います。この場合、当該事故の補償はやはり行われるべきですし、当該事故データや、似たようなヒヤリハットの事例を読み込ませて学習させ、再発を予防することは行われるでしょう。

でもそれで良いのではないでしょうか?

犠牲になった方にはもちろん申し訳ないのですが、数億キロ、もしくは数兆キロを安全に運転できるソフトウェアなら、たまたま事故を起こすことは致し方ないのです。

ソフトウェア1.0は2.0より完璧、完成度が高いのか?決してそんなことはないんです。ソフトウェア1.0は開発する人の能力の限界が性能の上限。その方は、1億キロを安全に無事故で運転できるでしょうか?実際に、1億キロのシミュレーションを通過できるソフトウェア2.0の方が、命を預けて安全なのです。

非常に面白い記事ありがとうございます。

人間だったら「陸橋があって下がくぐれる」みたいなことは、常識としてすぐに認識できそうなのですが、ニューラルだけでやろうとするとまだ難しいのかもしれませんね。

基本的に距離センサーよりもカメラの方が解像度も高く、色情報もあるので、遠方の物体の認識には適しているかも…とは思っていたのですが、夜間の物体の認識はどうやってるのか、ちょっと気になります。赤外線カメラみたいなものも搭載しているのでしょうかね…

テスラの自動運転だと、満月を信号と間違えたりする事象も報告されていたりして、そういった問題も地図情報との連携などができていれば、「ここらには信号機はないはずや」といった確率的な推論が可能なはずなのですが、テスラはとにかく画像だけでやろうとしているのかな…

まあ、こうした細かな問題が出てきて、一個一個 Fix していけば…という状況になりつつあるのは、良いことのように思います。これからが楽しみですね。

「Tesla AI chief explains why self-driving cars don’t need lidar」

By Ben Dickson -June 28, 2021

https://bdtechtalks.com/2021/06/28/tesla-computer-vision-autonomous-driving/

の直後にある読者10人のほぼ全員の嘲笑が全てです。日本人はテスラと言う幻想に踊らされているだけです。

Dojoの責任者がテスラを退社したのも当然です。

参考文献

「テスラのスパコン「Dojo」責任者退社、自動運転技術に痛手か-関係者」

https://www.msn.com/ja-jp/money/other/ar-AA1lacJo

スパー・コンピュータが実現できるのは、有限個の要素から近似できる可算無限個の創造です。可算無限個からなる集合の代表格は整数や有理数です。具体的に説明すれば、スパー・コンピュータは、将棋の名人、藤井聡太に勝利できます。その理由は、将棋のマス目が、高々有限個の81個だからです。スーパー・コンピュータでなくとも、81の可算無限乗=可算無限のあらゆるパターンを追跡して、藤井聡太名人を打ち負かす方法を迅速に見つけることができましょう。

一方、スパー・コンピュータであっても、非可算無限個の要素からなる創造に対しては決して肉薄することはできません。非可算無限個の集合の代表格は実数です。

スーパー・コンピュータDojoが膨大な情報を集めて、高度なアルゴリズムを作成して、交通事故を避ける

そんなことは決して実現できません。その理由も明白です。事故は高々可算無限あるいは可算無限個の原因から起こるのはないからです。大体、アルゴリズムは端的に言えば、yes、noを有限回繰り返すだけです。それで事故が防げる?

端的に説明すれば、あなたが乗車する車を目掛けて、

・霧の向こうから秒速1000メートルの速さで怪鳥が飛んでくる

・反対車線の車が突然車線をはみ出して突進してくる

このような危機は、果たして有限個あるいは可算無限個の原因から決定できますか?

まず、どんな物体があなたの車を目掛けて突進してくるのかが不明です。怪鳥、車、岩、隕石、はたまた未知の物体?その場合、時速何メートルで突進してくる?どんな方角からどんな曲線を描きながら突進してくる?

事故は不測の事態から起こるのです。スーパー・コンピュータといえども、0と1の2進法で情報を処理するのです。初めから、非可算無限に近似することは不可能なのです。万が一、Dojoが数億もの交通事故の映像を分析したところで、事故は千差万別であって、同じ事故など一度として起こらないのです。

今現在、スーパー・コンピュータで追跡できる最高傑作は、天気予報や地震予報くらいではないでしょうか?膨大な情報量(高々可算無限個がキー)をスーパー・コンピュータに学ばせて、「似たような事変が起きた際には」スーパー・コンピュータが明日の天気予報を当てることも少なくないかもしれません。東京大学名誉教授の村井俊治先生は、地震を、国土地理院が全国約1300か所に設置した電子基準点のGPSデータなどを使って地表の動きを捉え、1週間ごとの上下動の「異常変動」、長期的な「隆起・沈降」、東西南北の動きの「水平方向の動き」という主な指標を総合的に分析している(高々有限個の指標の検査がキー)。

参考文献

「予測の精度が高まるMEGA地震予測 2023年に警戒すべき4つのゾーン」

https://www.news-postseven.com/archives/20230103_1824318.html?DETAIL&from=imagepage_f-1-2

そして、何よりも、イーロン・マスクは、テスラはカメラだけで完全自動運転を実現と吹聴しながら、2024年になってLiDARを大量購入しているのでしょうか?

参考文献

「LiDARは「馬鹿のやること」なのに、なぜテスラはLiDARメーカーの最大の顧客なのでしょう?」

https://lowcarb.style/2024/05/10/tesla-is-lidar-manufacturers-largest-customer/

「テスラ、「自動運転の松葉杖」呼ばわりしたLiDARの購入発覚!」

https://jidounten-lab.com/u_47281

そして、イーロン・マスクは、ロボタクシー事業を米国ではなくて、中国とヨーロッパで始めると嘯くのでしょうか?

参考文献

テスラ、FSD(完全自動運転)を欧州・中国で展開。2025年初頭までに

https://evcafe.jp/article-20240906-tesla-fsd-roadmap/

その理由も明白です。

アメリカ合衆国の各州には運転免許センターに相当する施設として「Department of Motor Vehicles(DMV)」があります。DMVは公道の運転許可や運転免許証の更新を管理しています。自動運転に関連する資格試験についても「公文書」として公開しています。

参考文献

「Autonomous Vehicle Testing Permit Holders」

https://www.dmv.ca.gov/portal/vehicle-industry-services/autonomous-vehicles/autonomous-vehicle-testing-permit-holders/

アメリカ合衆国の各州には運転免許センターに相当する施設として「Department of Motor Vehicles(DMV)」があります。DMVは公道の運転許可や運転免許証の更新を管理しています。自動運転に関連する資格試験についても「公文書」として公開しています。これは自動運転走行試験許可証を保持している企業の一覧です。

この文書には

・Permits Holders(Testing with a driver)

・Permits Holders (Driverless Testing)

・Permits Holders(Deployment)

の3つのカテゴリがあります。

「前者」はドライバーが同乗して公道を試運転する資格試験に合格した企業を示し、「中者」はドライバーなしで公道を試運転する資格試験を合格した企業、「後者」は前二者にも該当しおり、自動運転車の開発と公道での試運転を行う企業や団体に対して発行される許可を指します。「後者」の許可を持つ企業は、タクシー事業を商用サービスとして展開することを認可された企業です。

「Permits Holders(Testing with a driver)」➡テスラ社の名称あり

(運転手が同乗して、公道を試運転することが認可された企業)

には、テスラ社の名称がありますが、

「Permits Holders (Driverless Testing)」➡テスラ社の名称なし

(運転手が同乗せずに、公道を試運転することが認可された企業)

「Permits Holders(Deployment)」➡テスラ社の名称なし

(タクシー事業を商用サービスとして展開することが認可された企業)

の後二者には、テスラ社の名称はありません。

つまり、イーロン・マスクは、10月10日のロボタクシー事業の発表を誤魔化すために、

中国とヨーロッパでFSDを実施する

とその場凌ぎの言い訳をしているのです。大体、DMVが未だにテスラ車を公道で自動運転レベル4(=運転手なし)で試運転することを許可しないのは、未熟な自動運転レベル2の技術しかないテスラ車を野放しにするのが、

危ない

からです。それもそのはず、テスラは2023年9月12日に、この資格試験を受験していますが、DMVは

テスラに不合格

の烙印を押したのです。

テスラ社がDMVによる資格試験を受験も不合格になったことに対する証拠は、

参考文献

「テスラが投入する自動運転タクシーは、ウェイモより数年遅れている」

https://wired.jp/article/sz-on-self-driving-waymo-is-playing-chess-while-tesla-plays-checkers/

特に、この文献にある

「テスラはソフトウェアの準備が整っていないため、運転席に誰もいない無人走行のテストを開始していない。」

「The Dawn Projectによるテスラの完全自動運転無料トライアルに関する公共広告」の動画の50秒にある

「テスラは2023年9月12日にDMVの資格試験を受験するも不合格」

https://www.youtube.com/watch?v=d2apytqLh-U

にあります。

私が声高に主張したいことは、

イーロン・マスクはロボ・タクシーを今直ぐに実現できるかのように吹聴していますが、

「DMVの自動運転レベル4(=無人)で公道を試運転することが許可される資格試験に合格してから、そのように公言すべきである」

ということです。

イーロン・マスクの勝手気ままな主張を真に受けたら酷い目に遭います。私は、日本のメディアもテスラに投資する日本人も、イーロン・マスクとテスラを現実離れして過大評価していると結論付けています。

Google率いるWaymoやGM率いるCruiseもDMVの後二者の資格試験に合格したからこそ、無人タクシー事業を営むことが許されているのです。なお、Cruiseの名称がDMVの公文書の後二者に名称がないのは、

「カリフォルニア州がCruiseの自動運転車両配備と無人運転試験の許可を即時停止」

https://gigazine.net/news/20231025-dmv-immediate-suspension-of-cruise/

が原因です。

なお、勘違いされがちですが、WaymoもCruiseも

自動運転レベル3もしくは自動運転レベル4

が認定された企業ではありません。あくまでも「試運転の一環」として

「公道での自動運転レベル4での試運転が認可」

されているだけなのです。

国際基準に則って、自動運転レベル3が認定されたのは、世界広し、といえども、

・ホンダの「レジェンド」(100台限定販売)

・メルセデス・ベンツの旗艦車種「Sクラス」とセダン「EQS」(世界初の量産販売)

しかありません。自動運転レベル4以上を認可された車両は存在しません。