2022年9月30日(現地時間)に開催されたテスラ「AI Day 2022」。テスラオーナーの翻訳家である池田篤史氏によるレポートを3回に分けてお届けします。Part.2では、完全自動運転に関するマニアックなプレゼンテーションを、できるだけわかりやすく解説します。

【関連記事】

テスラ「AI Day 2022」翻訳&解説レポート【Part.1】人型ロボットのお値段は?(2022年10月7日)

テスラ「AI Day 2022」翻訳&解説レポート【Part.2】完全自動運転の現在地とは?

完全自動運転技術の進化をマニアック解説

テスラではFull Self Driving(Beta)という一般ユーザーを巻き込んだ完全自動運転のテストプログラムがあり、今では北米を中心に約16万人が参加する巨大プロジェクトに成長しています。AI Day 2022では、FSDを構成するパーツごとにこの1年間でどのような改善を行ってきたか超マニアックに解説されていました。

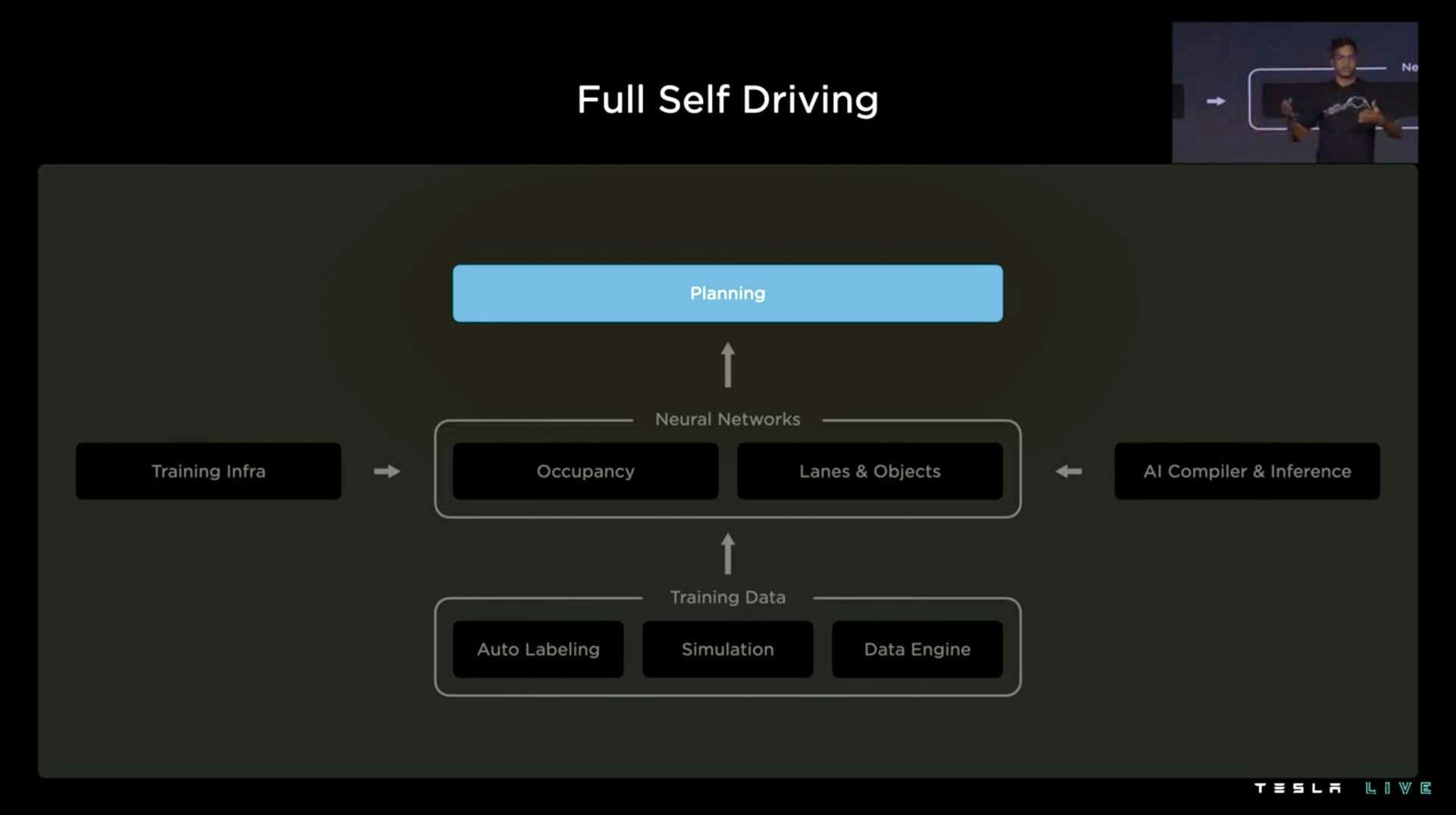

まずはFSDの構成を見てみましょう。ここはFSDの目次のようなページで、今どの部分について話しているか一目でわかります。では早速一番上のPlanning(経路計画)から見ていきましょう。

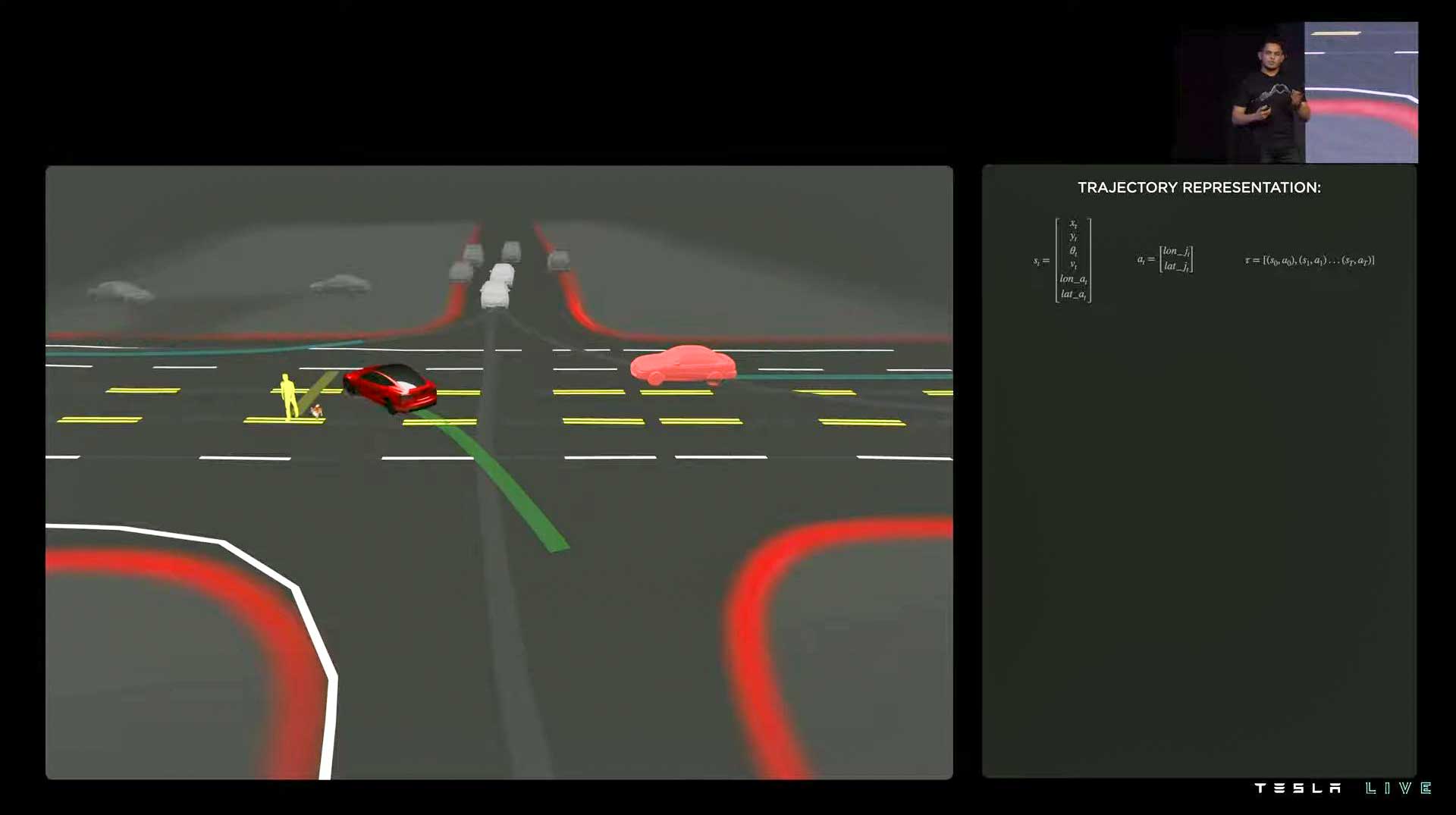

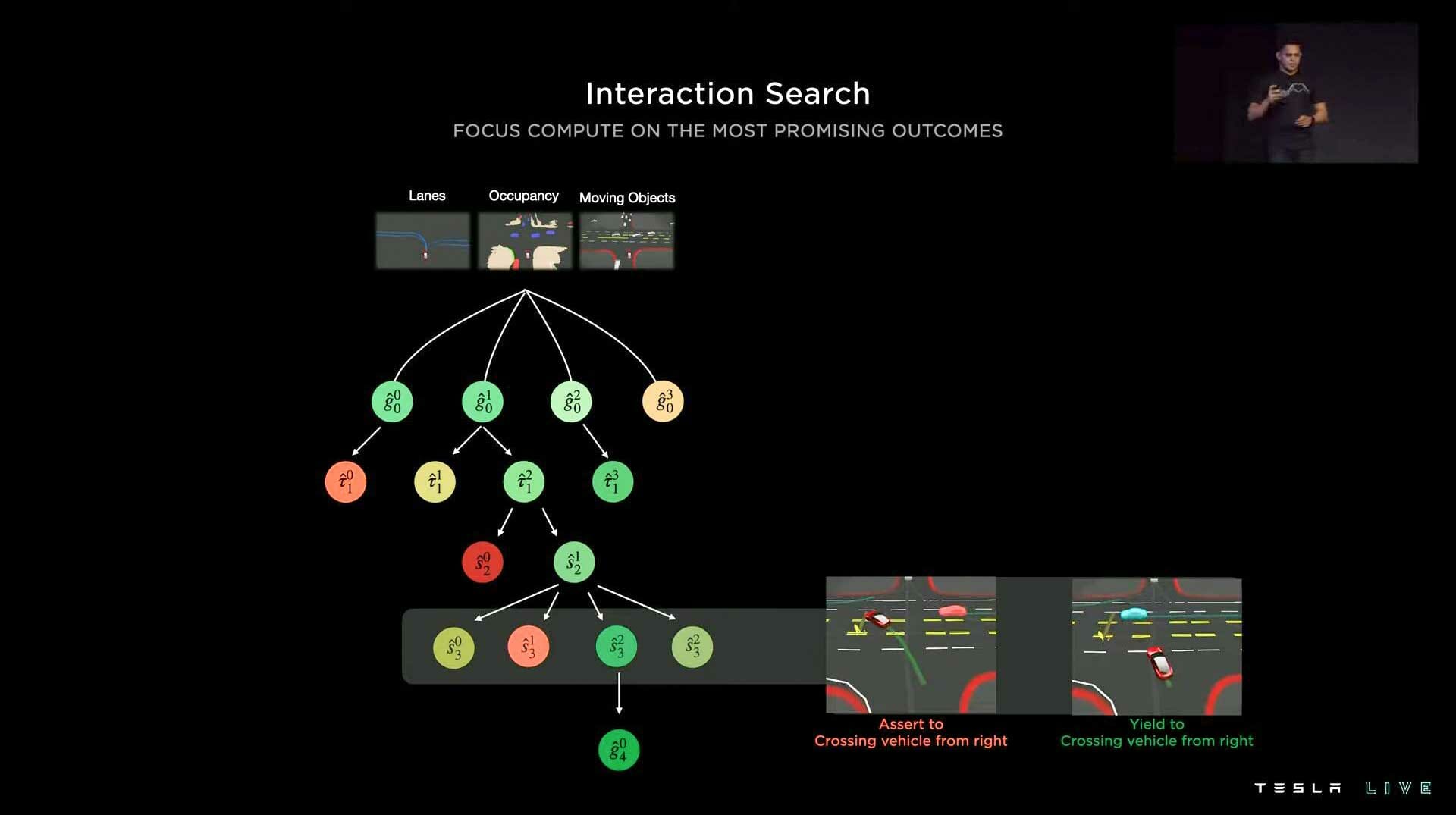

経路計画では下図のような例が登場します。自車は交差点を左折したいが、奥から歩行者が犬を連れていきなり道を渡ってきます。しかも右から接近する車の前に加速して入るべきか、一旦待ってやり過ごすべきか考える必要があり、かつ、左からくる車が先程の歩行者を避けるのかなど、複数の人の相関を総合的に考慮に入れる必要があります。しかもこの判断を50ミリ秒以内に下す必要があります。

従来の手法だと「まず歩行者をどうしようか?」と一つずつ判断して積み重ねていくため、このような煩雑なシチュエーションでは50ミリ秒で判断ができないのですが、これを下記のようにクエリ可能な軽量ネットワークにして、「目的は何?じゃあ、その中でどの候補が良さそう?じゃあ、その中でまず歩行者をどうする?」と式木を作ることで、約0.1ミリ秒で判断できるようにしました。

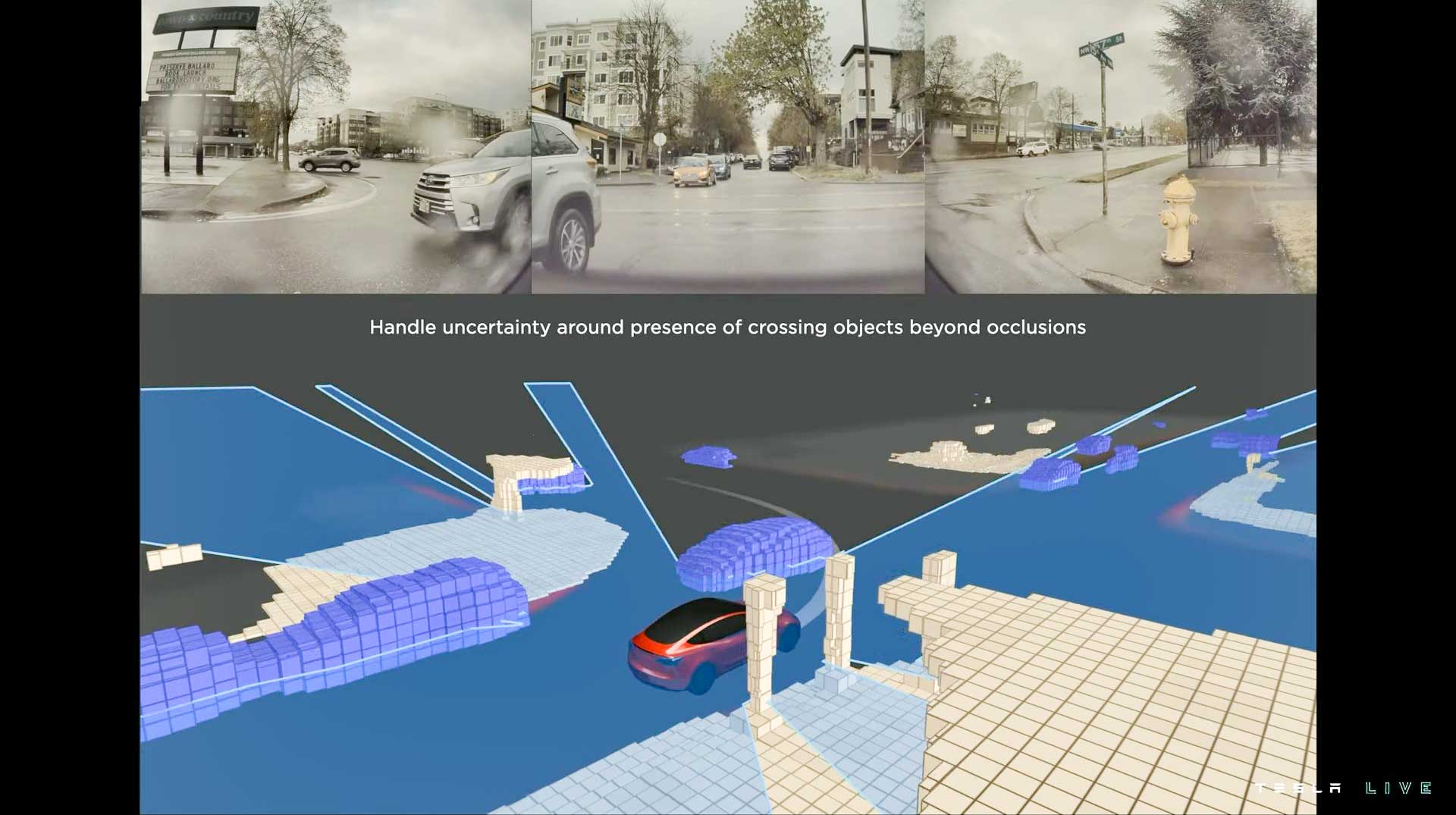

次に、空間のどこに障害物があるか計算するOccupancy networkについてです。日本語で適訳が思いつかないので、このまま英語で表記しますが、下図のように手前の車で奥の車が隠れてしまっても、恐らく今頃はここにいるだろうなと予測して経路計画を立てます。

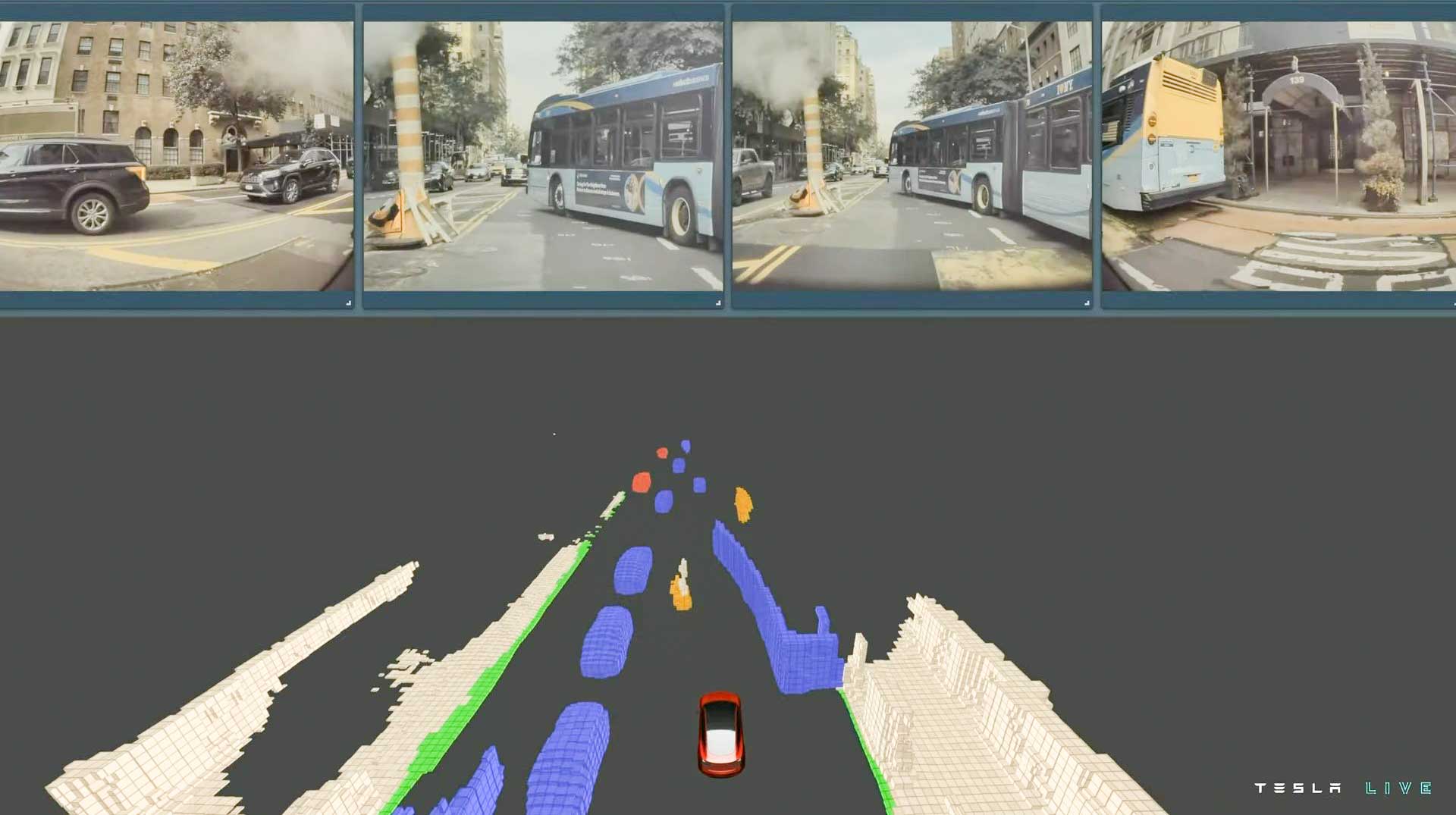

Occupancy networkはまた、連節バスのような珍しい車にも威力を発揮します。下図は連節バスがバス停から発車した様子です。以前のFSDだとバスの前半を一つの物体、後半を一つの物体と認識したり、途中からやっぱり長いバスでしたと判断を変えたりしたのですが、Occupancy networkは純粋にその空間に障害物がいるかどうかだけを見ているため、パニックは起こしません。

ここからはOccupancy networkの仕組みが説明されますが、マニア過ぎるので興味のない方は次の写真に飛んでください。

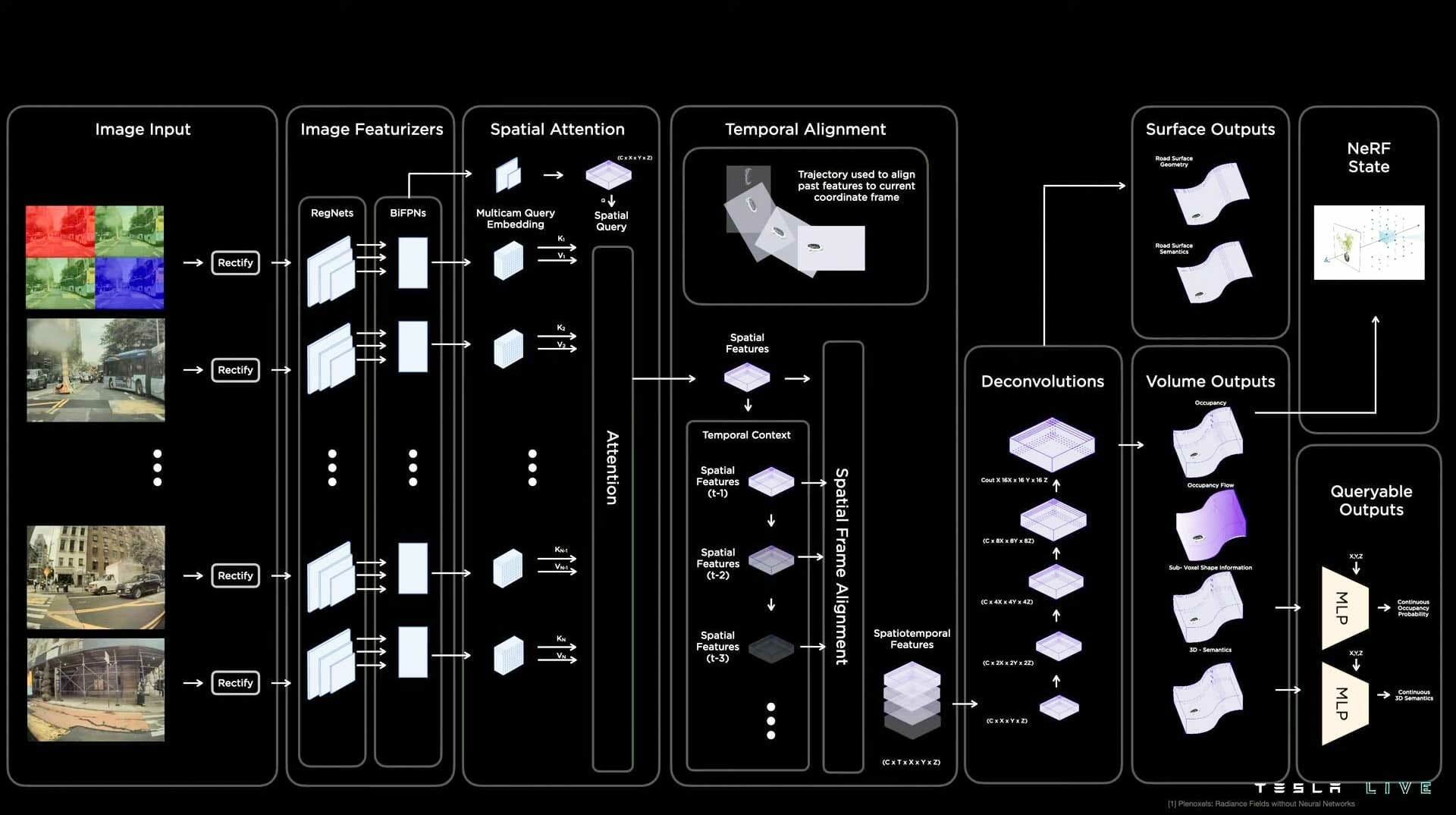

左上の赤や青のカメラ画像が車両から実際に取り込まれる画像です。RGBではなく、あえてRCCB(2017年前半まではRCCC)になっているのは、よりダイナミックレンジ(識別可能な明暗の幅)が高くレイテンシ(応答時間)が低いためです。これにより暗闇やトンネルの出入り口でも視界を確保できます。

一つ右の枠ではRegNetやBiFPNを使って画像から2Dの映像内で認識できる物体を切り出します。隣の枠ではこれらを3D空間に再配置し、次の枠で時系列に並べます。3D空間内で精密に物体の場所や速度が分かると軌跡を計算できます。

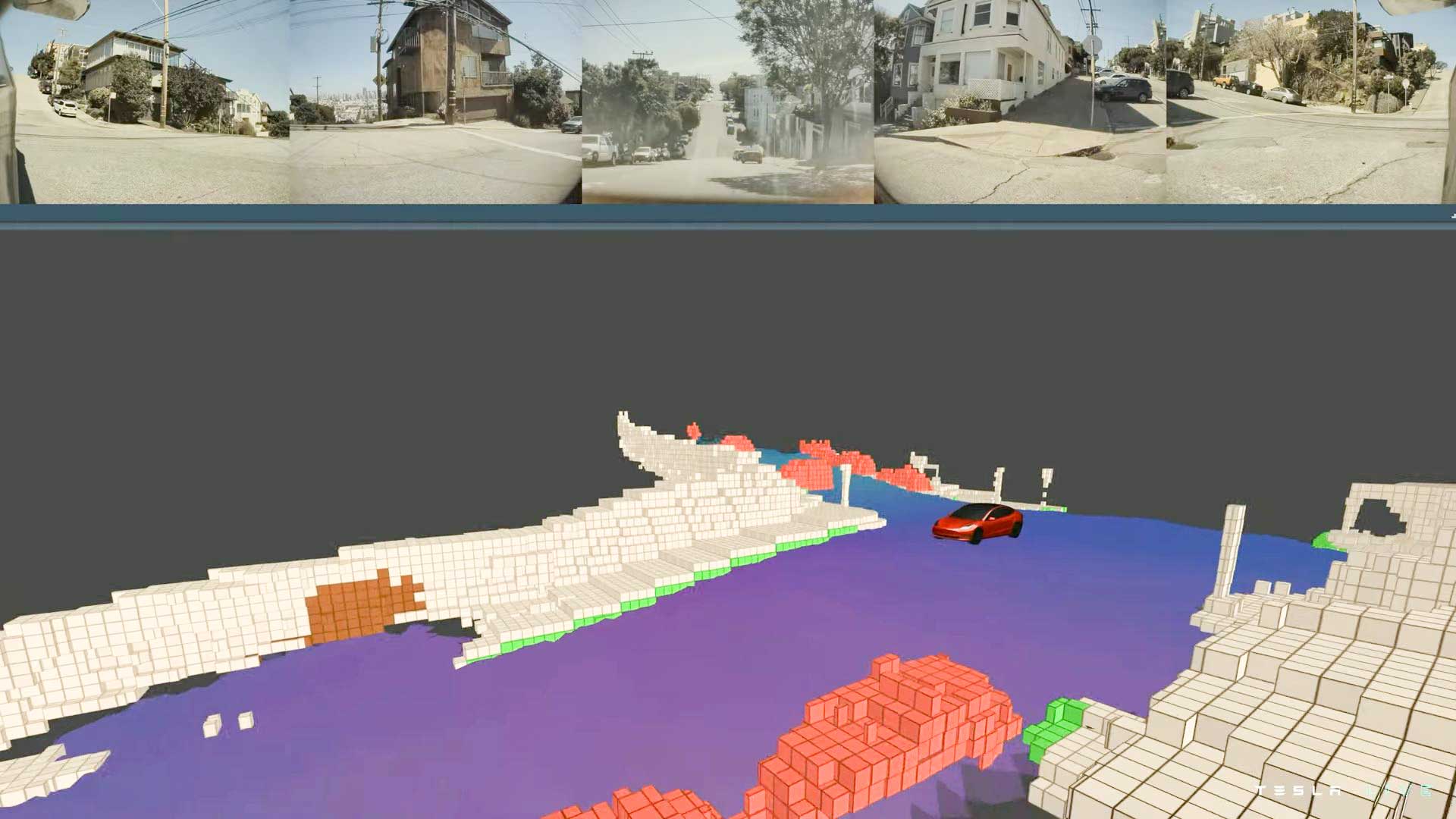

次の枠(Deconvolution)では畳み込まれた情報を展開していきVolume outputでVoxel空間にします。Voxelはドットが荒いため、詳しく知りたい部分はQueryable outputの部分で粒度高く描写します。また、Surface outputは道の勾配に合わせてVoxelも傾けてくれる操作です。

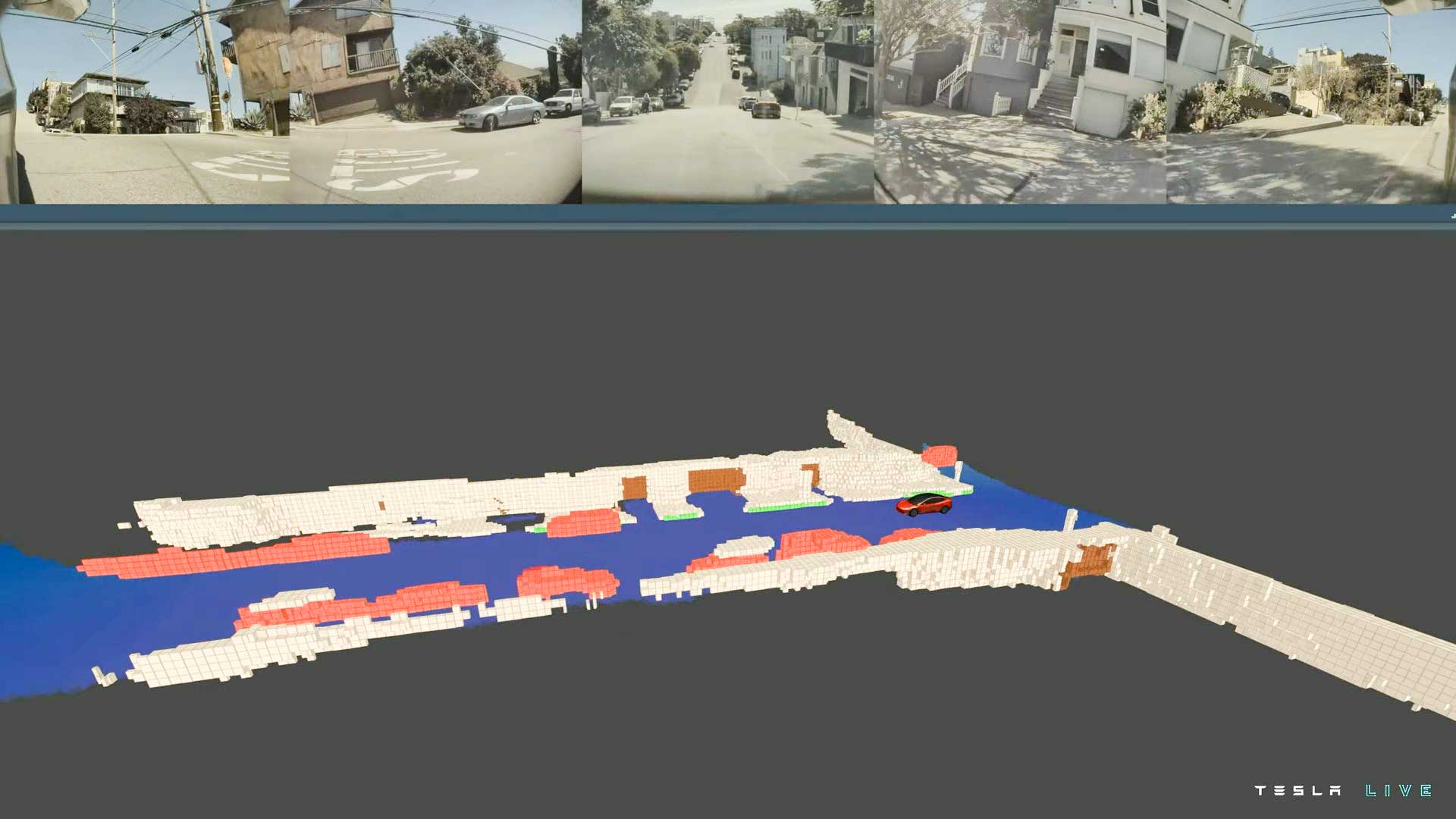

坂を下る前は緑の縁石がガタガタに表示されていますが……

坂を下り始めるとVoxelの傾きが車体と一致してスムーズな直線に。

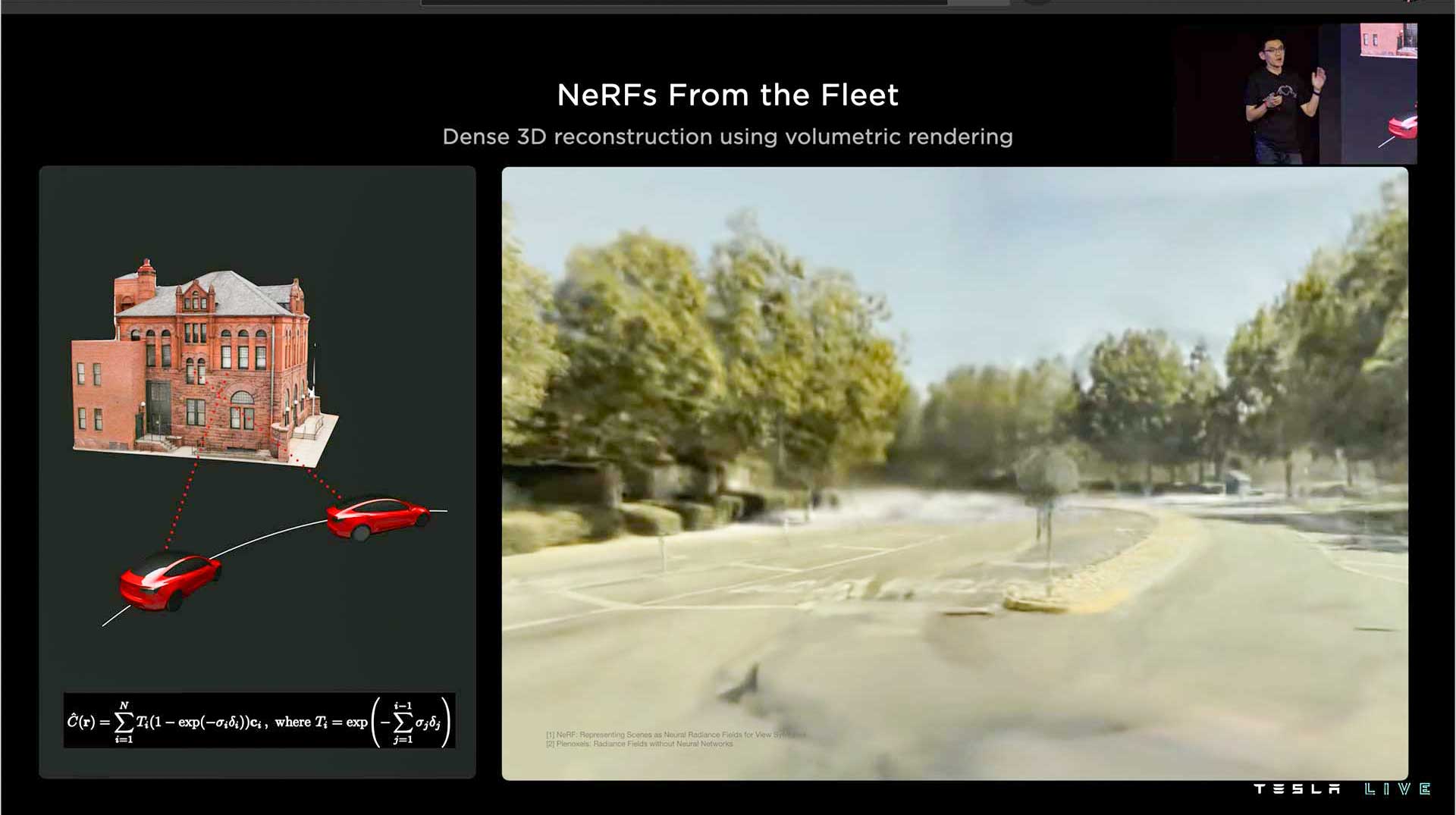

一番最後、右上のNeRF stateはこの中でも一番キモい(褒め言葉)テクノロジーです。NeRFは2年ほど前に登場した技術で、静止画を取り込んで、まるでカメラを持っている人が移動しているかのように視点を変えられるのです。こちらのページ(https://www.matthewtancik.com/nerf)をご覧頂くと、その凄さが分かると思います。

一部のスマホではこれに似た技術を使って立体感のある写真を生成できますが、カメラに写っていない部分は映像が破綻します。この技術では破綻なくカメラアングルを移動させることができ、金属やガラスの反射も新しいアングルで再現されます。テスラではこれをニューラルネット(NN)のトレーニングに使えないか検討しており、オートパイロットソフトウェアのリーダー、アショク・エルスワミも休日はこれの虜になっているそうです。もしこの技術に詳しい方がいれば、今すぐテスラに就職だ!

テスラ車が撮影した写真から再現した三次元空間。

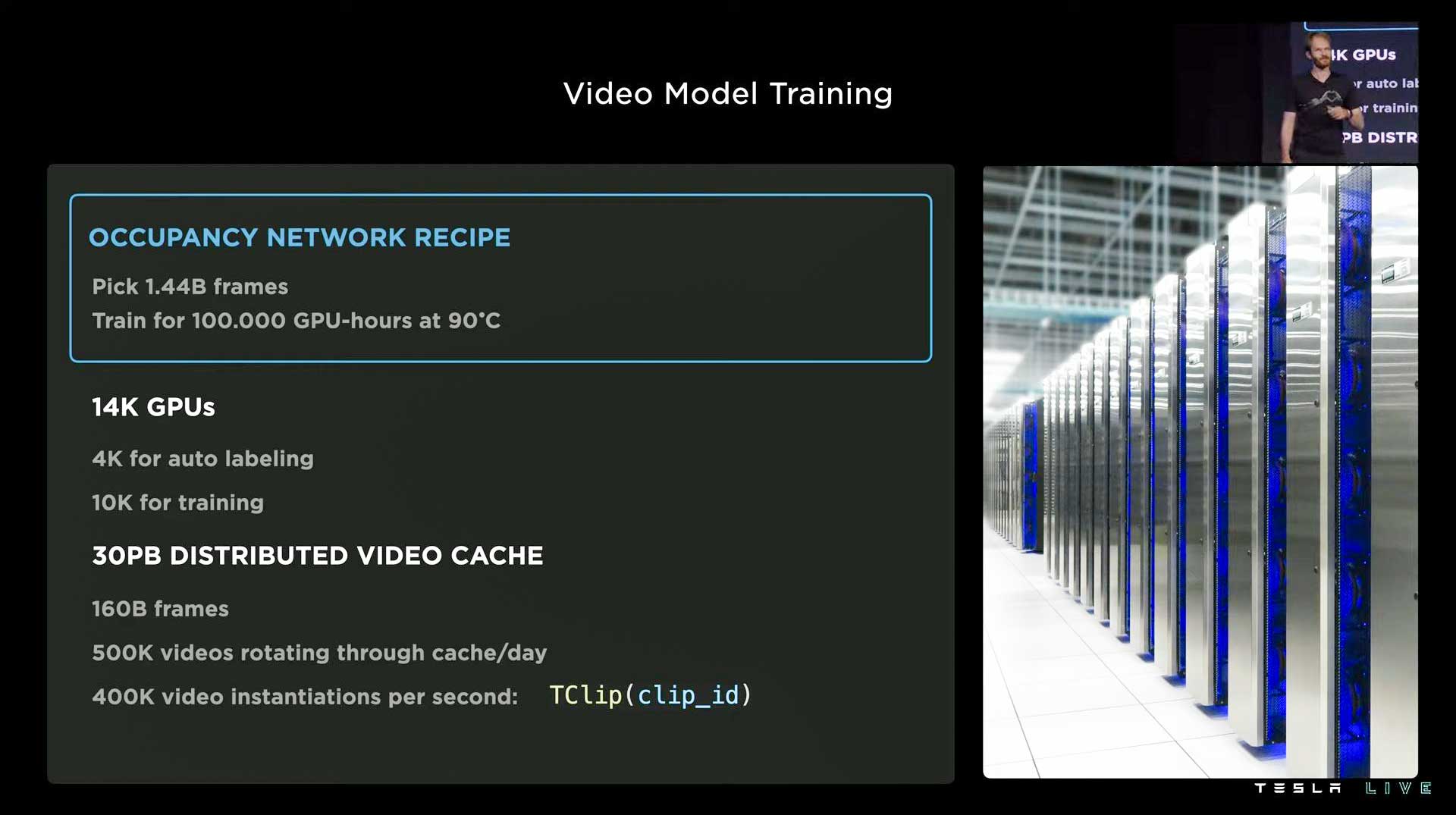

次はOccupancy networkなど、NNのトレーニングインフラについてです。テスラ車から吸い上げた膨大な動画データを計算してNNを学習させるのですが、このときに使用するGPUが多いほど計算が早く終わるため、テスラでは自社製のスパコンを作っているのです。NNのトレーニングに使用するデータセットも固定のものではなく、随時更新され、日に50万件の動画が出入りしています。

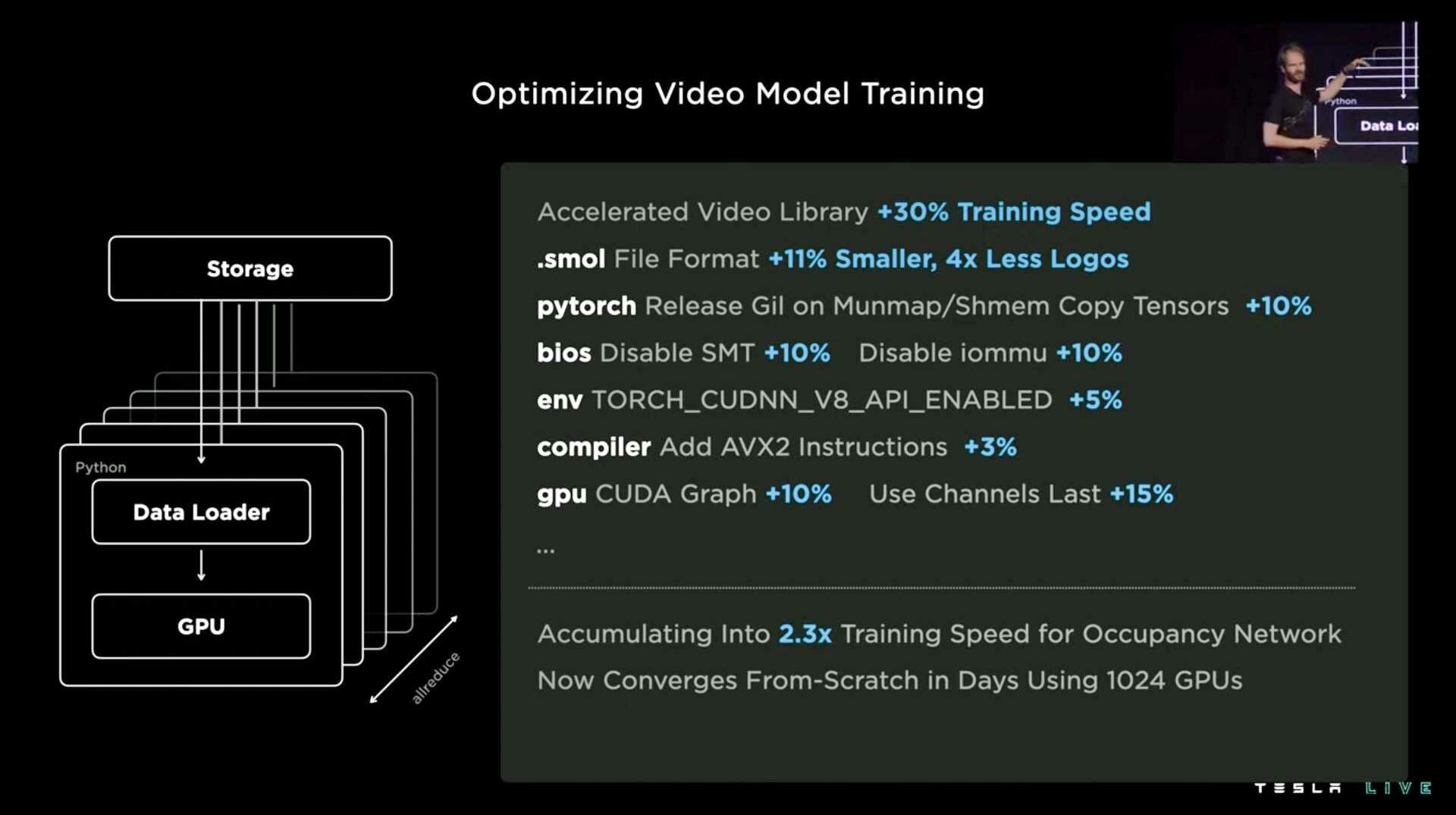

ただ、金に任せてありったけのGPUを買ってきたらいいのかというとそうではなく、GPUに負けない速度でデータを送り込むストレージ、CPU、メモリなどが必要です。テキストや画像の処理なら定石がありますが、動画はまだその手法が確立されていません。テスラはトレーニングを最適化し続け、同じハードウェアから2.3倍の速度を引き出し、これまで数日かかっていた処理が数時間で完了するようになりました。

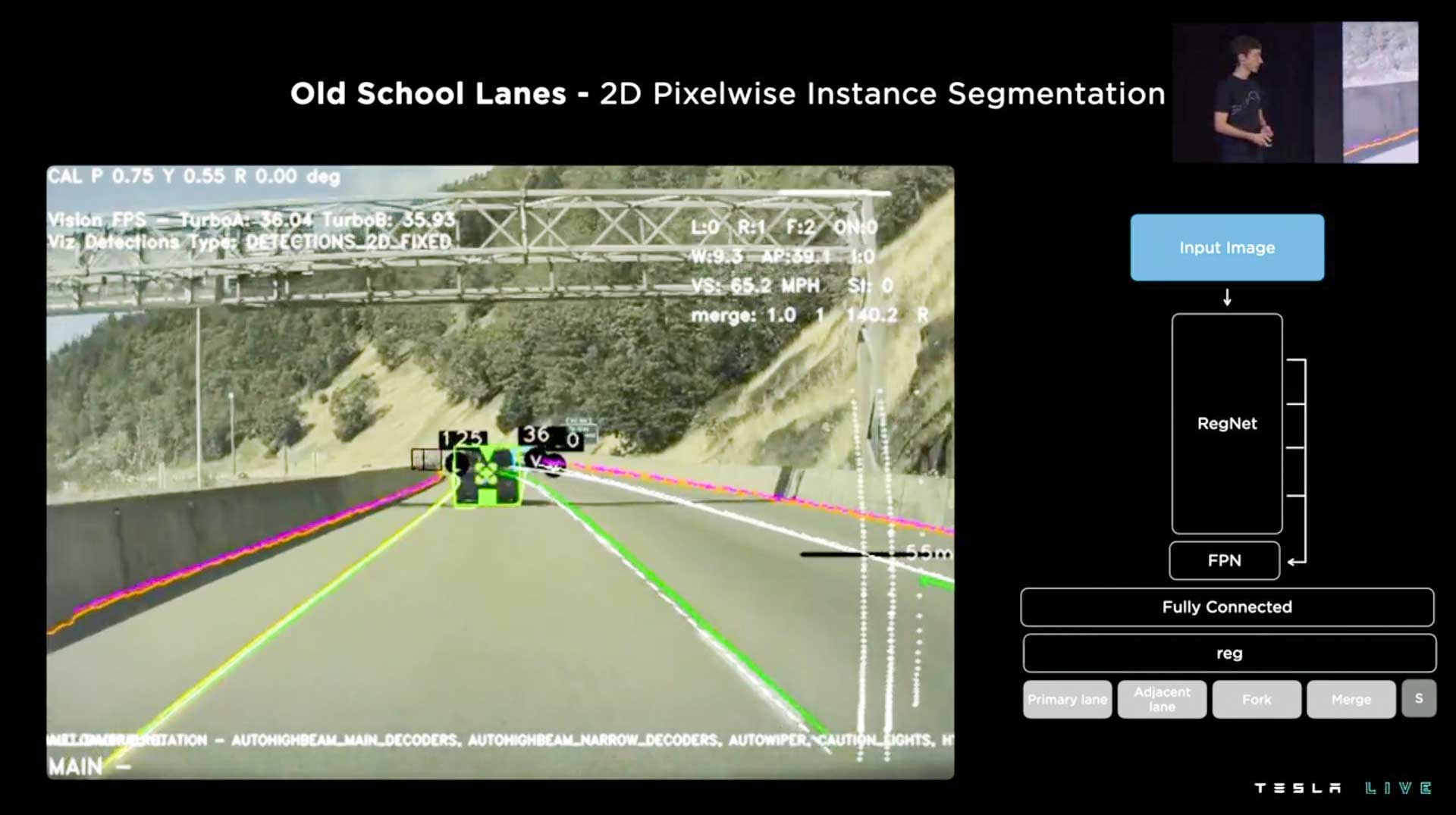

次は車線と障害物についてです。昔のオートパイロットは二次元の画像から車線等を認識していたため、高速道路など単調な道路では良かったのですが、一般道の複雑な交差点などで役に立ちませんでした。

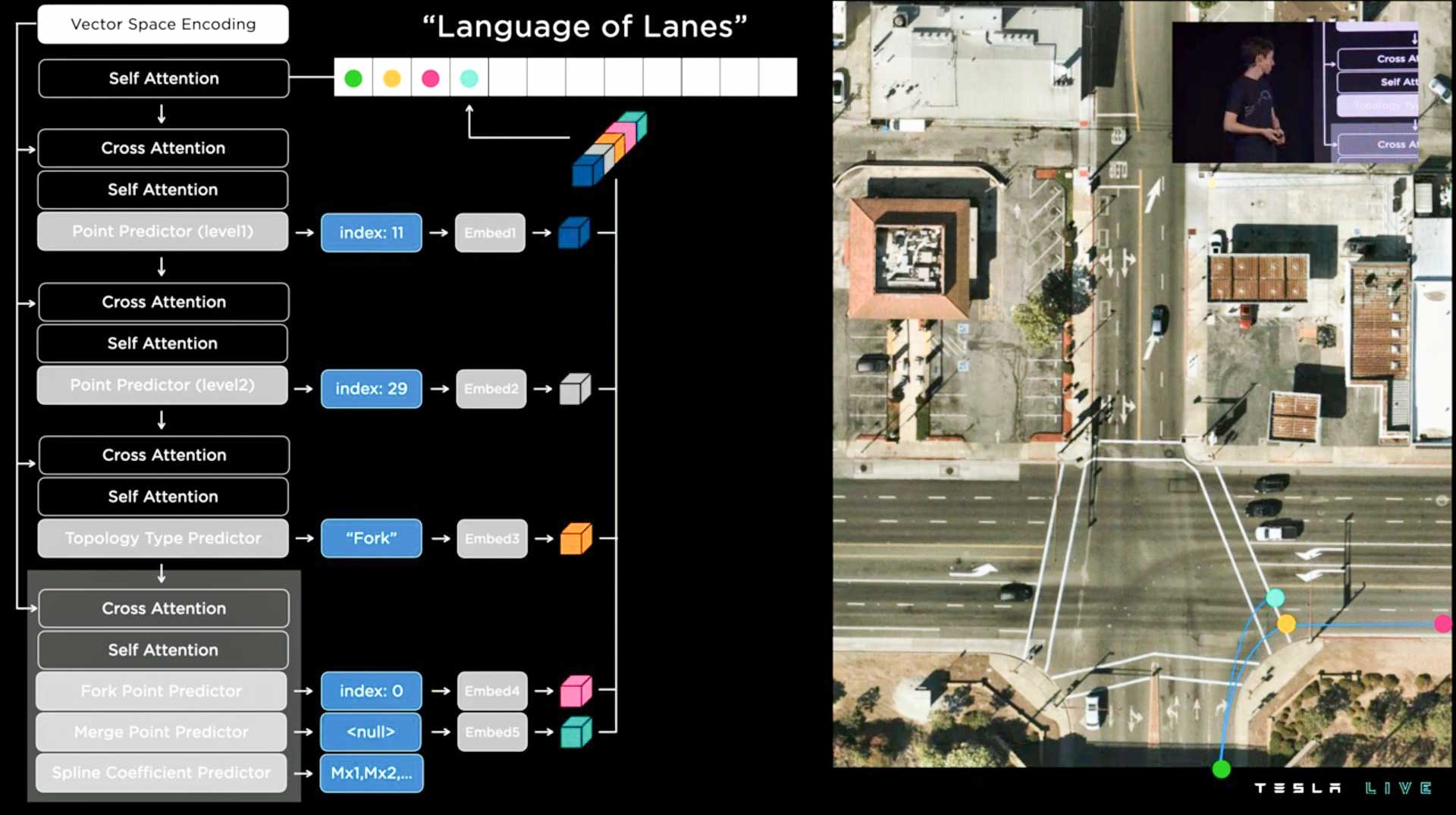

FSDでは三次元空間+時間軸を使い、そこに地図情報(HDマップではない)から車線の幅や車線数、バス専用レーンなどの情報を追加しています。これを自己回帰デコーダでテスラ独自の言語型処理に変換することで、短時間でルート指示が作成できるようになりました。さらに、これまでは「これは2車線かな? いや、3車線かも」と車が切り分けられず困っていた場面でも、言語型処理にすることで決定的に「これは2車線」と判断できるようになりました。これはオプティマスにも転用可能な技術です。

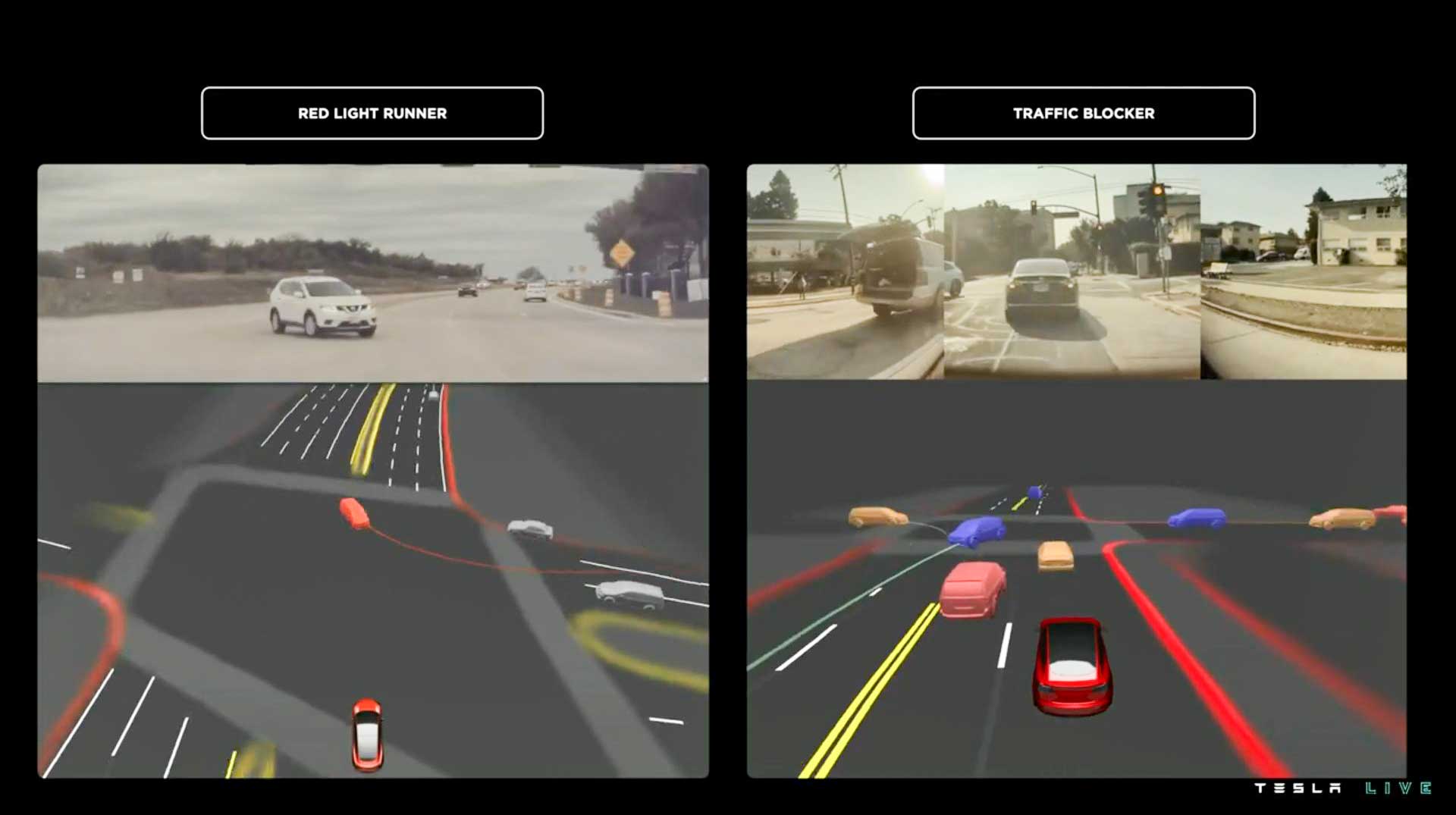

次は相手車両の挙動予測とラベリングについてです。下図の左側に注目していただきたいのですが、前方から来た白いSUVが信号無視をして左折してきます。テスラ車は信号無視の少し前からSUVの挙動を予測し、先にハンドルやブレーキの対応を用意しておき、本当に突っ込んできたら即座に決められた回避行動を取ります。

また、右側の例では左折レーンの中途半端な位置にSUVが止まっており、テスラ車はこれを不動車とラベリングし、避けて通ります。以前までのオートパイロットだと左折待ちだと判断してずっと後ろで待っていたでしょう。

オートパイロットは単に物体の位置や速度だけ見ているのではなく、そこに意味を付加することで安全かつ人間のような振る舞いができるようになりました。

複雑な判断の精度も向上中

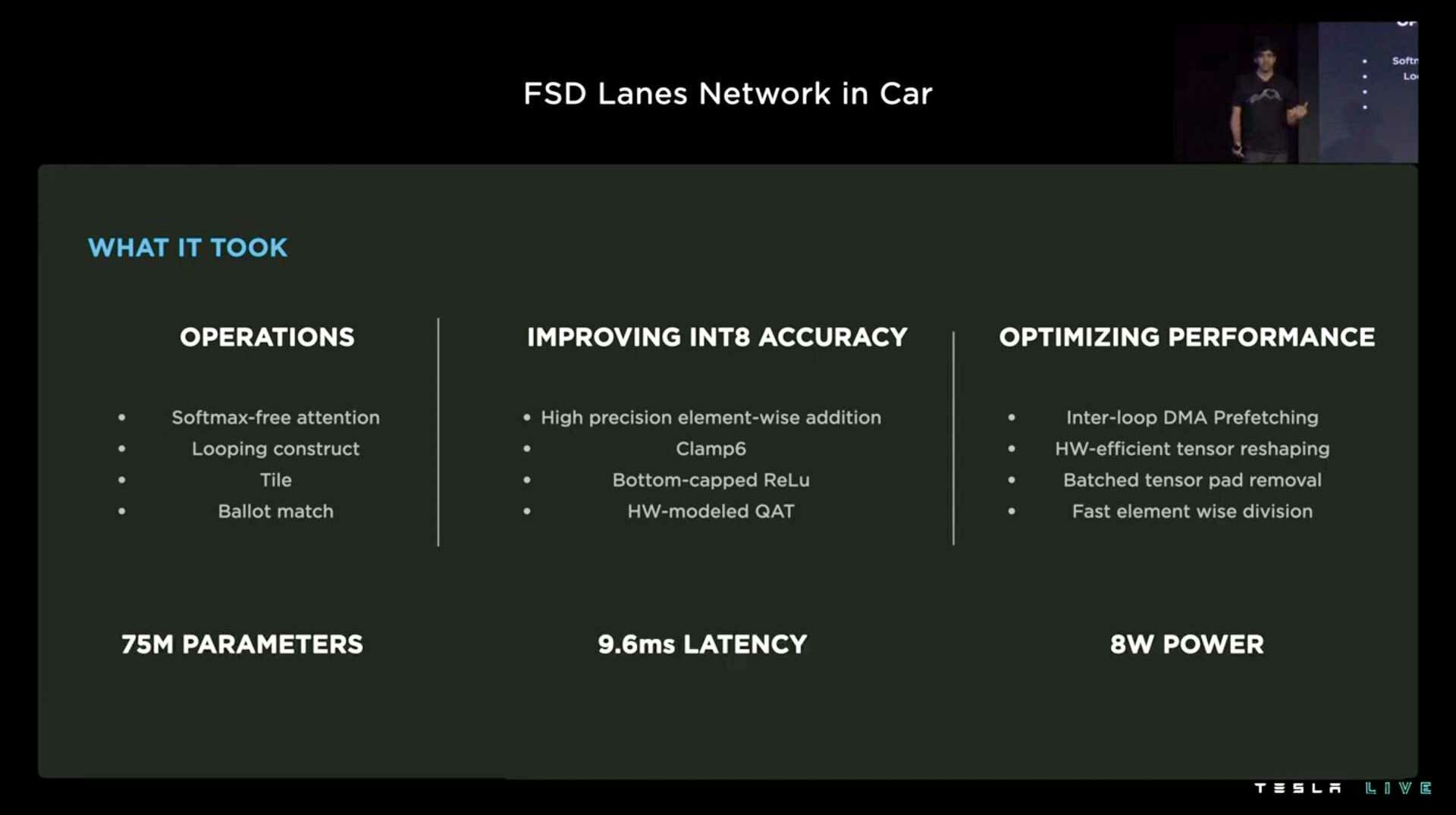

次は、トレーニングしたNNを自動車のコンピューターという演算能力の低い環境にどう落とし込むかについてです。このセグメントのプレゼンターのシー君はあまりにもインド訛りがひどすぎて、何を言ってるか聞き取れない部分がありましたが、AI Day 2002の中で一番の爆弾発言をしたんじゃないかなと個人的に思っています。

Voxel空間を使う方向に開発がシフトしたため、そもそもDense dot product用に設計されたエンジンでSparse演算をするハメになったのですが、チームでは設計当初に考えてもいなかった方法で効率化し、10ミリ秒のレイテンシとたった8ワットの消費電力で適切な車線の経路計算ができるようになりました。

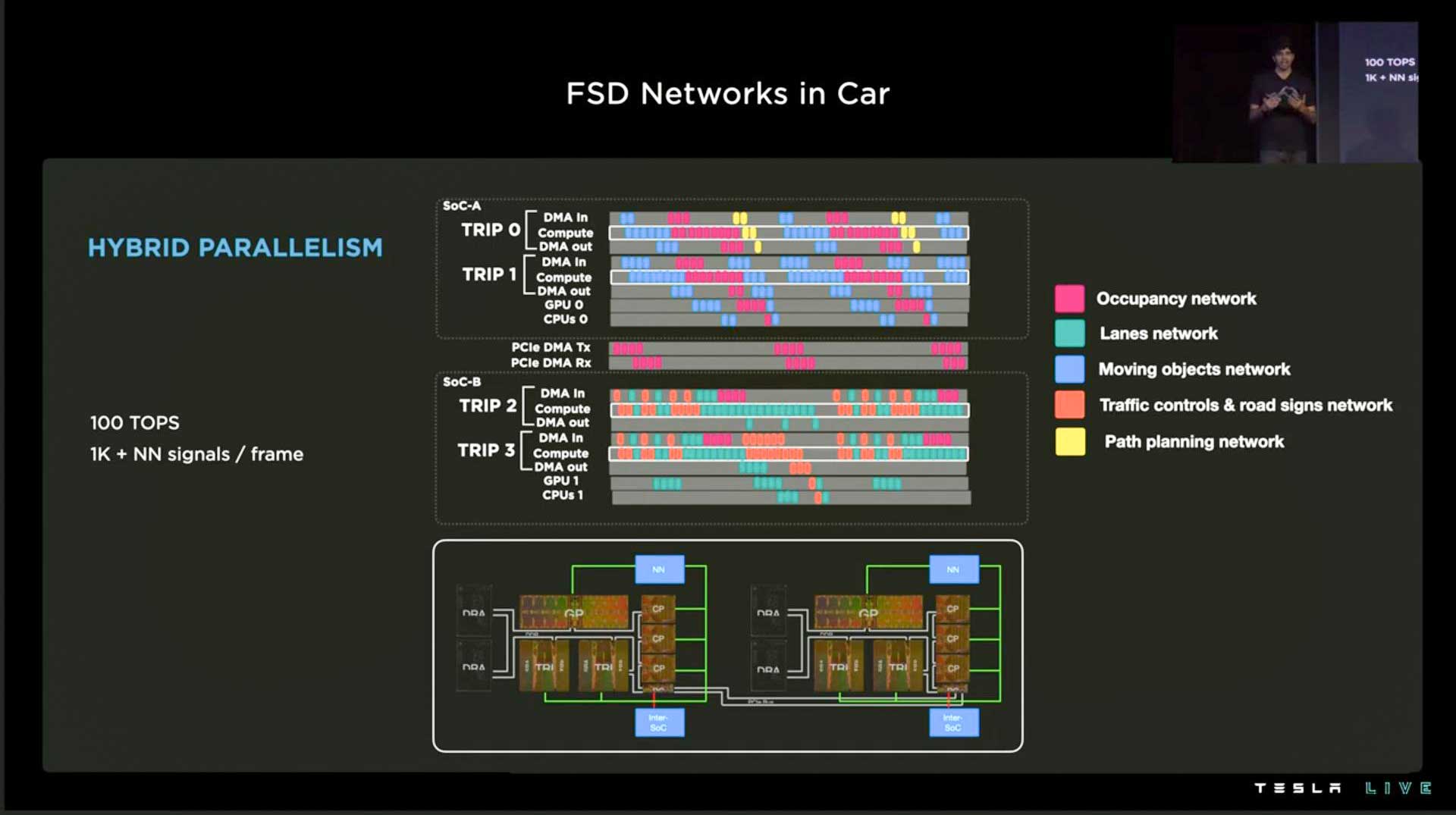

ここからは少し私の疑問点です。シー君は従来のコンパイラの手前に専用のコンパイラを一つ置き、処理能力やメモリの制限に合わせた最適な演算スケジュールを作成して、川下から川上まで最適化することでフレームレートを最大化している、と説明するのですが、下図をご覧頂くとどう見てもHW3コンピューターのA/Bノードを両方使っています。本来は1ノード内ですべてを完結し、それを2つ持っているから冗長で安全だ! という説明ではなかったでしょうか?

ただ、冗長構成と言ってもAノードだけがネットワークにつながっているため、万が一故障してBノードが運転を交代してもそのままでは車両と通信できないため、形ばかりの冗長化(Aノードに誤判断がないかチェックするためだけのBノード)だったのかも知れません。

いずれにせよ、NNが1ノードに乗り切らないので、もうすぐ発表されると噂のHW4はきっとこの冗長化問題も解決してくれるのだと願っています。個人的には基板や電源、車内の搭載位置すら別にするぐらいの気概を見せてほしいです。

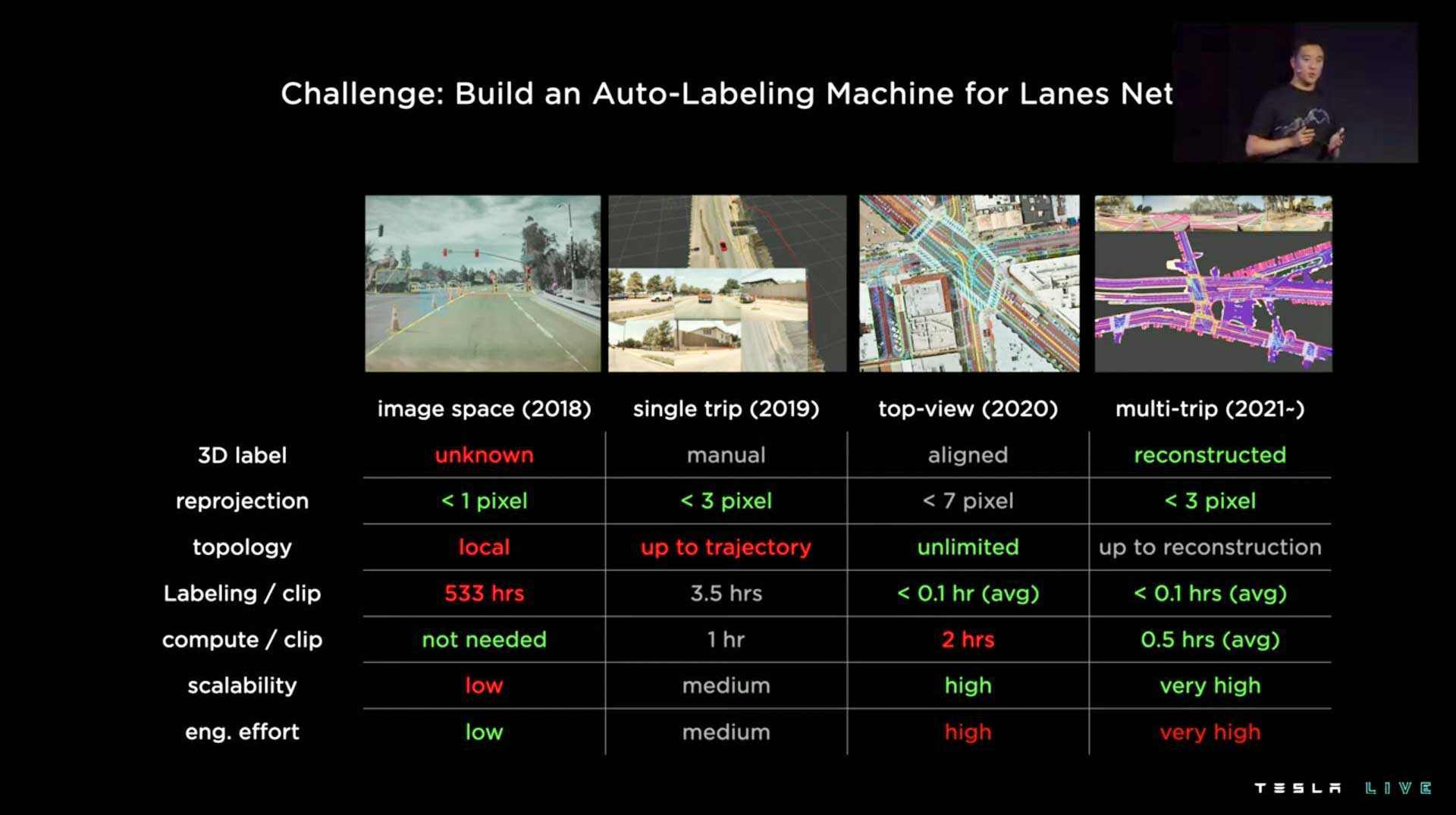

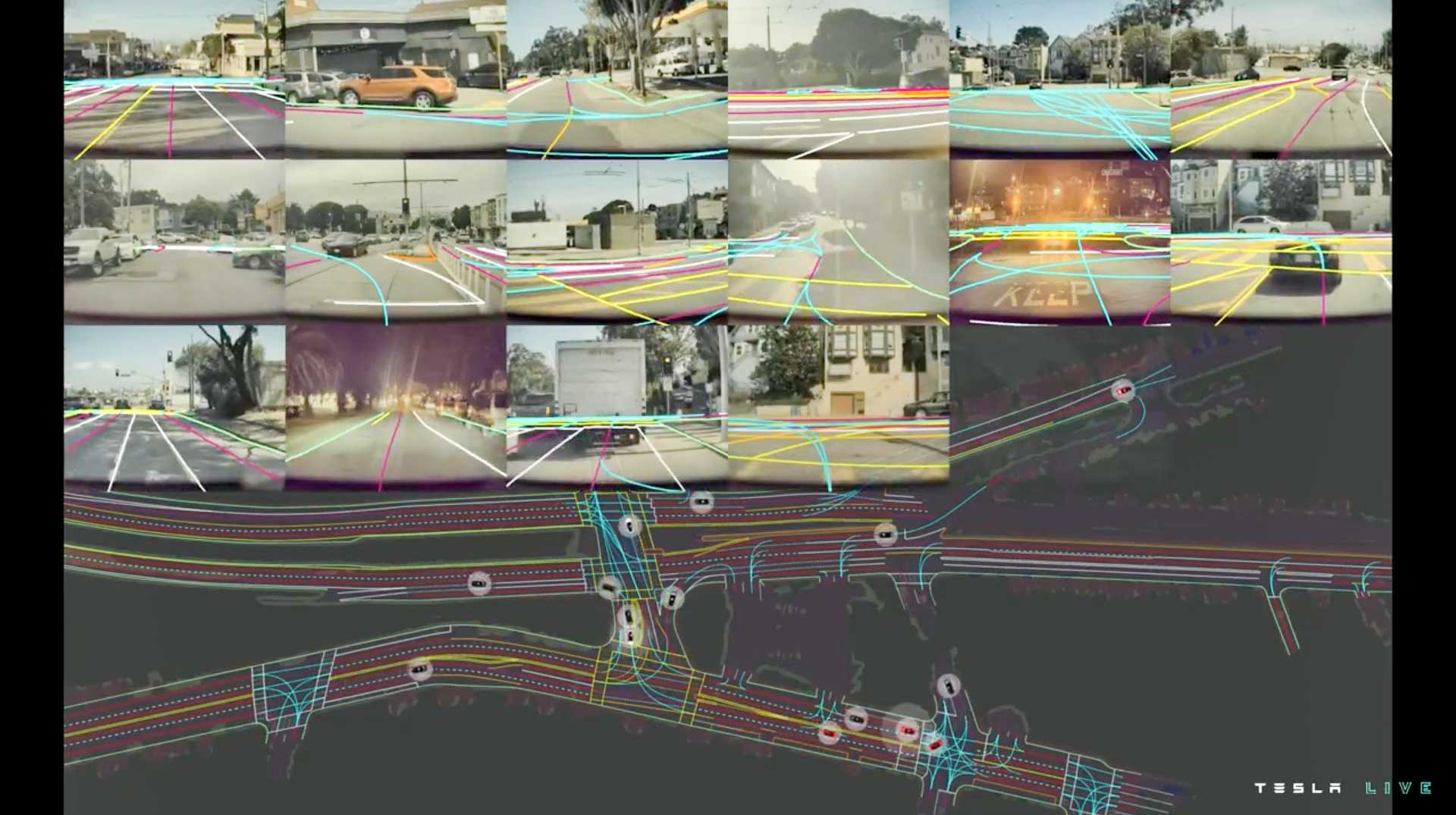

次はラベリングの自動化についてです。手動や自動のラベリングを様々試して、左から右に行くたびに100倍ぐらい効率化が進みました。2018-2021の3年で100万倍ラベリング効率が上がったということですね。

現在はマルチトリップ再現という方式で複数車両からのデータを同一の交差点で集め、最後に人間が確認したら(1~2時間)、それを正しいデータとし、新しく入ってきた走行データは「正しいデータ」と比較することで、人間が介在することなく30分でラベリングが完了します。自動車の工場も手作業では生産台数が少ないのと同様に、テスラはラベリングも自動化して毎日高品質のラベルを大量に「生産」しているのです。

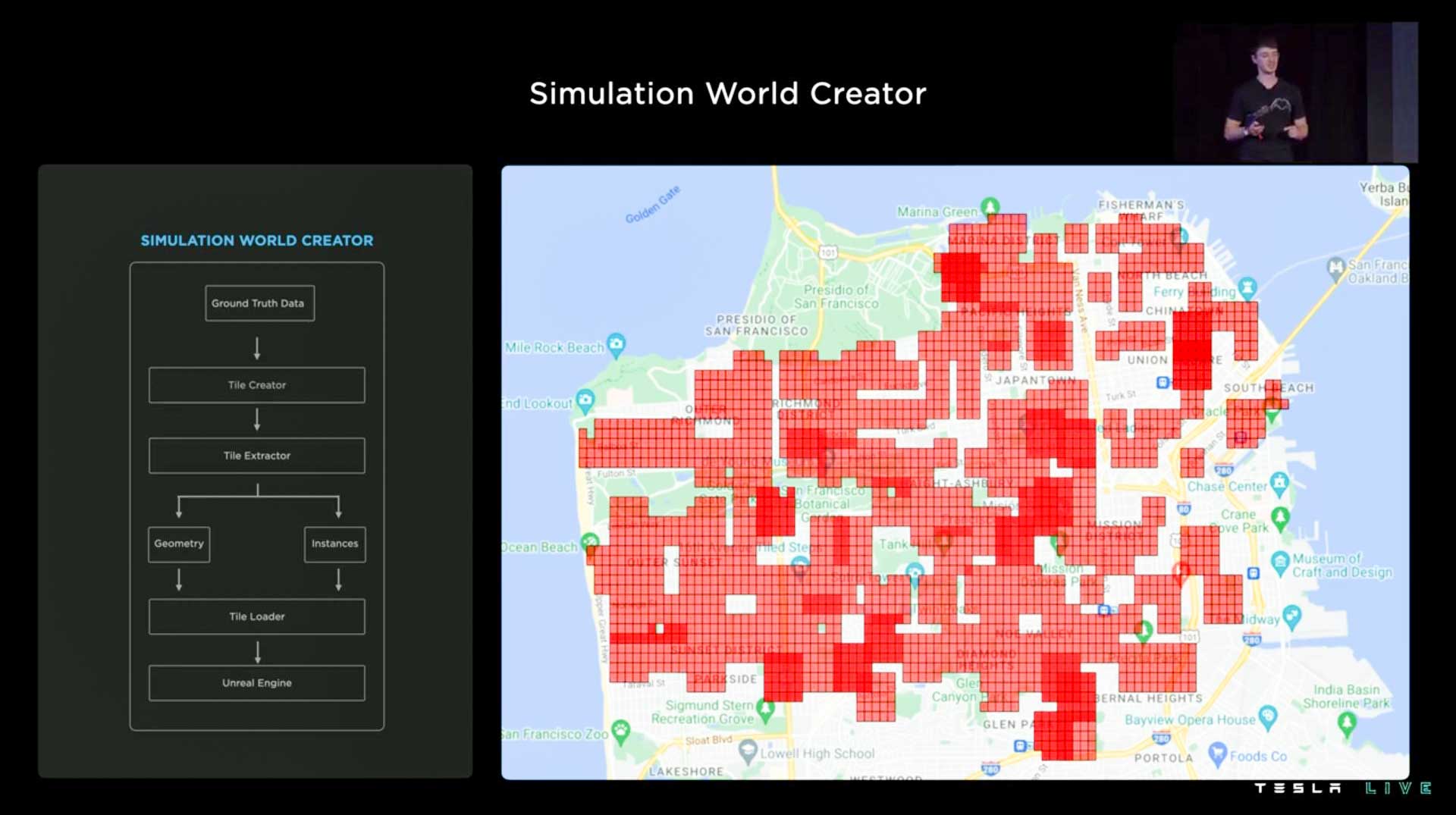

次はシミュレーションについてです。下図はサンフランシスコのとある複雑な交差点ですが、これを人間が制作しようとすると2週間はかかります。しかしテスラでは1000倍以上早く、約5分で再現します。

シミュレーション環境なので、ボタンひとつでパラメータを変えて光の差し方や水たまり、ビルのサイズを変えられます。車線情報を変えると周囲の交通標識も変わるため、自車が標識を読んで経路計画をより正確にするトレーニングも簡単に行えます。

この交差点は人間でも迷いますね(汗)

サンフランシスコを訪れたことがある方ならこの地図の広さが分かると思いますが、赤い部分のシミュレーション環境を、テスラのエンジニアなら1名で取り掛かって2週間で完成させられるほど環境構築も効率化されています。

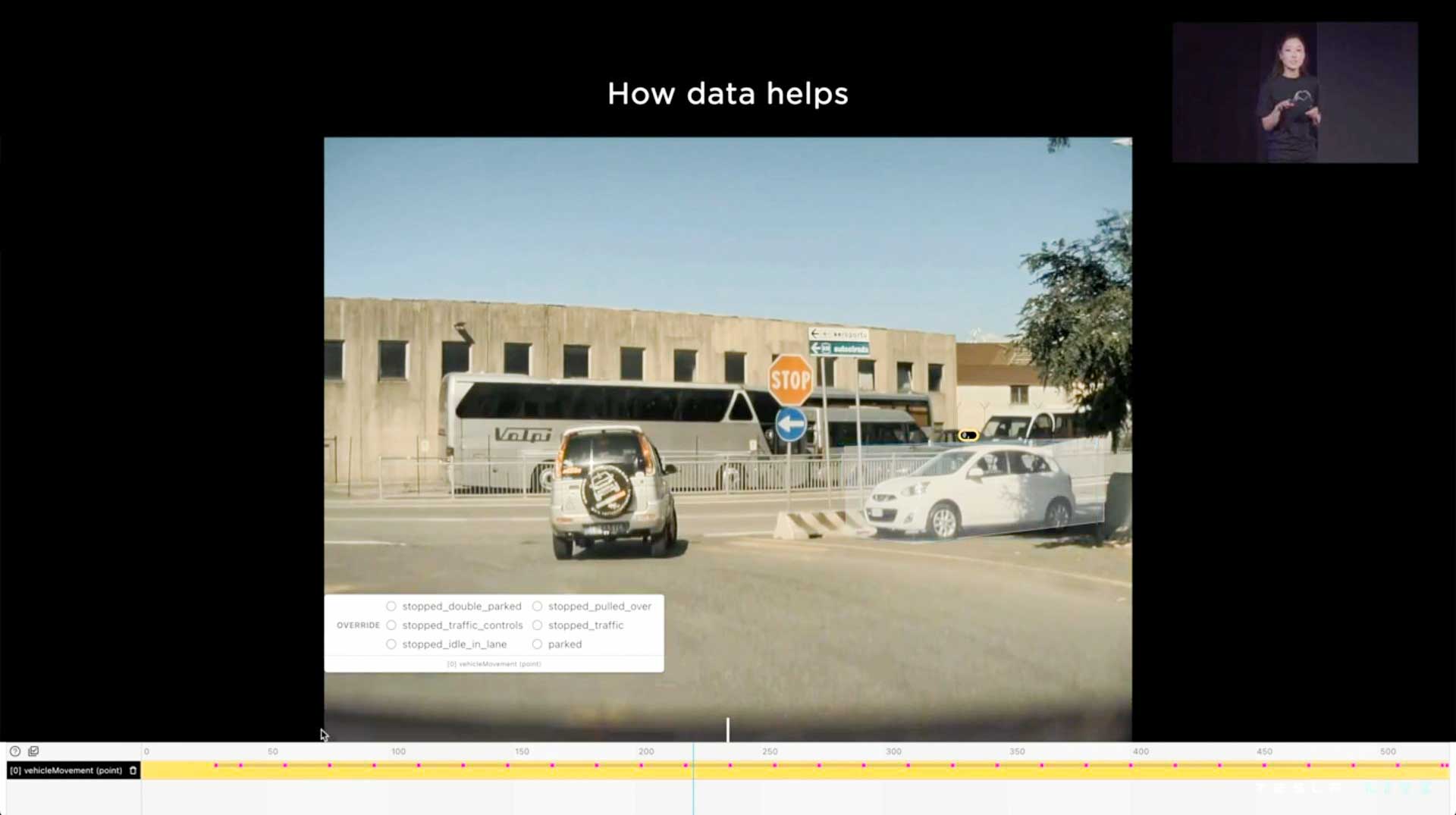

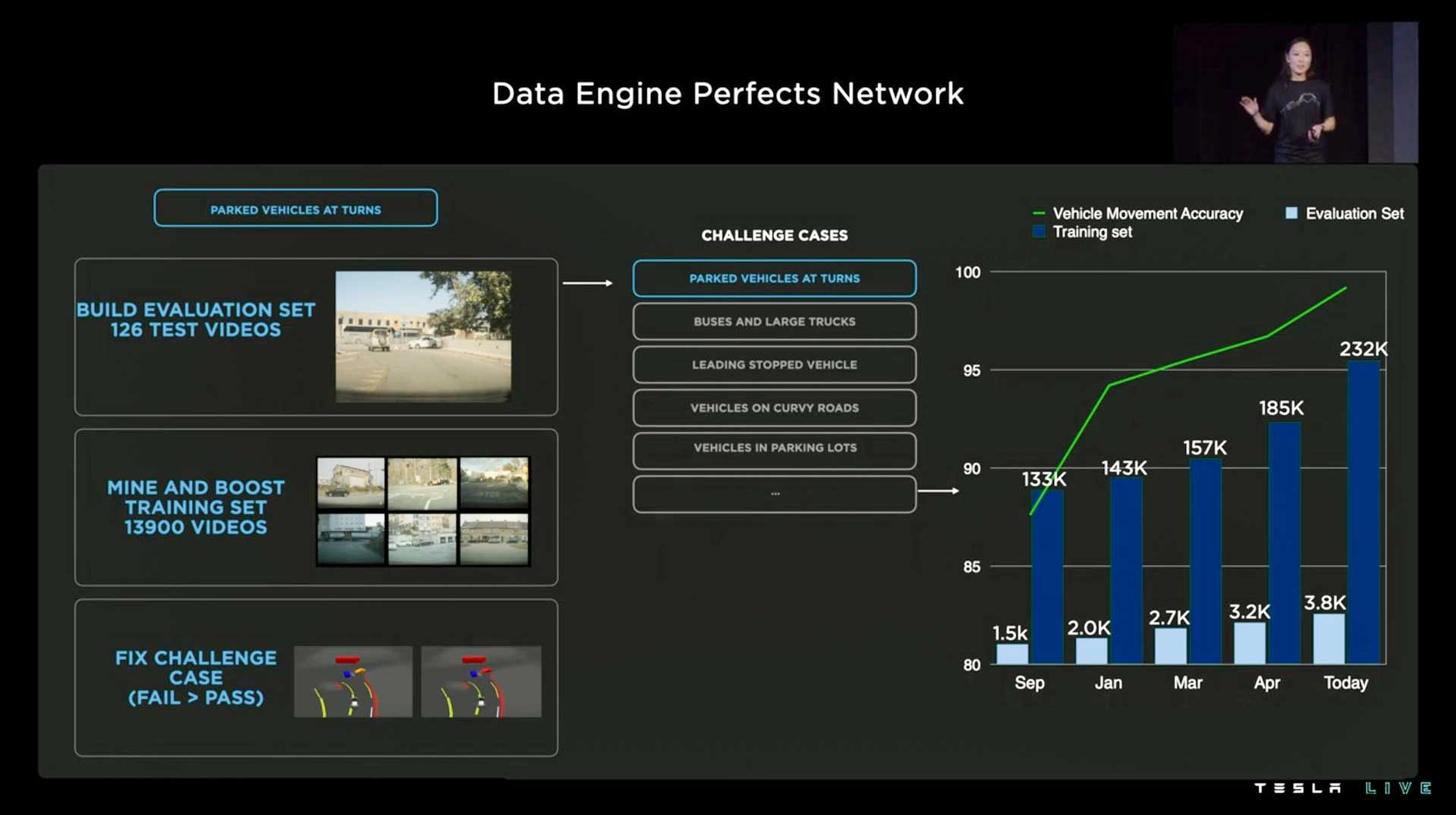

次はデータエンジンです。下図では交差点の勘違いしやすい場所に止まっている駐車車両を正しくラベリングし、「難しい事例」として分類。これを解決するために数千の似たような事例を探してきて、現モデルの予測ミスを正します。自動運転モデルの内容を変えなくても、定数の重み付けを変えるだけで、これまで判断に苦労していた事例をピンポイントで修復できます。

これを繰り返すことで自動運転の精度がどんどん上がっていき、プレゼンでは去年の9月から現在までの期間で判断精度が90%未満だったところから、ほぼ100%の正答率まで改善している様子が映し出されました(緑の折れ線グラフ)。

さて、そろそろ皆様お疲れの頃でしょうか? とはいえ、まだ3時間23分ある動画の2時間目あたりです。次回、Part.3では、DOJO(テスラのスーパーコンピューターシステム)に関するプレゼンテーションの翻訳&解説と、Q&A、そして、いつものテスラトリビアを紹介します。

【ライブ配信動画(YouTube)】

(文/池田 篤史)

コメント

コメント一覧 (1件)

こんにちは、一点よくわからない部分がありました。

——

これまでは「これは2車線かな? いや、3車線かも」と車が切り分けられず困っていた場面でも、言語型処理にすることで決定的に「これは2車線」と判断できるようになりました。

——

言語型処理というのは、外から情報を与えることで判断できるようにさせるという事でよろしいでしょうか?