動画を見ながら同時通訳的にメモに起こしていった内容であり、裏付けなどの追加取材は行っていないことをご了承ください。

テスラチャンネルの録画配信

(ライブは01:09:30ごろから開始)

(※記事内画像もYouTube動画から引用)

自動運転用のハードウェアについて

テスラが取り組んでいる自動運転技術についてのイントロダクションに続いて、イーロン・マスク氏に促されて登壇したのは、iPhoneのチップ開発者でもあったPete Bannon氏。自動運転技術を担当するテスラ社の副社長。

テスラの自動運転用AIチップ開発は2016年2月にスタート。2018年7月からは、イーロン氏自ら「客観的に世界最高のチップ」と評するFSD(フルセルフドライビング)チップを搭載したハードウェア3(HW3)の生産を開始している。

HW3には、テスラがカスタムデザインしたチップである「ニューラルネットワーク・アクセラレーター」を含んでいる。

2018年12月には従業員向けのレトロフィット(テストと改善)を始めた。2019年4月にはモデルS/XにHW3を搭載開始。4月からはモデル3にも搭載している。

設定した目標のポイントは、100W以下で動作させること。HW3では、ネットワークアクセラレーターチップ以外は業界標準のものを使用している。

さらに、情報処理能力として50TOPS(Trillion Operations Per Second)を目標とした。

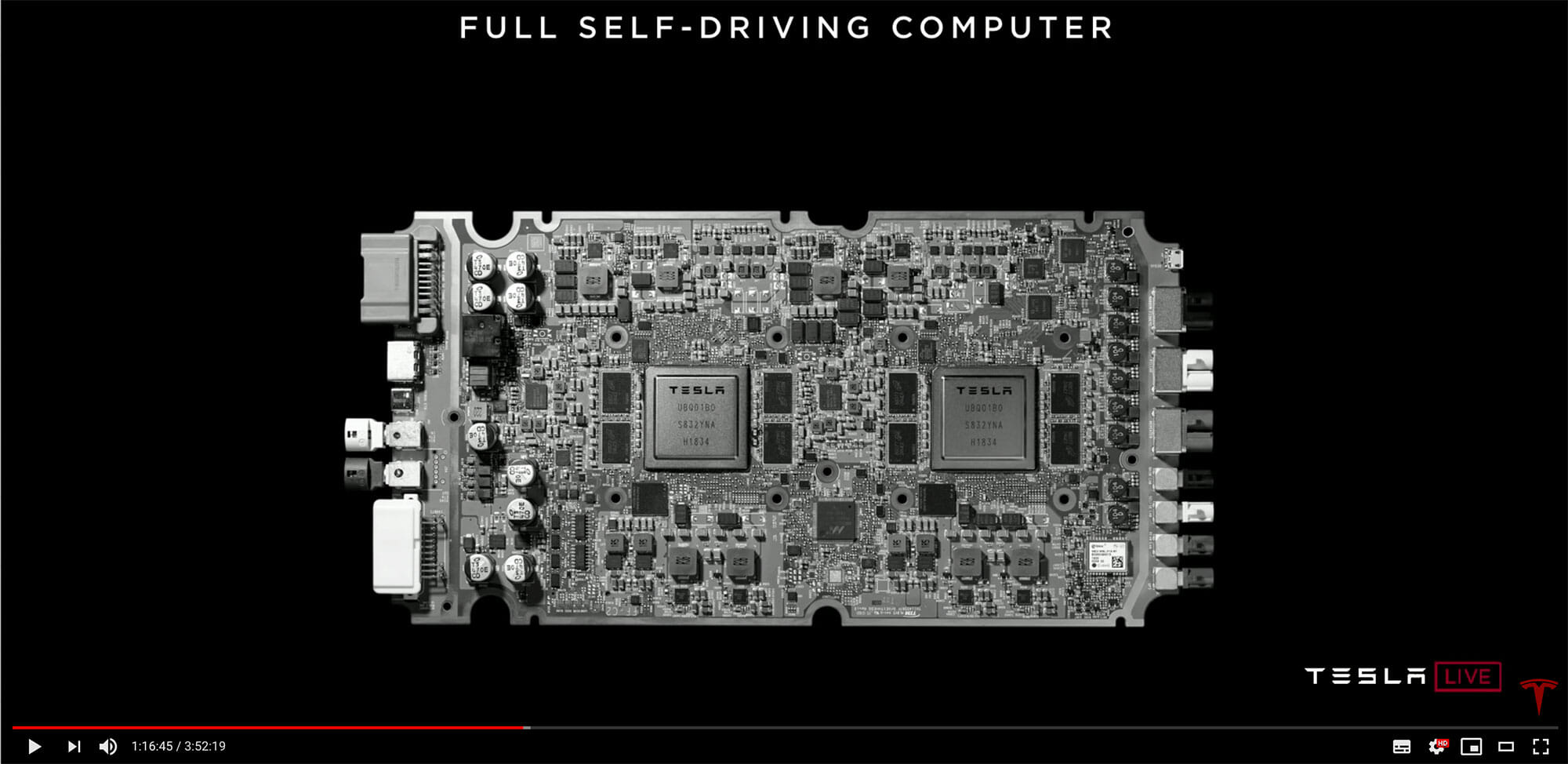

このボードの右側がビデオフィード、カメラなどを接続する。左側は電源と制御用のインターフェースになっている。

HW3の外装はHW2.5とほぼ同じで、グローブボックスの裏側に搭載される。

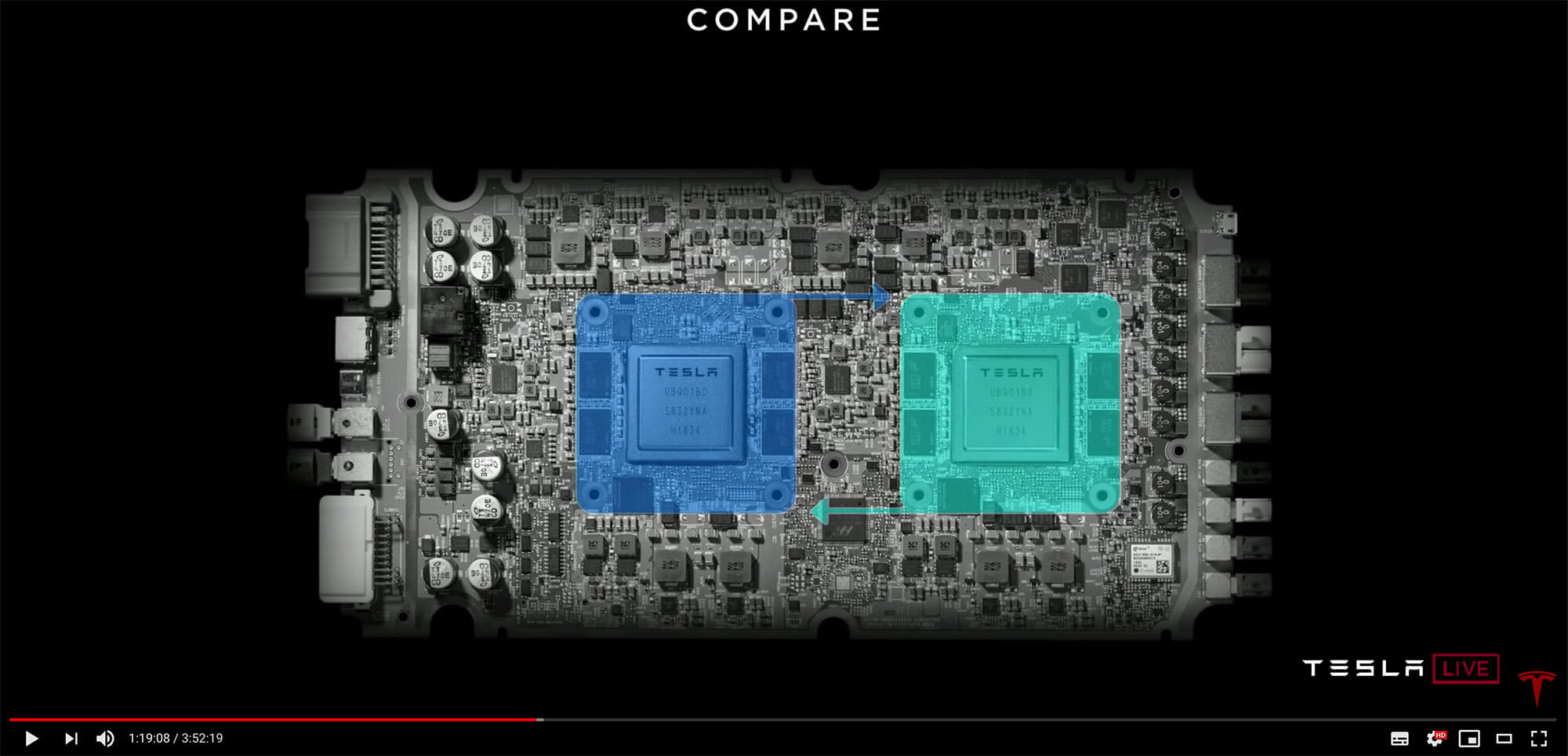

ボード上には、2個の独立したコンピューターチップが存在している。RAMやフラッシュなども別々に装備しており、別々のオペレーティングシステムをロードする。2基のコンピュータと関連するどのパーツが1つ故障しても自動運転を継続できる。

パワーサプライも二重化されている。カメラも両方のコンピュータに接続されており、同時に同じ映像を受け取って処理できる。

カメラやレーダー、GPS、地図、IMU(加速度センサー)、超音波センサー、タイヤの回転、ハンドルの角度など、さまざまな情報に基づいて完全自動運転用チップが「何をするか」計画して、2基のチップが結果を交換して確認、合意したらその計画に従って自動運転を実行する。

また、実際に運転操作を行ったら、その結果が意図したものかどうかを確認して学習する。

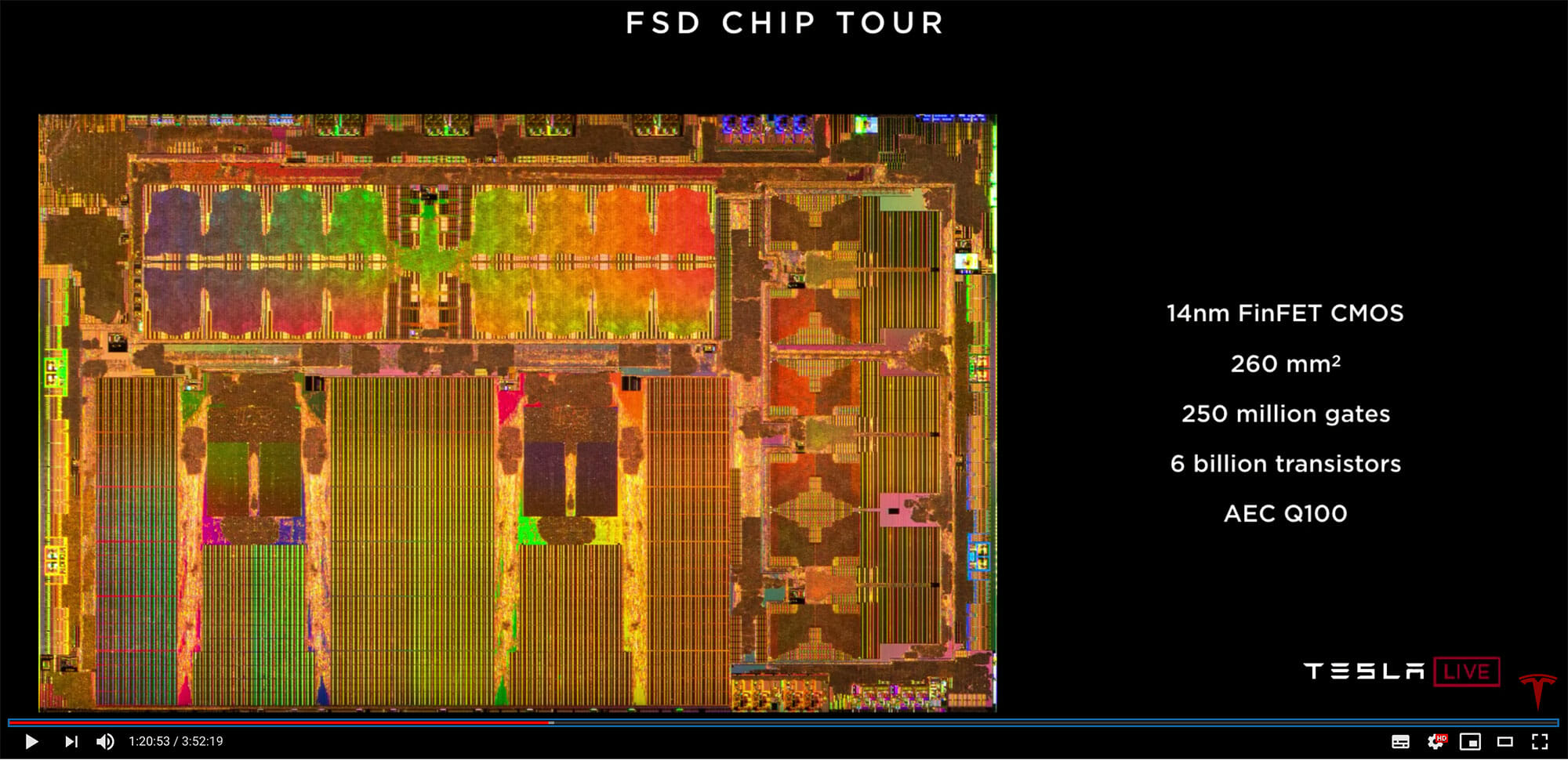

FSDチップのサイズは37.5mm×37.5mm。

スペックとしては、14nm FinFET CMOS、260立方ミリ、2.5億のゲートと、60億のトランジスタを有している。

比較すると、スマートフォンのチップは100立方ミリ程度、ハイエンドのGPU(画像処理ユニット)が600〜800立方ミリ程度なので、FSDチップはその中間くらいの規模となる。

ニューラルネットワークプロセッサーのスペックは、32MB SRAM、96×96 Multiply/Add Array、専用ReLU(正規化線形関数)ハードウェアや専用プーリングハードウェアを備えている。

ニューラルネットワークで自動運転のための情報処理を行う能力は「36TOPS(2GHz)」。これを2つセットにして1チップあたり72TOPSを得る。目標の50TOPSは超えることができた。

1GHz、600 GFLOPS、FP32/FP16のGPUも搭載。

セキュリティとして、テスラのデジタル署名のあるコードのみ実行できる。

パフォーマンスの例を挙げると、オートパイロットの狭角カメラの場合、12個のCPUを使って35GOP(Giga OPerations)1.5fps程度のパフォーマンスが出る。

600GFLOPSのGPUで35GOPのニューラルネットワークの処理を行うと17fps。今回のニューラルネットワーク・アクセラレーター(NNA)を使うと2100fpsの処理が可能になる。

開発用には、ニューラルネットワークコンパイラーも用意した。

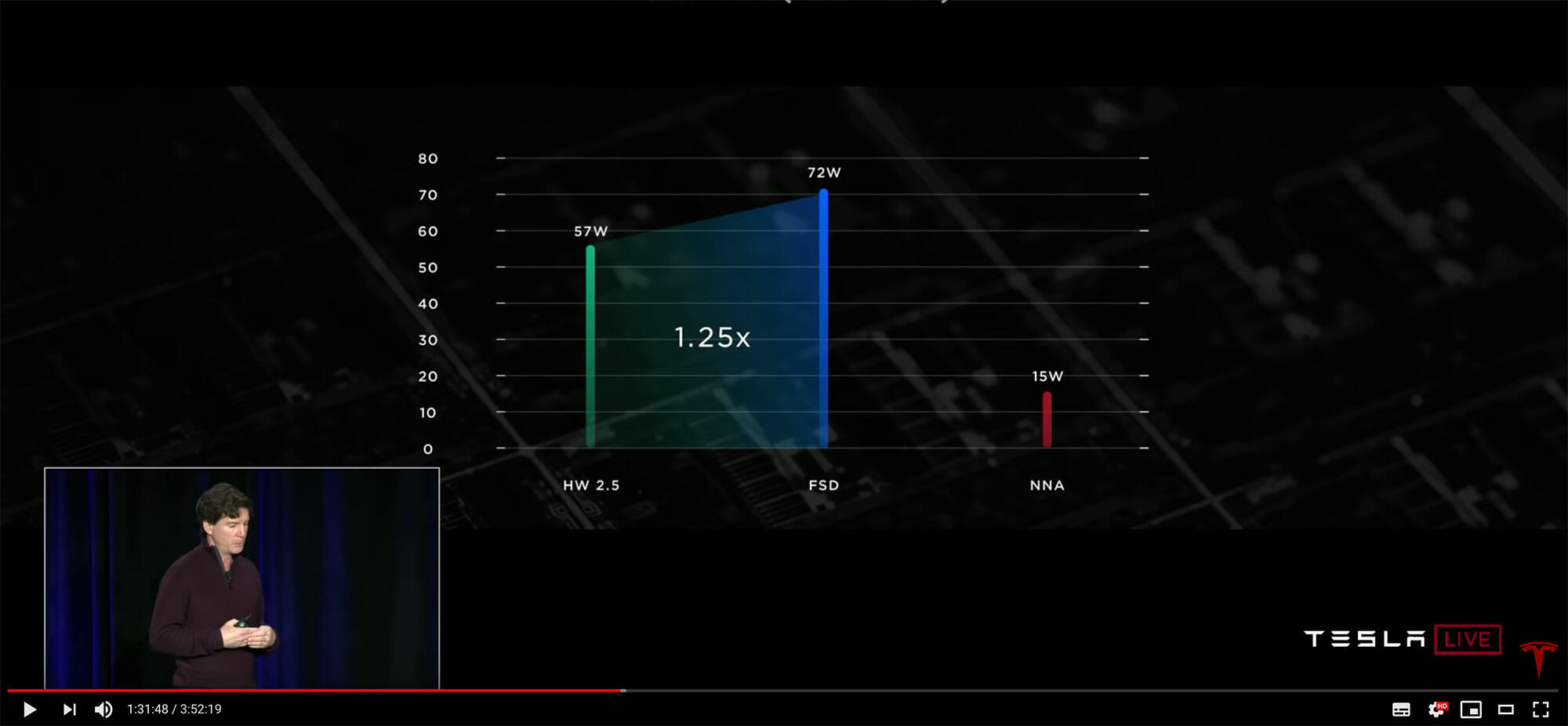

消費電力は、HW2.5が57Wであるのに対して、FSDは72W。そのうち15WがNNAの消費電力である。

コストはHW2.5に比べて約80%に抑えることができた。一方で、パフォーマンスは約21倍向上している。狭角カメラの処理速度が、110fpsから2300fpsとなっている点は、これが運命の分かれ道と言えるほど重要なポイントだ。

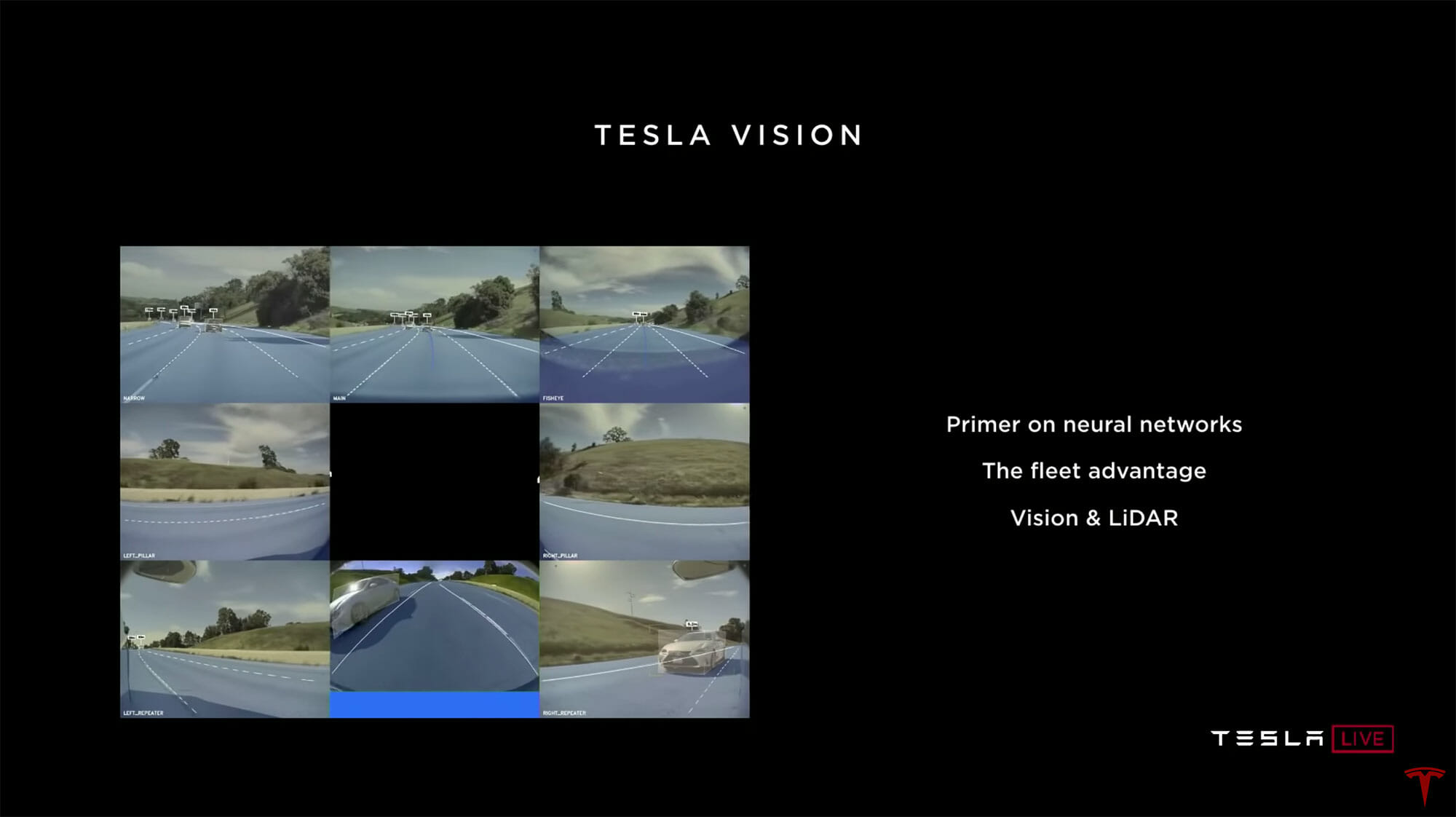

自動運転用のソフトウェアについて

続いて、ソフトウェアについてのプレゼンテーション。登壇したのはAndrej Karpathy氏。スタンフォード大学のコンピュータサイエンス学部でニューラルネットワークによる画像認識のクラス(Convolutional Neural Networks for Visual Recognition)を立ち上げたキーパーソンである。

ニューラルネットワークは、人間の脳の細胞をイメージして形成されている。もちろん、最初はまっさらで何も知らないので、画像などの情報を認識して判断するためのトレーニングには大量のデータが必要となる。

具体的には、画像データを一枚一枚ラベリングして、ニューラルネットワークに学習させていく。

夜や雨天の時のデータも必要だし、影、分岐、大きなオブジェクト、トンネル、工事なども教えていく。

データが多ければ多いほど、正確な判断ができるようになり、開発中にはシミュレーションも多用している。

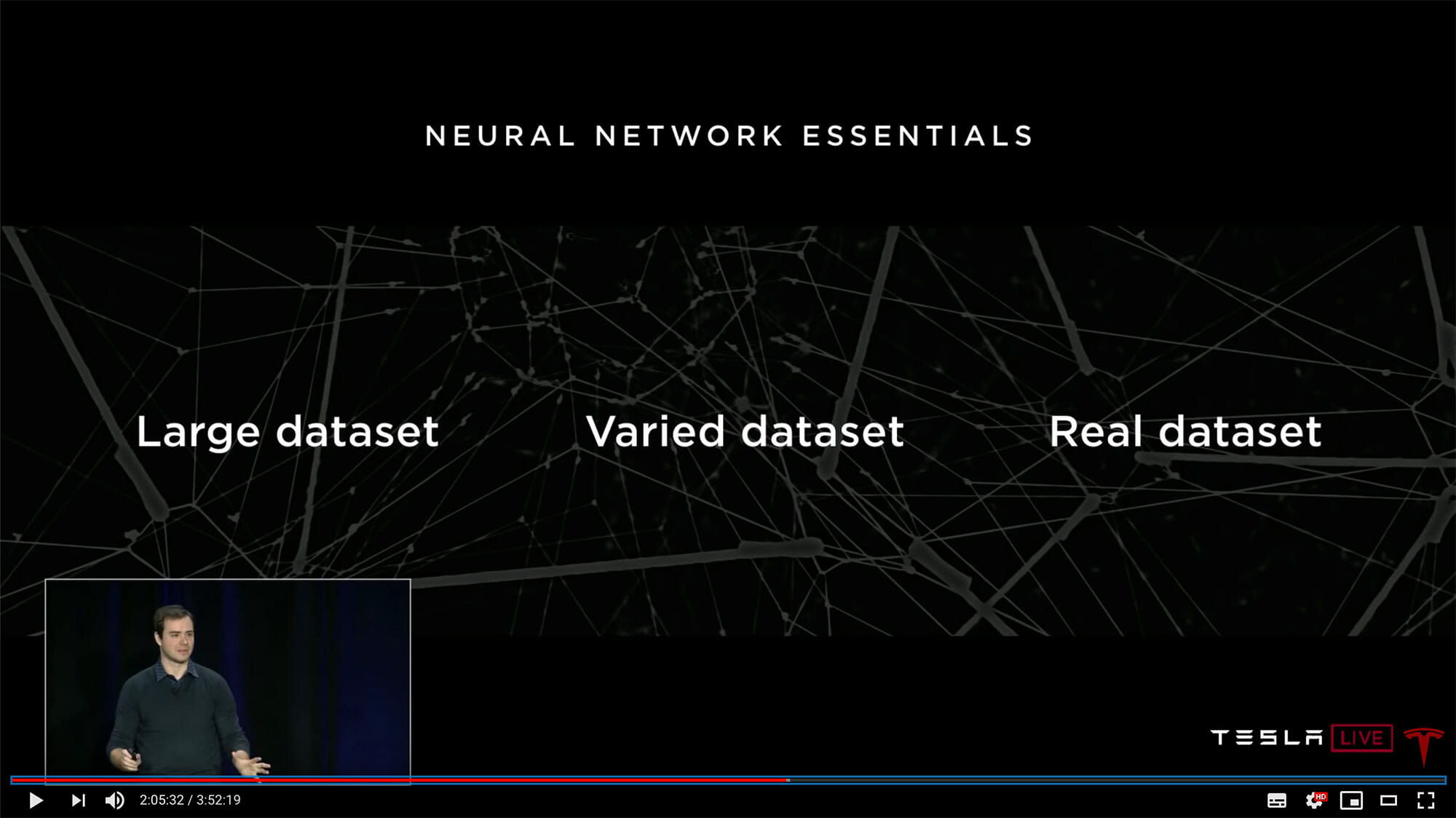

ニューラルネットワークをうまくトレーニングするには、次の3つが重要になる。

① 大量のデータセット

② バリエーションのあるデータセット

③ リアルなデータセット

こうしたデータを得るためにはフリート(艦隊の意=システムを搭載した車を走らせて多くのデータを収集すること)が必須となる。

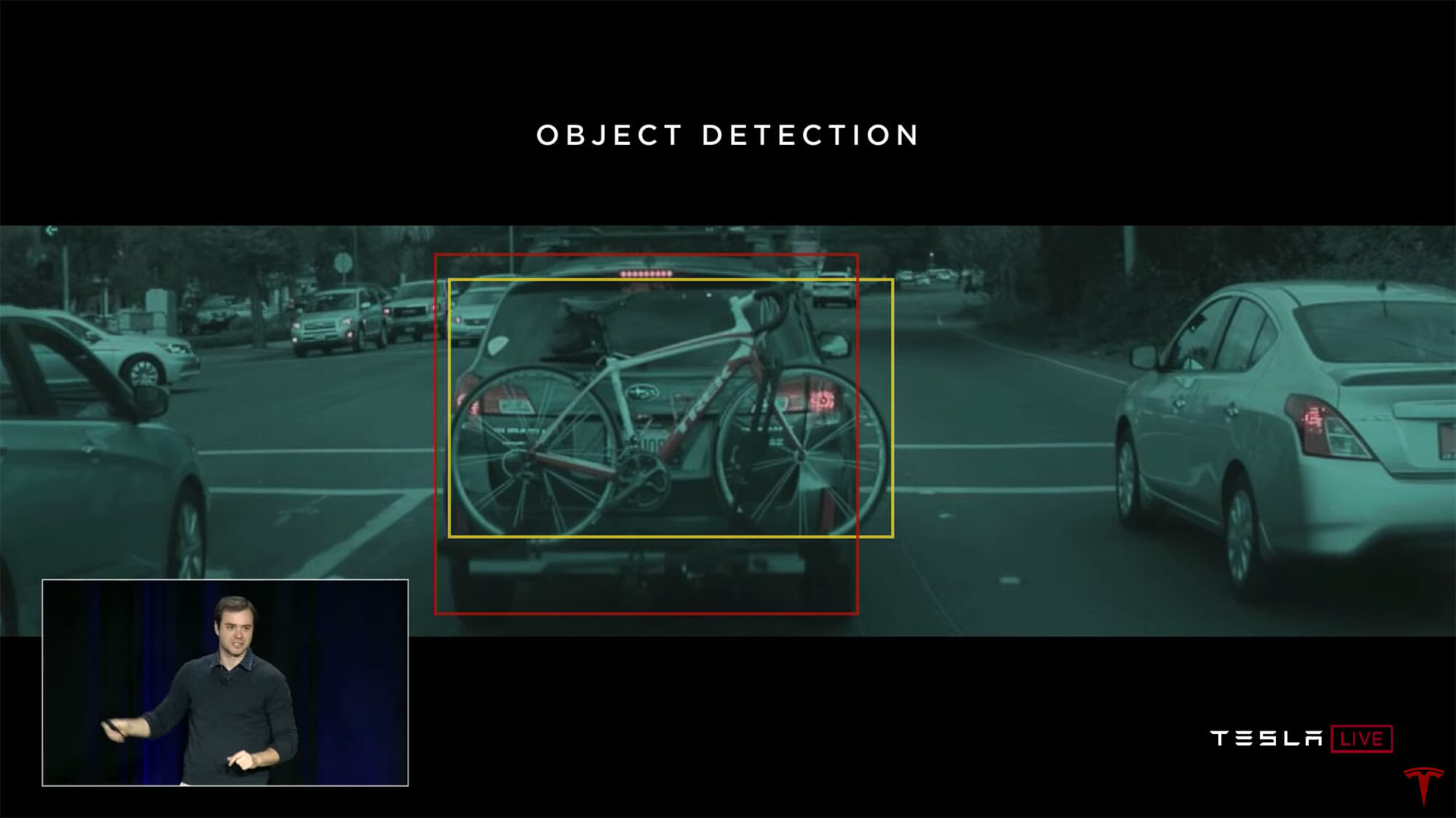

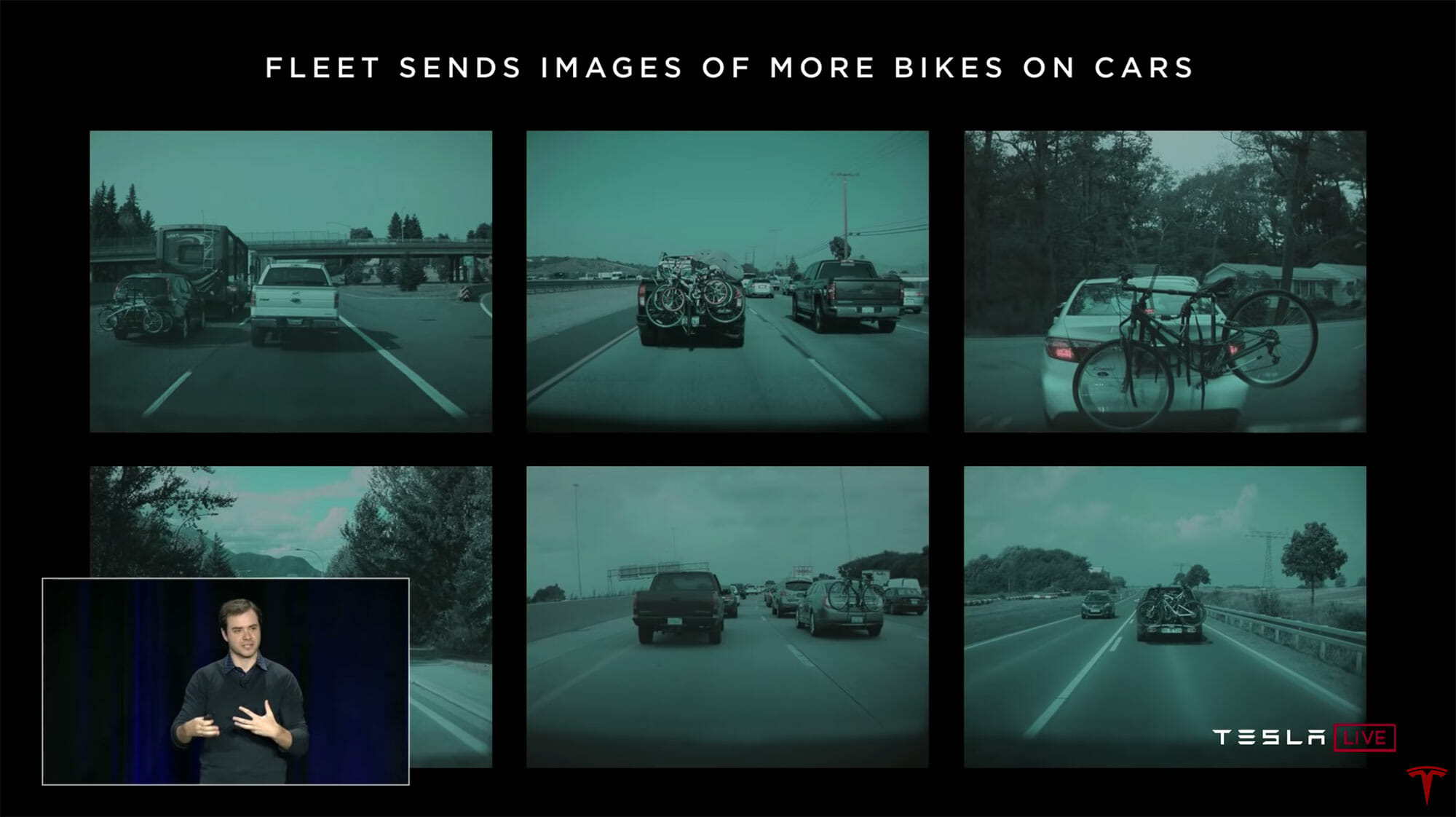

たとえば、自転車が車の後部にマウントされている写真。これを「自動車と自転車」と認識してはいけない。

似たような画像をたくさん用意して、「自動車と自転車」ではなく「一台の自動車」と認識するようにトレーニングする。そうしたトレーニングを効果的に実現するために「これに似た画像を送ってくれ」とフリートに対して行うことができる。

テスラではこれらの写真を全てラベリングしてニューラルネットワークに教えていく。すると、自転車を積んだ自動車をちゃんと1台の自動車として認識できるようになっていく。

もちろん、プライバシーには配慮している。

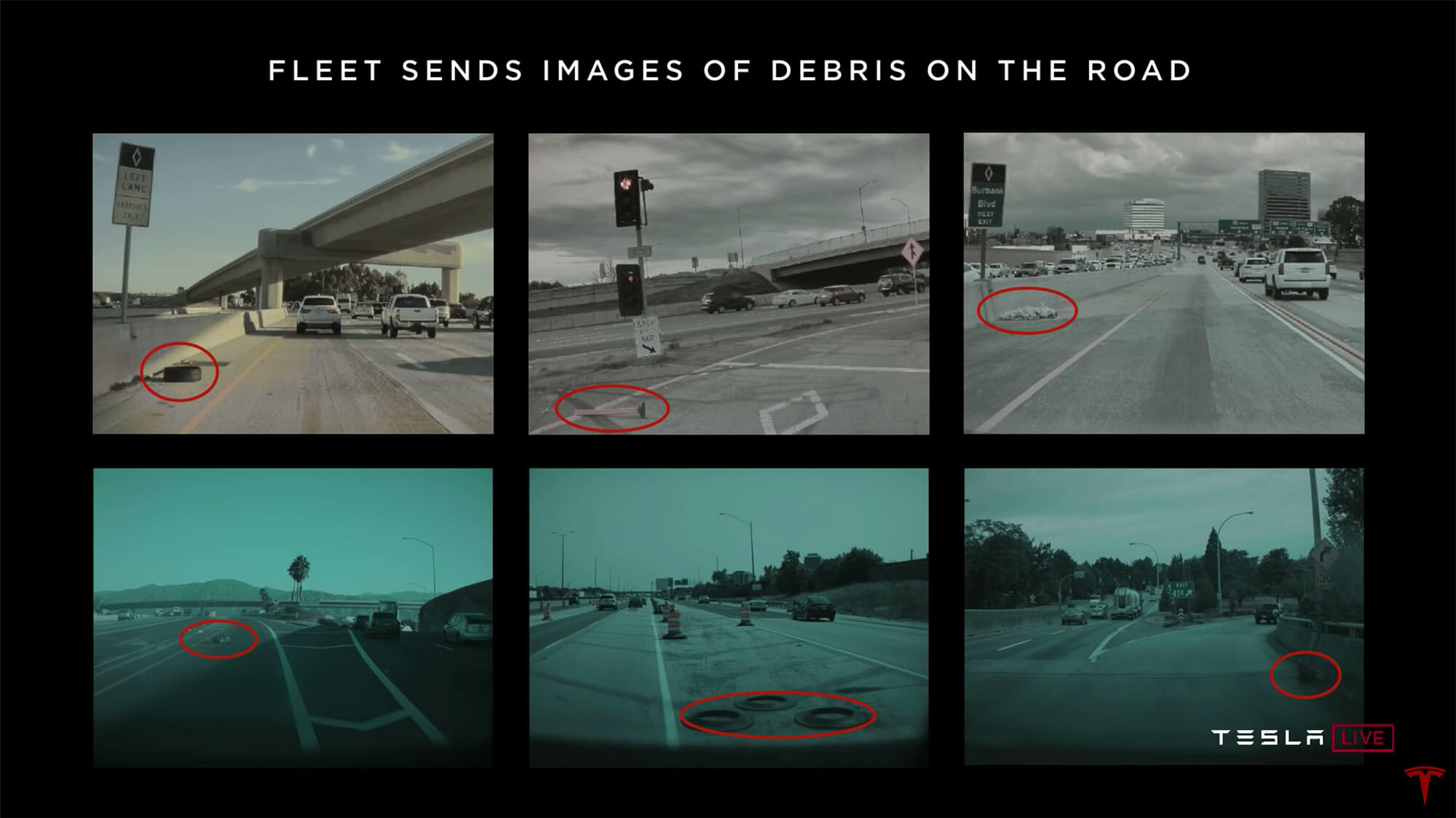

工事、道路脇にあるごみ、タイヤかす、その他落下物、コーン、ビニール袋など、さまざまなケースについてのトレーニングを行っている。

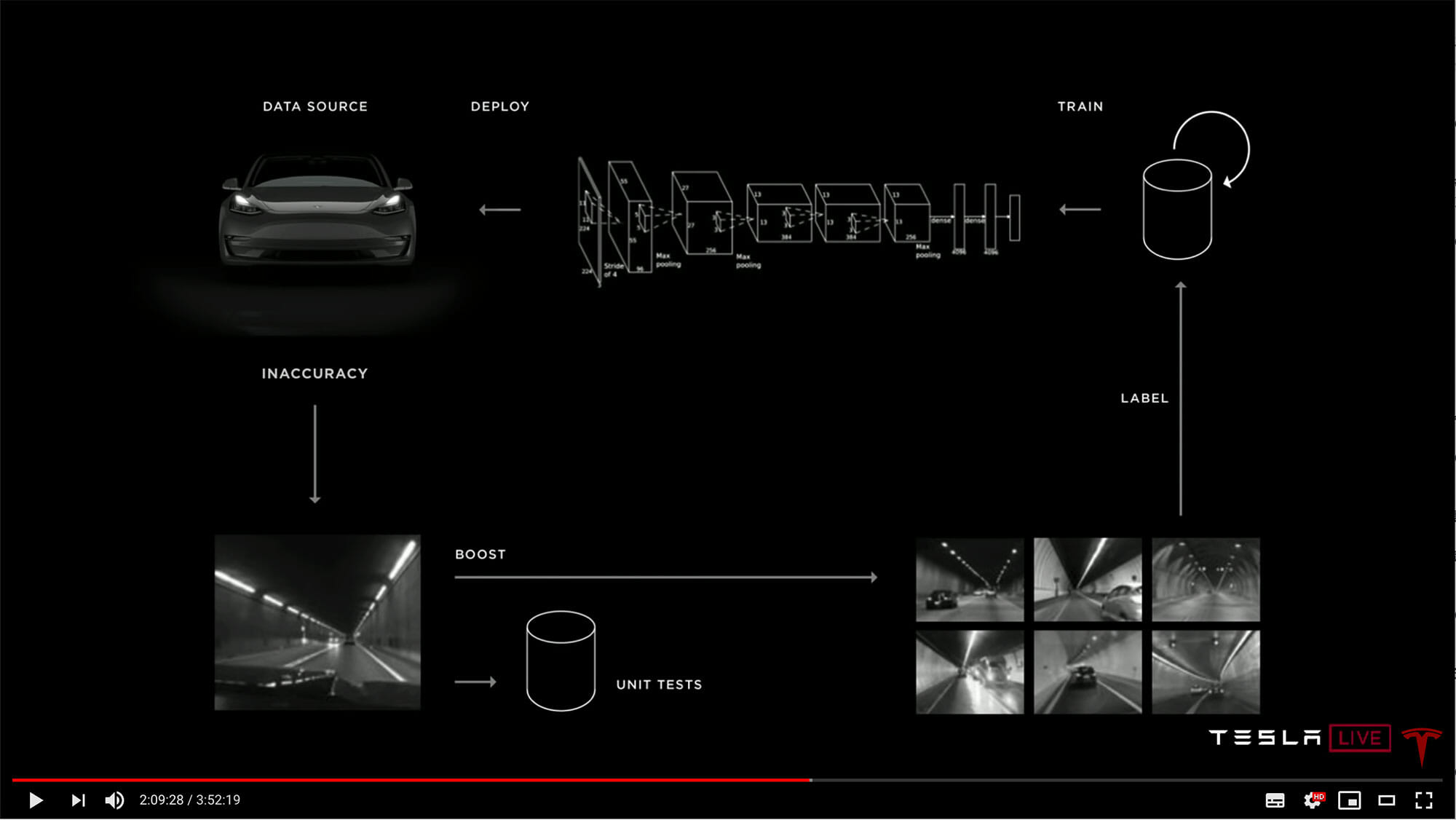

実際に車両が走行している時点で、ニューラルネットワークが判別に苦しむ物体を発見したり、運転者が自動運転をキャンセルしたような場合、それらデータを車が送信して、テスラで単体テストが実施される。

それが問題と分かれば、その後それらの似たような画像を集めて人の手でラベリングし、トレーニングを行う。

この繰り返しこそがソフトウェア開発のプロセスとなる。何度も何度も繰り返す。

フリートは自動化されたラベリングによる学習も行う。

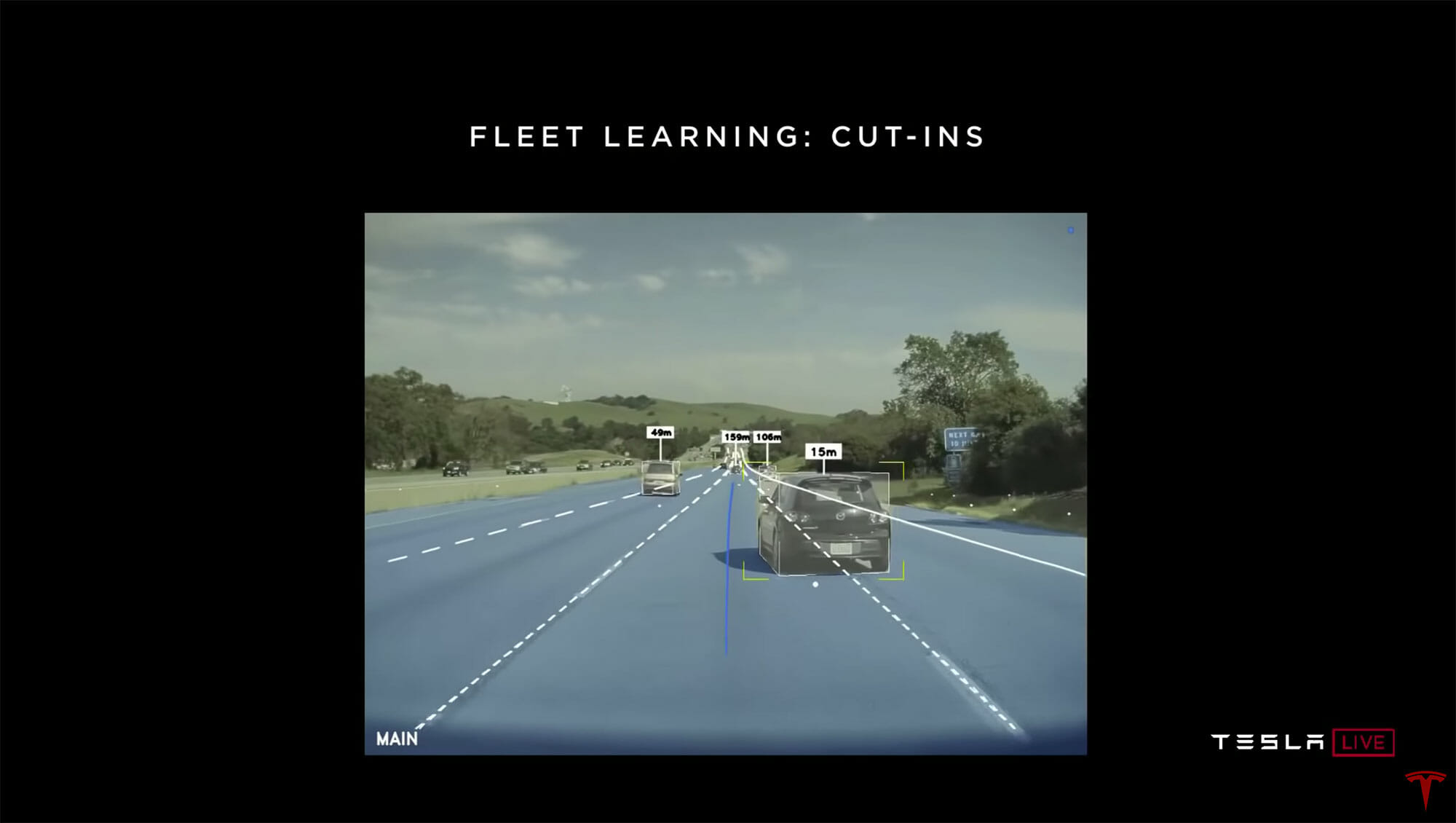

たとえば、割り込みを判定する具体例。人の手でプログラミングするのではない。前方の自動車が車線をまたいでいる前後の動画をシステムに送信し、1.3秒前の時点まで巻き戻し「この車は割り込みます」とソフトウェアがラベリングする。ウインカーがどうのこうのとかは、わざわざ人間が教えなくてもニューラルネットワークが自動で勝手に学習を重ねていく。

さらに「シャドーモード」を活用する。

先ほどのような割り込みについての学習結果は実際のシステムにデプロイ(実装)される。その上で、ニューラルネットワークが「これは割り込むぞ」と判断したが割り込まれなかった画像や、「割り込まない」と判断していたのに割り込まれた画像をフリートに要求。学習してさらに判断の精度を高めていく。

シャドーモードにおける検知漏れや判断ミスの割合が減少したら、そのシャドーモードが本番化されていく。

(イーロン・マスク氏の補足) HW2以上のシステムを搭載したテスラの車両は、すべてこのフリートラーニングに参加している。

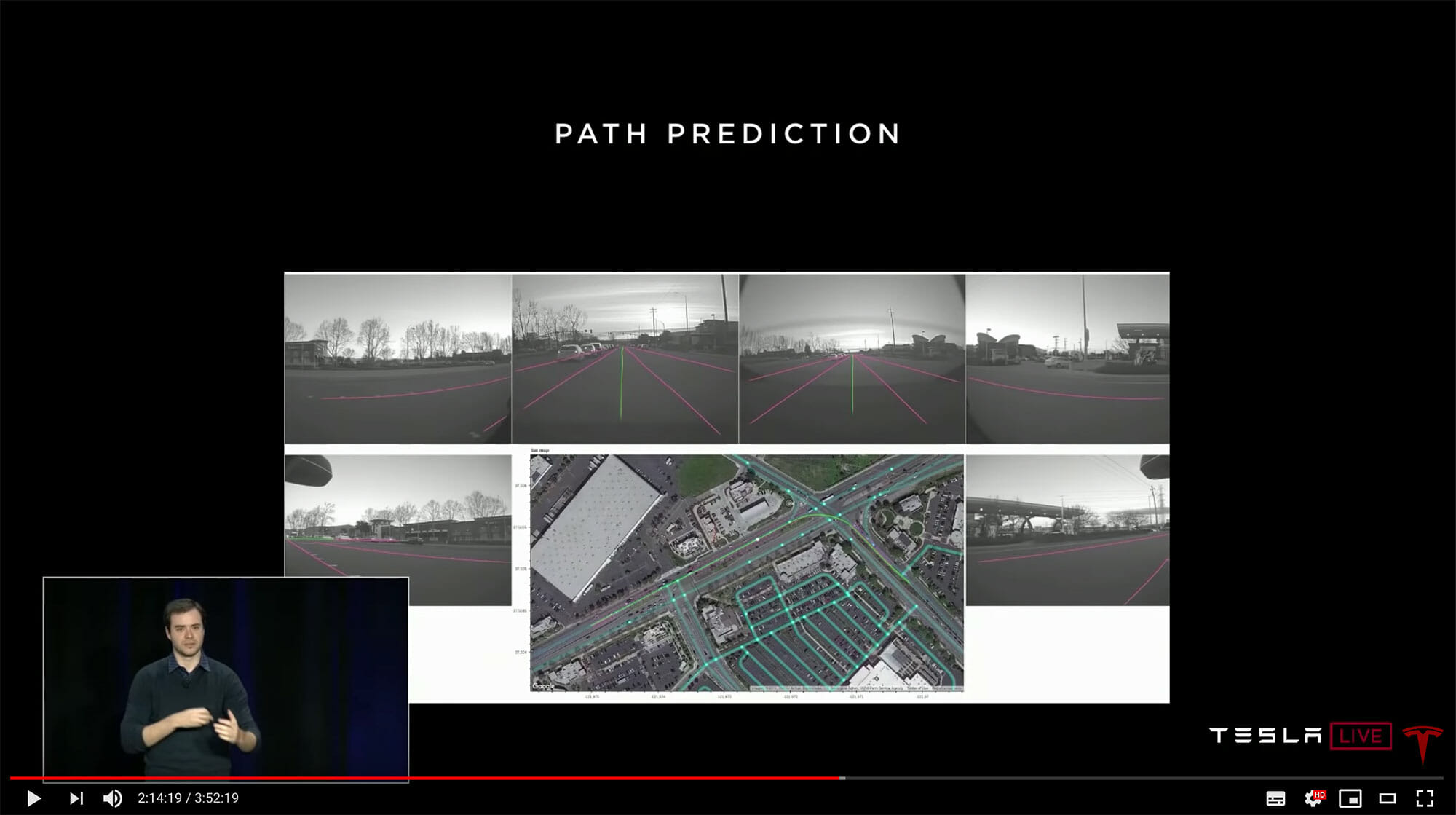

ニューラルネットワークはパス(運転する道筋)の予測も行う。道路の、実際には見えない部分も含め、3Dで予測している。

深度や距離の認知には一般的にVision(カメラ)とLiDAR(Light Detection and Ranging=レーザーによる測距システム)が使われる。

あなた方(聴衆)はここに来るときには自分の目で見ながらそれを脳というニューラルネットワークで処理しながら運転してきたわけで、目からレーザー光線を出しながら来たわけじゃない。

人間は深度や距離をVision、つまり視覚で認知している。

深度や距離を認知するには、複数の方法がある。

ひとつは、ステレオカメラのように「複数の目」をもつこと。

次に、実際の対象物の動きによる認知。多くの動物は左右に目があるため、2つの目の視野はほとんど重なっておらず、深度や距離は対象物の動きで認知している。

さらに、画像の特徴から認知する方法。たとえば、手前から遠くに向かう線路は間隔が次第に狭くなっていくように見える。

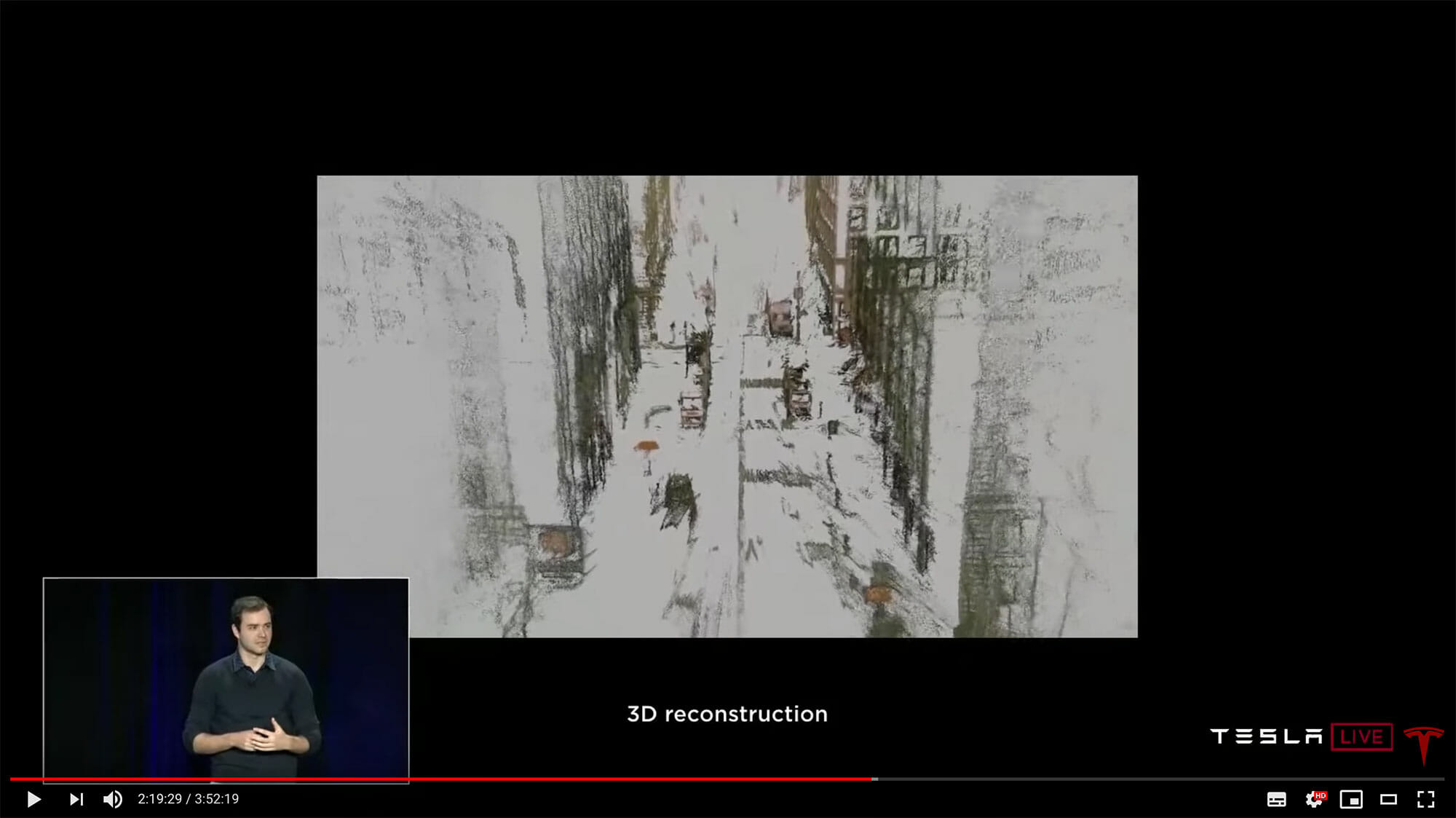

たとえば、6秒間の走行画像から、ニューラルネットワークは自車の周辺の道路や建物、他の車両などを3Dモデルに作成し直すことができる。

ニューラルネットワークは距離を認識するためのラベルがあれば距離をきちんと学習できる。たとえばレーダーで捉えた車までの距離情報で、ニューラルネットワークの画像データをアノテーション(ラベリング)すれば、ニューラルネットワークは自動的に学習し、ニューラルネットワークだけで距離を正確に測れるようになる。

走行中、ビニール袋やタイヤに遭遇した時、LiDARはいくつかのポイントを返すが、具体的にそれが何かは判断できない。Vision(カメラ)ならどんな物体なのか答えることができる。

道路上にあるすべてもの、標識や振り返っている人の向きなども含め、これらはVision(カメラ・視覚)で認識することを前提として作られている。そのためレベル4、レベル5の自動運転においては、Visionをしっかり持つことが重要である。

LiDAR(だけに頼るのは)はVisionをちゃんと実装せず、近道をしようとする手段であり、うまく行っている気がするだけで究極的には成功できない。

レベル4、レベル5の自動運転を実現するためには、上の画像のようなロングテール(特殊ケース)の状況を99.9999……%で正確に判定する必要があり、そのためには強力なVision(視覚)システムが必要だ。

多くの画像や動画が入手できればできるほど、学習の成果としてニューラルネットワークの判断はより正確になっていく。そのため、多くの車両をフリートラーニングで使える環境がレベル4、レベル5自動運転の実現のために必須である。

完全自動運転の実績は7000万マイルを突破

続いて、機械学習の専門家であるStuart Bowers氏が登壇。

テスラの Navigate on Autopilot の現状についてのプレゼンテーションを行った。

テスラ車による Navigate on Autopilot はすでに7千万マイル(約1億1千万キロ)を突破している。

次世代の自動ブレーキシステムでは、ニューラルネットワークを使って緊急ブレーキが必要になる場所に人が入ろうとした時点でブレーキをかけ始められるようになる。これは現在シャドウモードで実行されている。

こうした「アーリーアクセスプログラム」に参加している車両は数千台。

Navigate on Autopilot による、完全自動車線変更(人間の介入なし)の成功した回数は9百万回を超えた。毎日10万回以上行われている。

現時点までに事故はゼロ。

イーロン・マスク氏が思いを語る!

最後は、イーロン・マスク氏がステージ中央へ。自動運転などについてのさまざまな思いを語りました。

ロボタクシー(完全自動運転タクシー)を実現するには冗長性が重要で、完全な二重化が必要。

2016年10月以降のテスラ車両はすべてパワステが二重化されている(HW2以降)。電源ラインやデータのラインも二重化。バッテリーからの電力供給が止まっても、ハンドル操作とブレーキ操作は補助電力システムによって作動する。

HW2以前の車はロボタクシーにできない。

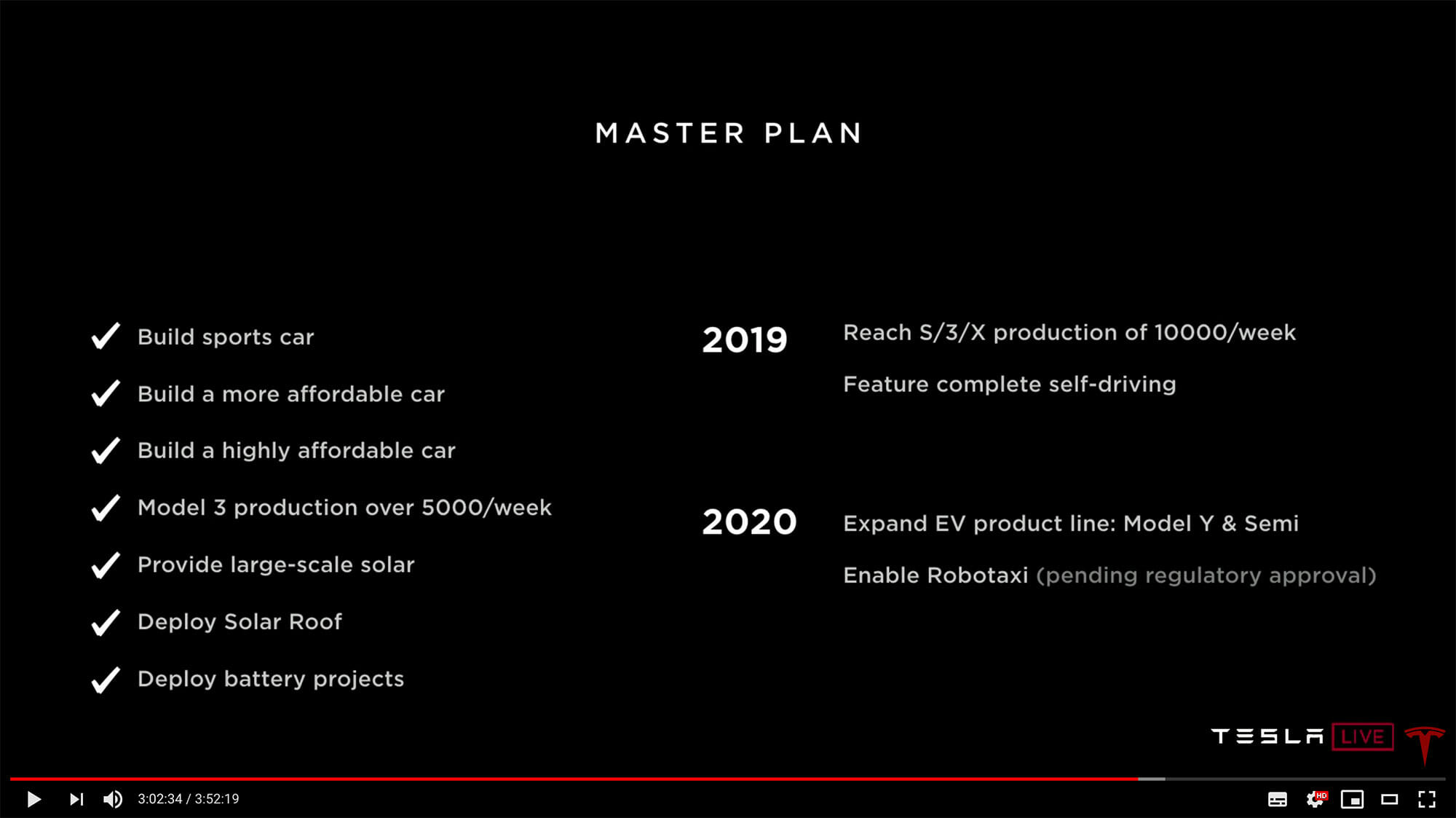

テスラのマスタープランを説明。

2019年には、モデルS/X/3を、合計で週1万台生産。完全自動運転(FSD)の機能の実装を完了する。

2020年にはモデルYとSemi(EVトラック)を発売。法整備の状況によるが、ロボタクシーを実現する。

ロボタクシーとは、ドライバーなしで走る完全自動運転タクシー。テスラネットワークによって可能となる。

テスラネットワークにはどの顧客(完全自動運転システムを搭載したテスラ車ユーザー)も参加することができて、テスラは売上の25〜30%を得る。

機能を追加したライドシェアリングのアプリによって、スマホから自分の車をテスラネットワークに参加させることができるようになる。

通常の自動車が使われているのは週に10〜12時間。したがって、少なくとも週に55〜60時間程度はテスラネットワークに参加させてロボタクシーとして活用できる。

これによって、自動車が活動する時間は5倍に増える。

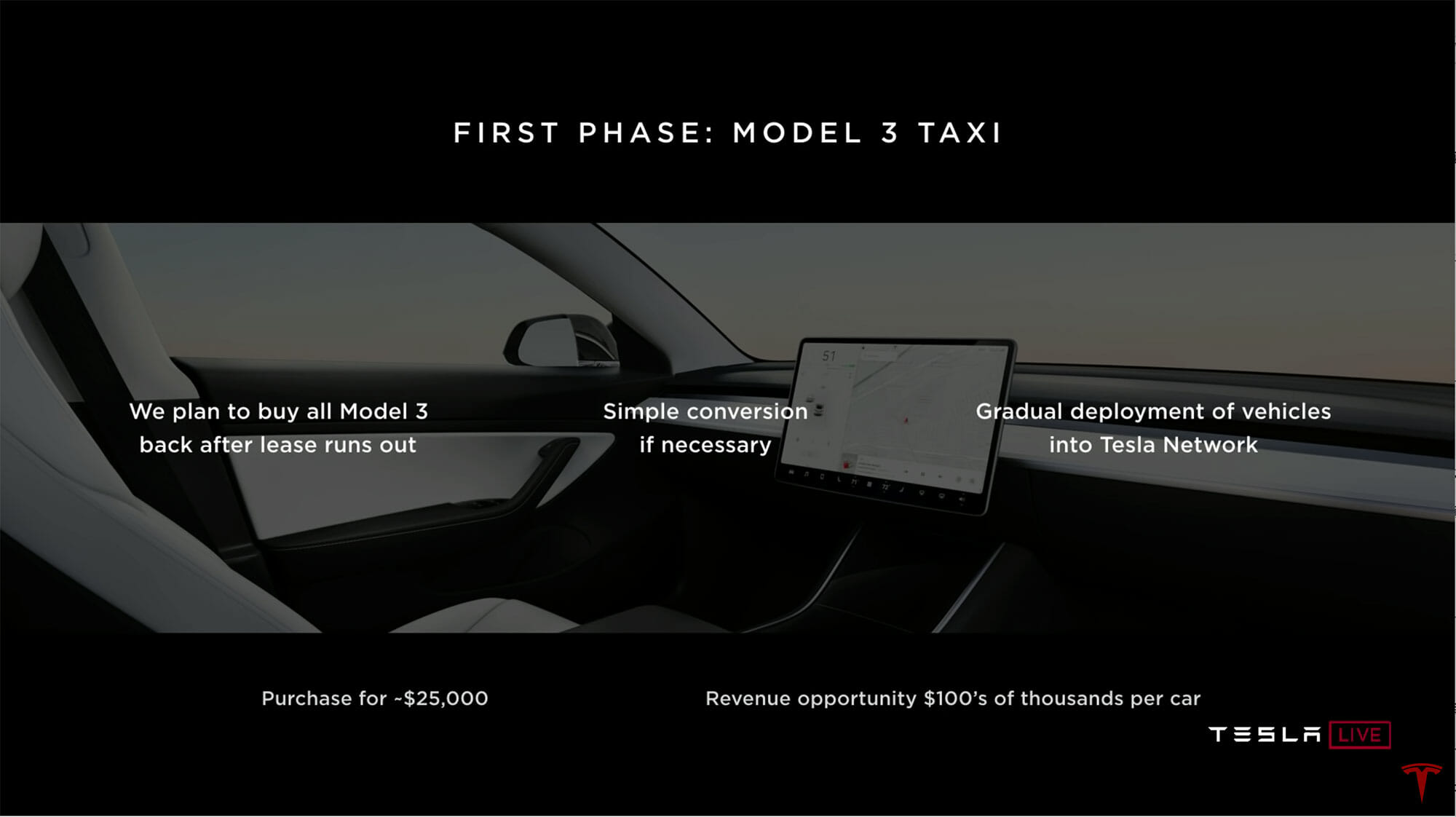

ファーストフェーズとして、まずはモデル3からスタートする。

モデル3をリースするとリース終了後に購入するというオプションは提供されず、それらはテスラがロボタクシーのためにすべて購入する。

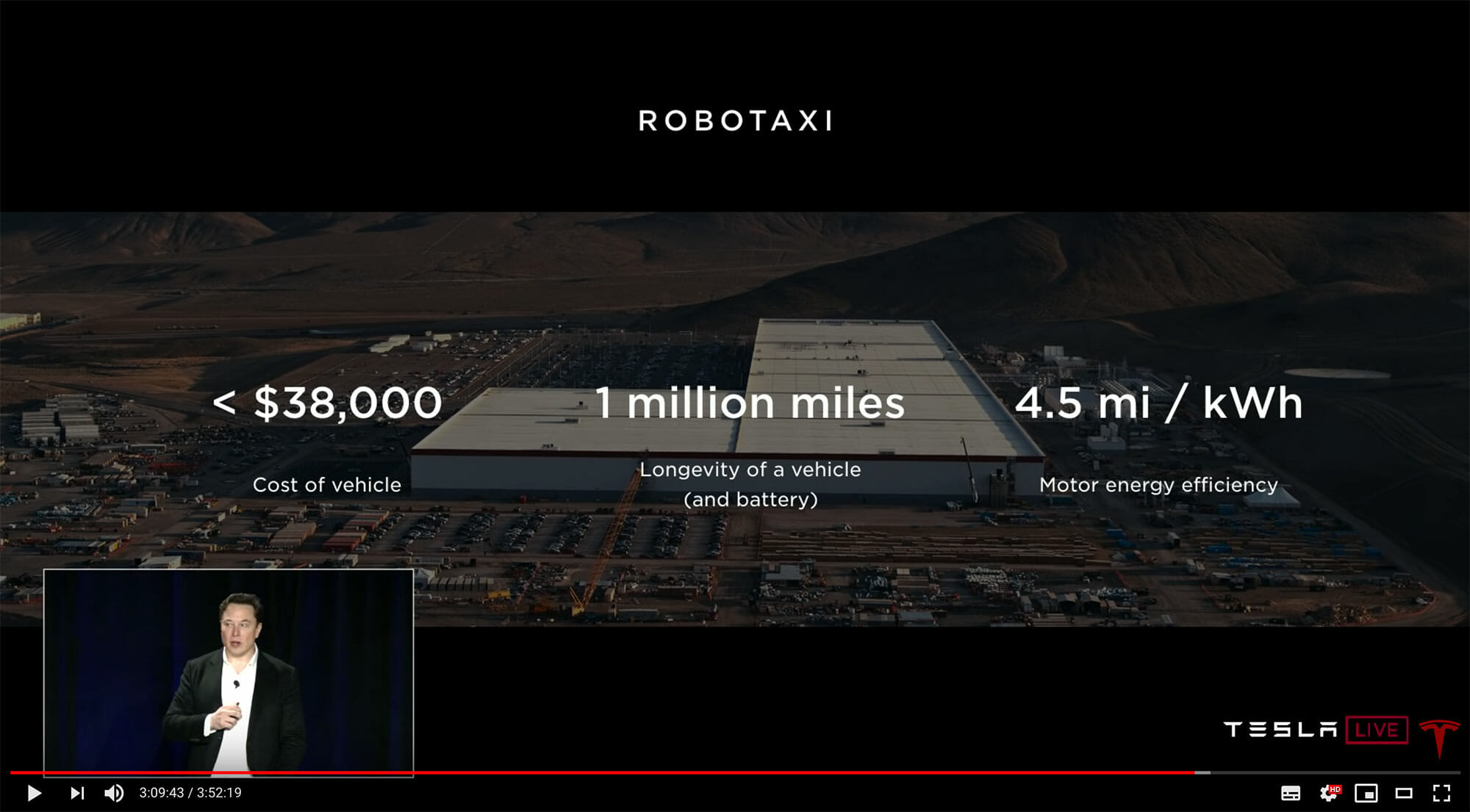

ロボタクシーのコストパフォーマンスについて整理。

車両価格は3万8000ドル以下。100万マイル(160万キロ)走行可能で、4.5mi/kWh(7.2km/kWh)とする計画である。

現在生産しているバッテリーは30万マイルから50万マイル(約48〜80万キロ)の耐久性があるが、来年生産するバッテリーは100万マイル(160万キロ)を達成する予定。

3年後にはおそらくハンドルやペダルは要らなくなるのでなくなるだろうと予測している。

そうやって部品が減れば、3年後のロボタクシーは$25000を下回る可能性もある。

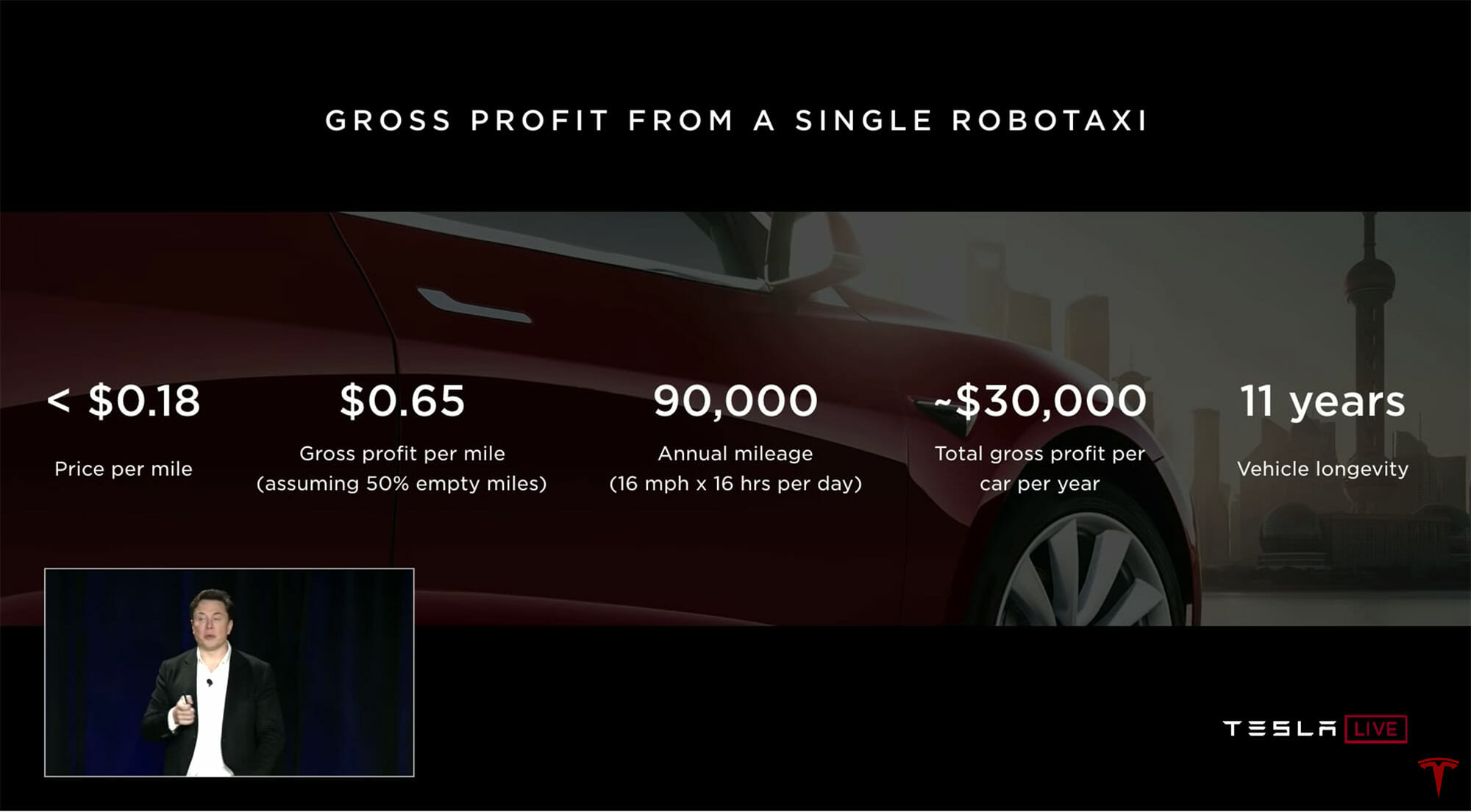

ロボタクシーによるテスラの収益は、控えめに見積もっても$0.65/マイル(50%の実車率)となる。

仮に年間9万マイルを走行させるとグロス収益は1台1年間あたり$30,000程度。車両はこのペースで11年間は使用可能。

2020年の半ばには100万台以上のFSDコンピュータを搭載したテスラ車両が走行する、つまり100万台のロボタクシーが走ることになる。

※以下、質疑応答。

自動運転の先にあるのは「ロボタクシー」が走り回る近未来

自動車を語るとき、今までは「マイカー」としての魅力や機能が中心でした。でも、今回のセミナーでイーロン・マスク氏が提示したのは、マイカーに代わり、100万台のロボタクシーが町を走る近未来です。

「絵空事」とそっぽを向く人もきっと、ほんの20年前には絵空事だと思っていたテレビ電話=スマホを使っているはずです。

電気自動車で語るべきは未来であって、過去の常識をどう置き換えるかではないということを感じる、迫力満点のセミナーイベントでした。

(EVsmartブログチーム)

EVsmart

EVsmart

ありがとうございます。

バッテリーからの電力供給が止まっても、ハンドル操作とブレーキ操作は補助電力システムによって作動する。。。とのコメントがありますが、TeslaはEVの駆動用のリチウムイオン電池と鉛電池という構成なのでしょうか?補助電力システムというのがどういうものか分からず、もし分かれば電池の構成を教えて頂けますでしょうか?

Mark T様、質問ありがとうございます。電気自動車の仕組みはこちらの記事に書いてあります。

https://blog.evsmart.net/electric-vehicles/how-electric-car-works/

こちらにバッテリーの構成についても説明しています。イーロン・マスク氏はモデルYでは12Vバッテリーをなくすと発言したことがありますが、そうなると本当に電気自動車はシンプルなものになってしまいますね。

YasukawaHiroshiさん

コメント返信ありがとうございます。

>その領域ではすでに人間の脳力を上回っていますよ。

たしかに、数をこなすという意味では、人間の能力を超えていますね。

あれだけのラベリングをあの画面数で同じように行うことは不可能ですね。

ただ、問題はラベリングするだけではないということです。

そして、ラベリングしている数が多すぎるのもむしろ問題です。

画像を認識して、動きや状態を判断し、何が危険で何が危険でないかを振り分ける能力を実現させるのが非常に厄介です。

ラベリングはどんどん増えていくでしょうが、ラベリングできないものも多数でてくるでしょうし、それらの相互関係をつなぎ合わせていく方法がよくわかりません。

現に、人間の能力を超えていて、それが、運転に十分な能力になっていれば、自動運転は、人間より運転がうまくて、事故率も低く、高速道路の分岐に突っ込んだりはしていないはずです。

比較的単純な作業を高速で行うことは機械が得意とするところですよね。

今後の発展は指数関数的に難しくなっていくでしょうから、ゴールは遠いと感じます。

>燃費が5%も悪化してしまいます。

レベル4の自動運転が実現できるのであれば、5%なんてどうでもいいと思いますよ。

だいたい、EVは暖房つけるだけで、30%くらい燃費わるくなりますし。

1kwでも10kwでもいいじゃないですか。人間と同じかそれ以上に安全な運転が手に入るなら、何kwでもいいですよ。なんなら、ガソリン車をベースにしてもいいし。

自動運転にこだわるなら、EVにこだわる必要はないです!?テスラじゃなくなってるかもw

nobubu様、コメントありがとうございます。ラベリングもそうですし、データ収集もキャンペーンを使って既存車両から自動的に集めたりなど、機械学習に与えるデータそのものの自動化も進めているとのことですので、大丈夫じゃないでしょうか。今は高速の分岐には突っ込まないですよ。データが増えていきますので、加速度的に賢くなっていくのだと思います。

電力消費については、まあ意見が違うということでよいと思います。

バッテリー価格が高額な今、燃費の悪い・もしくはバッテリーが少なく、航続距離が少ない車は売れないと言われています。1kmでも多く走行できる車が競争に生き残れると思います。研究開発的にはどれだけ電力使おうがいいのでしょうが、商品化した場合、1kWのクーラーを常時稼働させておくと音も結構しますし、10kWのクーラーでは住宅街は走行できないと思います。台数が増えない限りフリートラーニングが実現できないので、「売れる車」を作るほうが、自動運転を何とか実現するより先にある概念なのではないでしょうか。

凄いなぁ〜

今の時代に共に生きられてる事を

嬉しく感じます♬

他にどこもここまでの解説や報道なく

素晴らしい内容と思いました。

詳細を伝えて頂き、ありがとうございます

素晴らしいプリゼン内容。ハードは完成したがソフトはバージョンアップで対応ですね。致命的バグがないことを祈ります。独自開発チップの性能と消費エネルギーのEEMBCベンチマーク結果が欲しい所。

人間のブラックボックスである脳のリバースエンジニアリングは、PCのソフトウエアのリバースエンジニアリングでさえ難しいのに無理でしょう。

正確で高性能な画像処理のアルゴリズムが解明できていないです。

ハードは今後も処理能力や消費電力の改善がされていくでしょう。特に処理能力は、自動運転が実現できないので、どんどん上げていくでしょう。

ちなみに、今の段階で消費電力を気にするのは、どうでもいい話かと。

100wだろうが、500wだろうが、自動運転が実現するのであれば、大して問題ではないでしょう。

今後、常温超電導や常温核融合、3Dテレビのように自動運転のブームが去っていくと思います。

nobubu様、コメントありがとうございます!

>人間のブラックボックスである脳のリバースエンジニアリングは、PCのソフトウエアのリバースエンジニアリングでさえ難しいのに無理でしょう。

今のニューラルネットワークは人間の脳をリバースエンジニアリングして作られているわけじゃないです。画像認識くらいしかまともにできることは少ないのですが、その領域ではすでに人間の脳力を上回っていますよ。

https://www.youtube.com/watch?v=OdKA5Y7nXMY

こちらの動画は友人が作成したものですが、実際に販売されている車から内部データを取り出してビジュアライズを加えたものです。今のNVidiaベースのハードウェア(HW2)でもこのくらいのパフォーマンスが出ています。車の種類だけでなく人や自転車、バイクなどもきちんと認識しています。グリーンに塗られているところはDrivable Areaと呼ばれ、そこは走行できるという認識をしています。ETCのバーがまだ認識できていませんが、これも認識させることは可能でしょう。

>今の段階で消費電力を気にするのは、どうでもいい話かと。

テスラは現在のハードウェアで少なくともレベル3から4を実現したい(無理にしろ、人の介入をできる限り減らしたい)と考えているわけで、仮に1kWもコンピュータが消費したら、時速100kmで100km走行したとき、通常なら仮に200Wh/km x 100km = 20kWhであるところが21kWhになってしまい、燃費が5%も悪化してしまいます。また1kWhのコンピュータが消費する電力はほぼすべて熱エネルギーに変わってしまうので、結果として1000Wのストーブを真夏の車内に抱えることになります(冬はいいですね!)。これを冷却するためにはまた追加で1kWのクーラーが必要になるわけで、そうなると消費電力はさらに増えてしまいます。